操作系统

Chapter 1:Introduction

1.1 操作系统在做什么

1.1.1 操作系统的作用

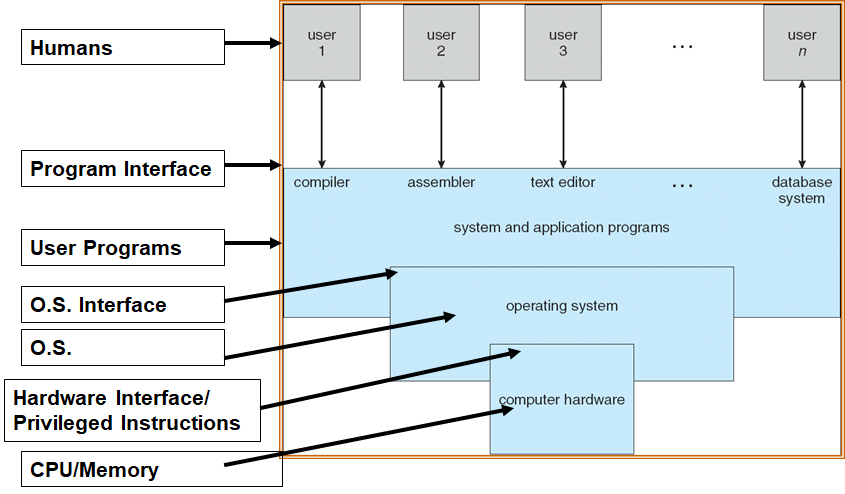

Operating System的作用:

- 作为用户与计算机硬件交互的中间层

Operating System的目标:

- 更加容易的执行/实现用户的程序

- 更加方便的使用计算机:交互

- 更有效率的使用硬件

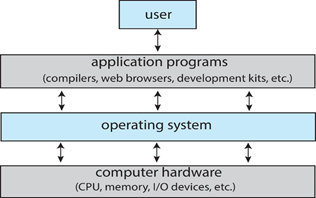

Computer System的结构:

- 硬件Hardware:提供基础的计算资源

- CPU、memory、I/O devices

- 操作系统Operating System:控制在不同程序、不同用户间的硬件的使用

- 应用程序Application

Programs:定义如何使用系统资源来解决问题

- Word processors、compilers、web browsers、database systems、video games

- 用户Users:

- People、machines、other computers

1.1.2 什么是操作系统

1.1.2.1 计算机系统组成角度:操作系统是系统软件

- 计算机系统组成:

- 软件:应用软件、系统软件(操作系统等)

- 硬件:输入/输出(I/O)设备、存储器(内存) 、中央处理器(CPU)

1.1.2.2 用户角度:操作系统是用户与计算机硬件之间接口

- Computer计算机硬件

- PC

- mainframe, or minicomputer

- mobile computers

- 操作系统提供的接口有:

- 命令级接口

- 键盘或鼠标等命令。

- Mobile user interfaces such as touch screens, voice recognition

- 程序级接口

- 它提供一组系统调用System calls ,即操作系统服务,供用户程序和其它程序调用

- 命令级接口

1.1.2.3 系统角度:操作系统是计算机系统资源的管理者

- OS是资源的分配者

- 管理所有资源

- 处理冲突的需求,有效而公平

- OS是一个控制程序

- 控制程序的执行,阻止错误、不正确的使用

1.1.2.4 软件分层、扩充机器的角度:操作系统是扩充裸机的第一层系统软件

1.1.2.5 综合考虑

操作系统是一组:有效控制和管理计算机各种硬件和软件资源,合理的组织计算机的工作流程 ,以及方便用户的程序的集合

- 有效(efficient):系统效率高,资源利用率高(如:CPU使用率,内存、外部设备是否忙)

- 合理:公平,如果不公平则会产生“死锁”或“饥饿”

- 方便(convenience):用户界面,编程接口

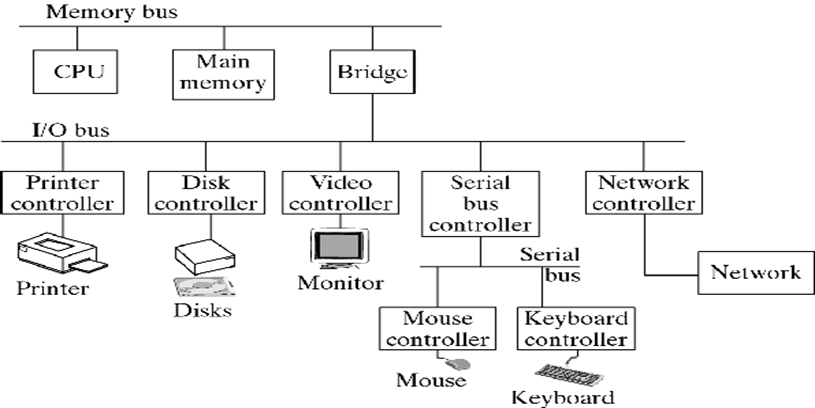

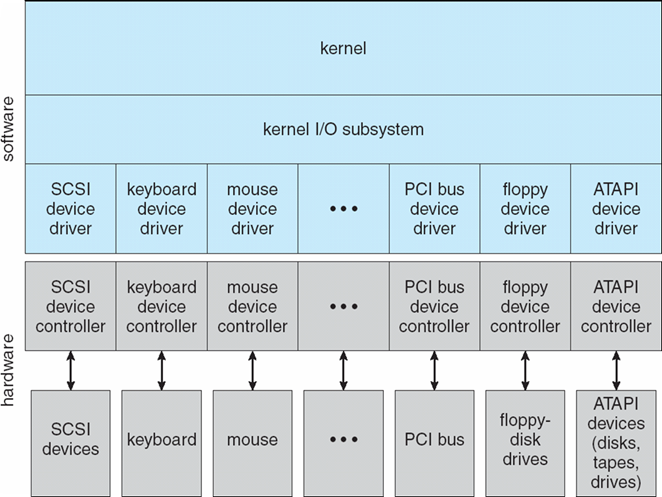

1.2 Computer System Organization

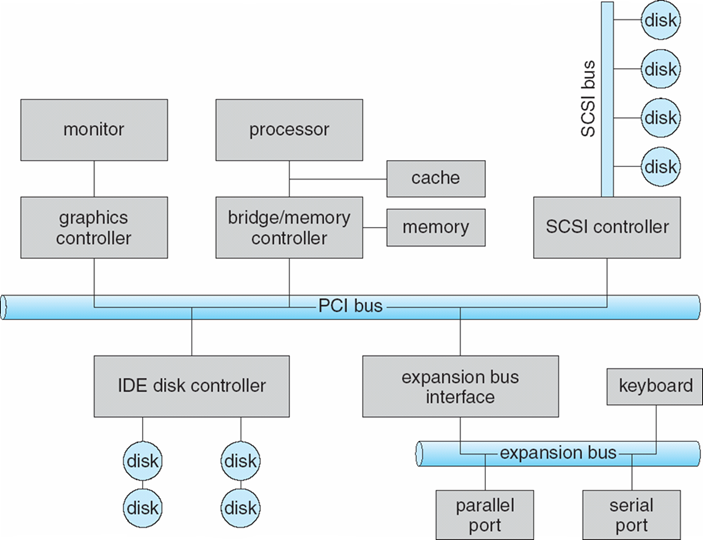

1.2.1 总线结构

总线结构:微型计算机是以总线为纽带来构成计算机系统,中央处理机(CPU)、存储器、 I/O设备(包括外存磁盘、磁带)都挂接在总线

- I/O设备和CPU可以并行运行execute concurrently

- 每一个设备控制器控制一个特定的设备

- 每一个设备控制器均有一个存储单元local buffer

- 每一个设备控制器均有一个操作系统的驱动器device driver,让操作系统管理它

- CPU在内存main memory和buffer之间进行数据的移动

- I/O本质上是device到local buffer之间的数据交互

- 设备通过提出中断interrupt的方式,告诉CPU它已经完成了操作

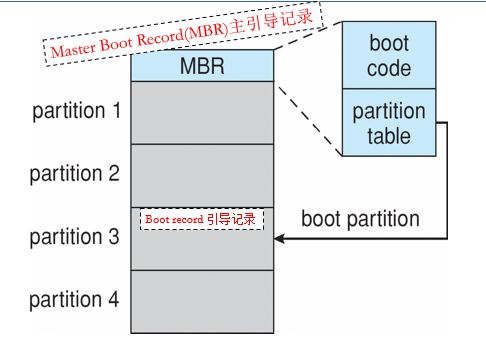

1.2.2 计算机启动 Startup

bootstrap program

- 存放在ROM/EEPROM中,也被称为firmware

- 在电源启动/重启的时候,这个程序被加载到内存中

- 会初始化操作系统的必须部分

- 然后将操作系统加载到内存中,开始执行

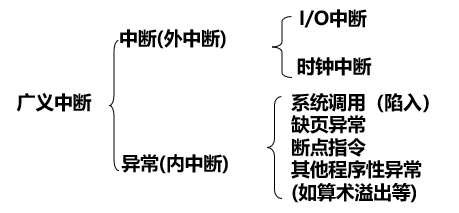

1.2.3 中断

中断(Interrupt):指系统发生某个异步/同步事件后,处理器暂停正在执行的程序,转去执行处理该事件程序的过程

- 硬件中断

- 软件中断:陷入(trap)

操作系统是中断驱动的interrupt driven

外部中断(interrupt),异步中断:

- 外部设备所发出的I/O请求

- 分为可屏蔽的和不可屏蔽的两类,由一些硬件设备产生,可以在指令执行的任意时刻产生

异常(exception),内部中断,同步中断:

- 由正在执行的进程产生,一条指令终止执行后才会发出中断

- 常见的异常有除零、溢出及页面异常(fault出错)等。另一种情况是使用int指令(trap陷入),Linux使用该指令来实现系统调用。 fault与trap区别

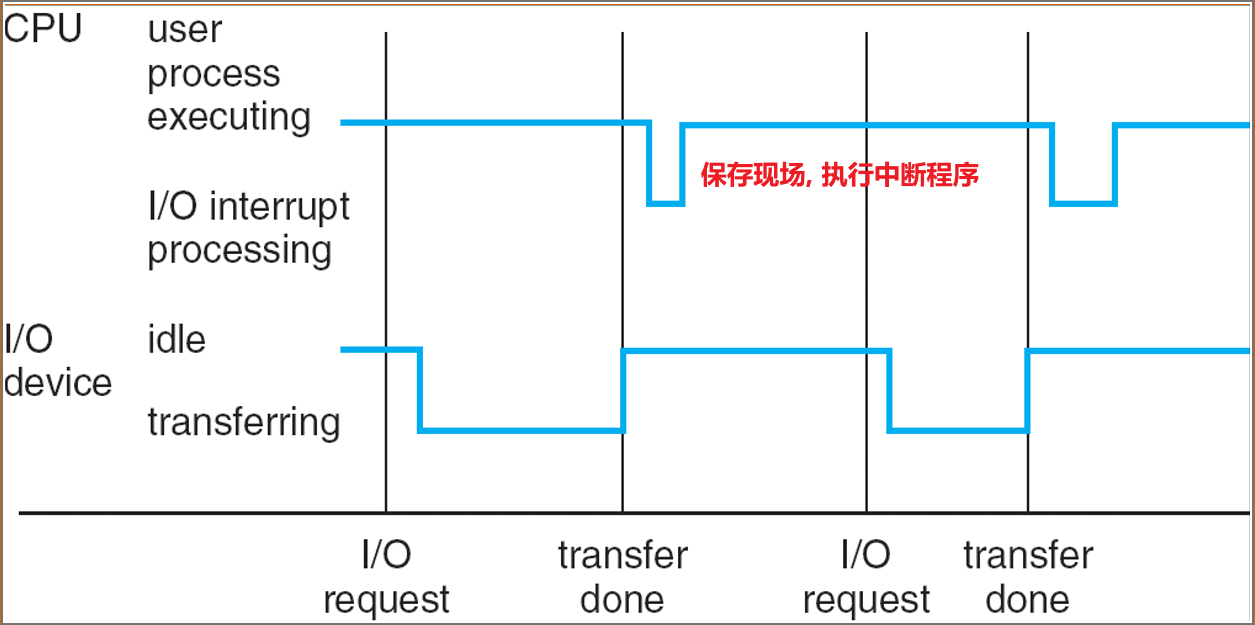

中断处理

- 操作系统保存当前CPU状态:存储register、PC(program counter)

- 判断发生了哪一种中断:

- Polling:轮询

- Vectored interrupt system:向量化中断系统

- 单独的代码段决定了每种类型的中断应采取的操作(中断服务程序)

Interrupt Time line

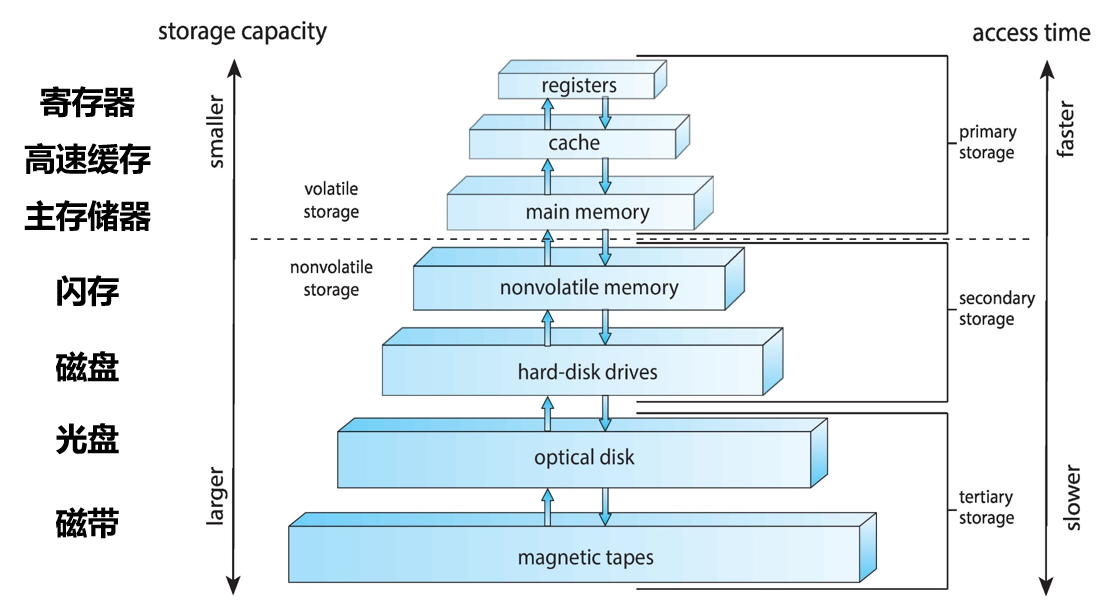

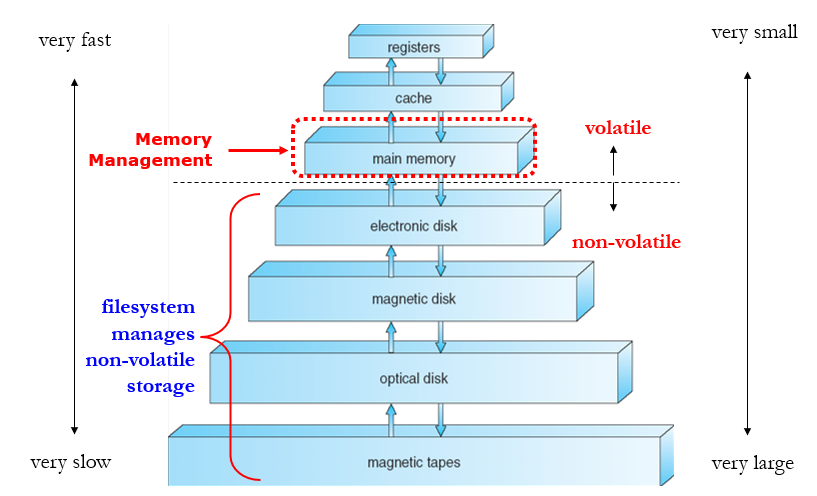

1.2.4 存储结构

Main Memory(主存)

- CPU能够直接访问的最大存储空间

Secondary Storage(赋存)

- 主存的拓展,提供大量非易失型的存储空间

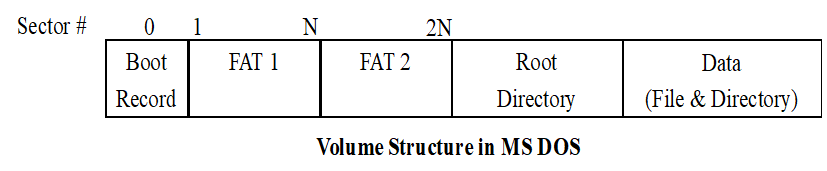

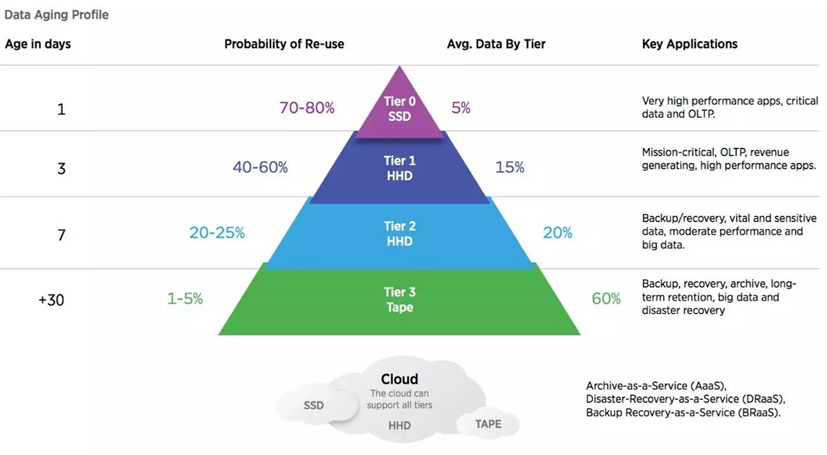

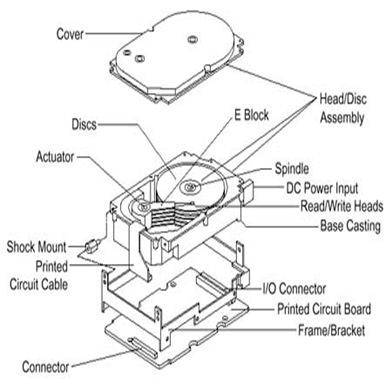

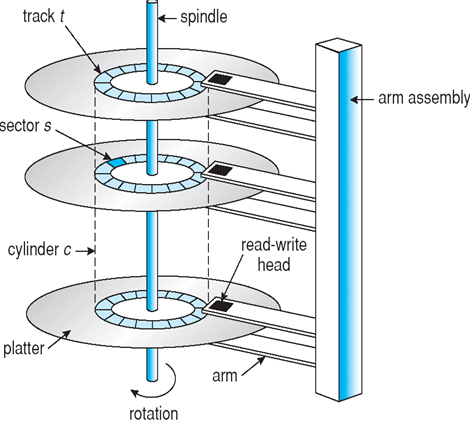

Hard Disk Drives(HDD, 硬盘):

- 覆盖有磁记录材料的刚性金属或玻璃盘

- 磁盘表面按逻辑划分为磁道,磁道又细分为扇区

- 磁盘控制器确定设备和计算机之间的逻辑交互

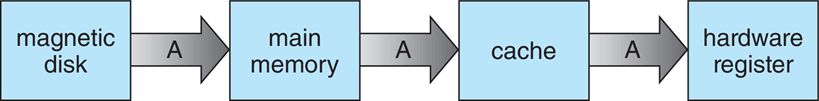

Caching(高速缓存技术):将信息复制到更快的存储系统中

- Main Memory可以被视为Secondary Storage的一个缓存(cache)

- 重要原理:在计算机(硬件、操作系统、软件)的多个级别执行

- 正在使用的信息临时从较慢的存储复制到较快的存储

- 更快的存储(缓存)首先检查,判断信息是否存在

- 如果是,则直接从缓存中使用信息(fast)

- 如果不是,则将数据复制到缓存并在其中使用

- 缓存小于正在缓存的存储

- 缓存管理是一个重要的设计问题

- 缓存大小和替换策略

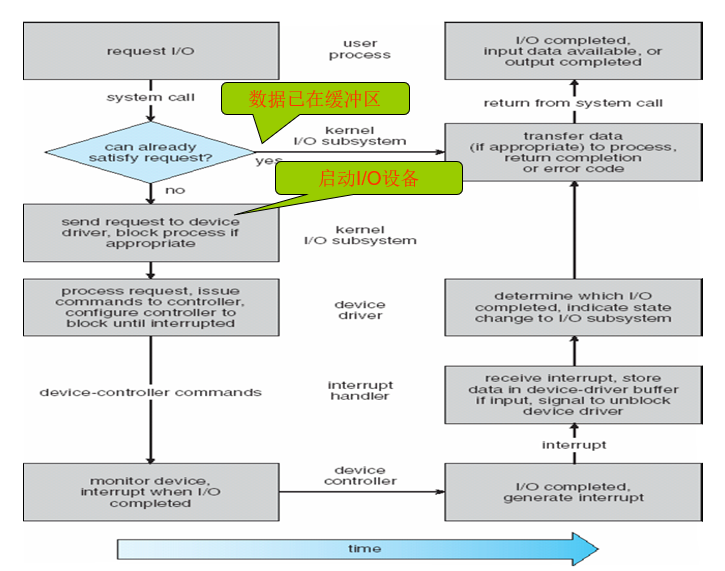

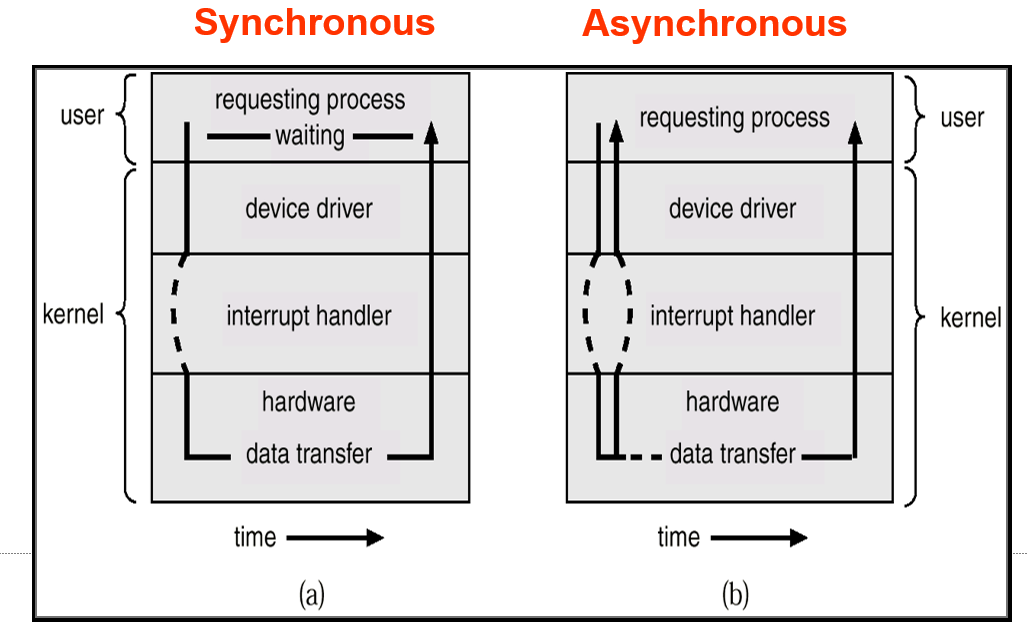

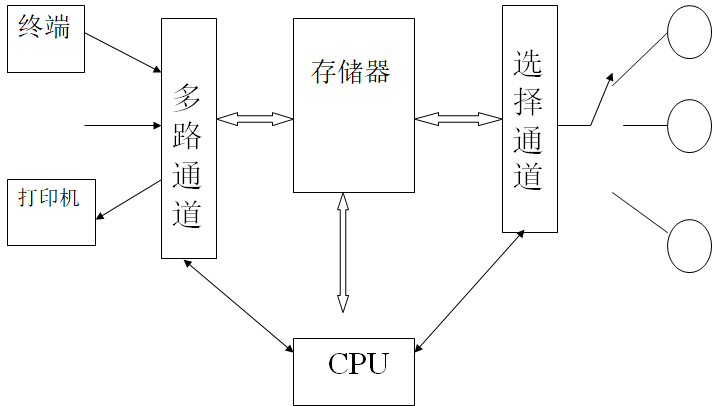

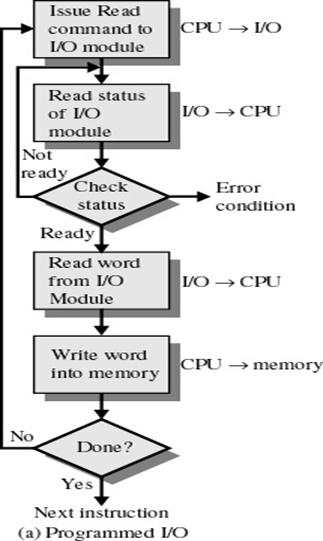

1.2.5 IO结构

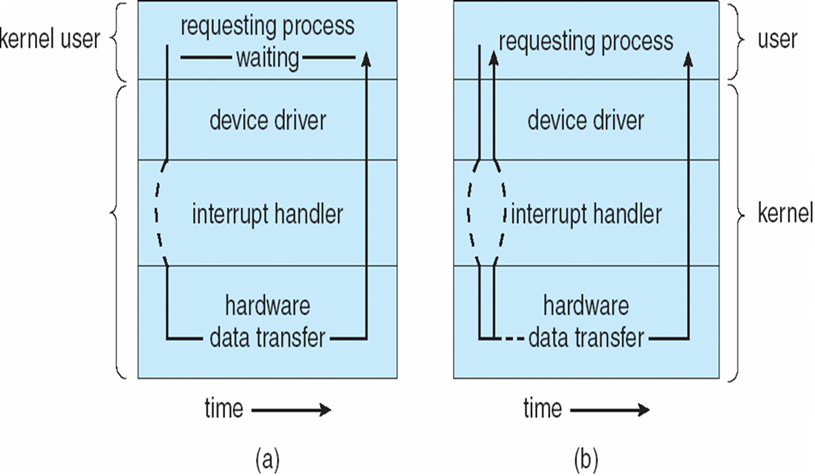

I/O方式:

程序I/O (Programmed I/O)

中断 I/O (Interrupt I/O)

- 同步I/O:IO开始后,控制权只有当IO结束才会返回给程序

- 异步I/O:IO开始后,控制权立即返回给程序

- 设备状态表Device-status table:包含每个I/O设备的条目,指示其类型、地址和状态

- 操作系统索引到I/O设备表中,以确定设备状态并修改表条目以包括中断

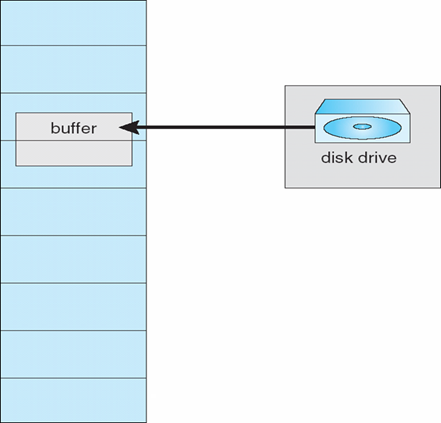

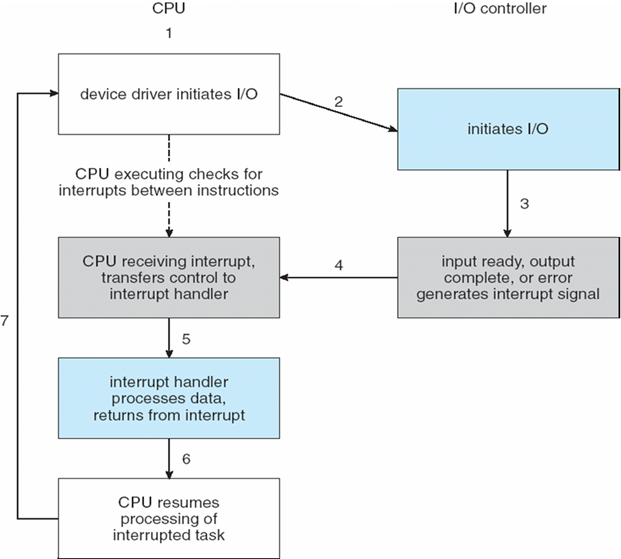

DMA方式:Direct Memory Access Structure直接内存访问

- 用于能够以接近内存速度传输信息的高速I/O设备

- 设备控制器将数据块从缓冲存储器直接传输到主存储器,无需CPU干预

- 每个块只生成一个中断,而不是每个字节一个中断

通道方式

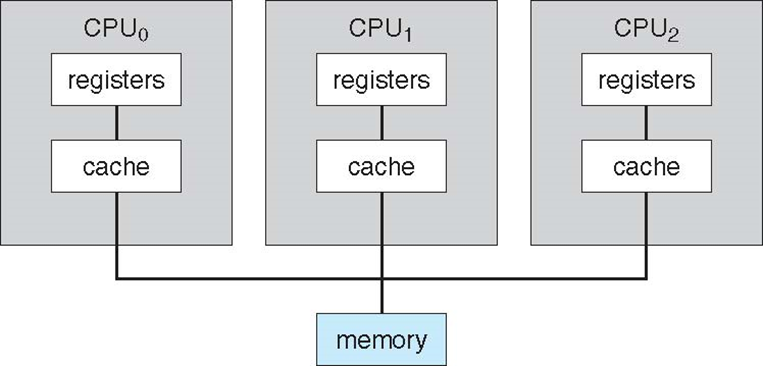

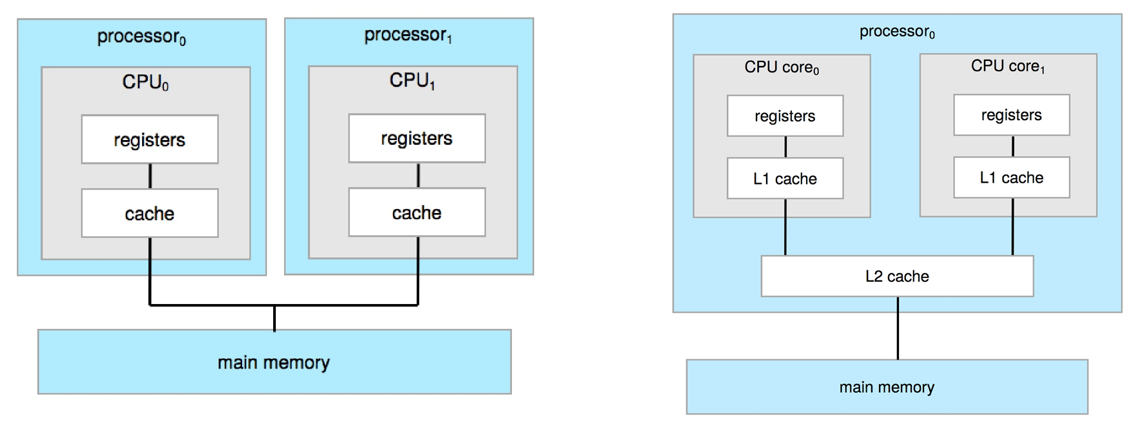

1.3 Computer System Architecture

1.3.1 单处理器系统

- 只有一个CPU和一个计算单元

1.3.2 多处理器系统

- Multiprocessor Systems多处理器系统:也称为并行系统parallel systems、紧密耦合系统tightly-coupled systems

- 优点:

- 增加吞吐量

- 规模经济

- 提高可靠性——性能下降或容错

- 两种类型:

- 非对称多重处理

- 对称多重处理

Multi-processor(多个芯片) and multicore(多核)

- System(系统)包含所有的芯片

- Chassis(主板)包含多个独立的处理器

1.3.3 计算机系统组件的定义

- CPU:执行指令的硬件

- Processor处理器:包含一个或多个CPU的物理芯片

- Core核:CPU里面最基本的计算单元

- Multicore多核:在一块CPU里面有多个计算单元

- Multiprocessor多处理器:包含多个处理器

1.3.4 Clustered Systems集群系统

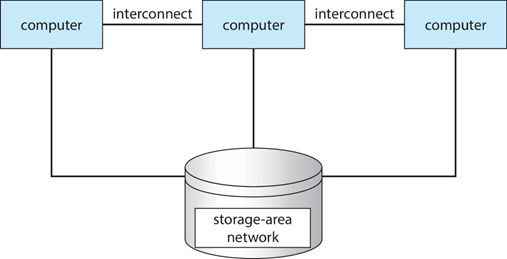

集群系统(Cluster) :是由一组互联的主机(节点)构成统一的计算机资源,通过相应软件协调工作的计算机机群,给人以一台机器的感觉

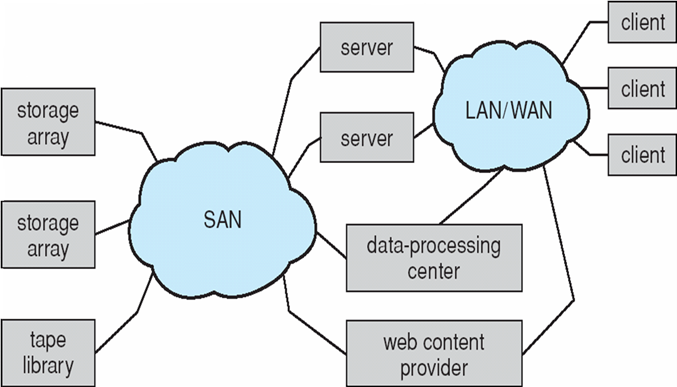

通常通过存储区域网络(storage-area network,SAN)共享存储

提供高可用性(high-availability)服务,可在故障中生存

- Asymmetric clustering(非对称集群):有一台机器处于热备用模式

- Symmetric clustering (对称集群): 有多个运行应用程序的节点,相互监视

一些集群用于高性能计算(HPC,high-performance computing)

- 必须编写应用程序以使用并行化(parallelization)

一些具有分布式锁管理器(DLM分布式锁管理器) 避免冲突操作

其他形式的集群:并行集群、WAN上的集群

集群技术正在迅速变化

- 一些集群产品支持集群中的数千个系统,以及相隔数英里的集群节点

- Storage-Area Network,SAN,存储区域网

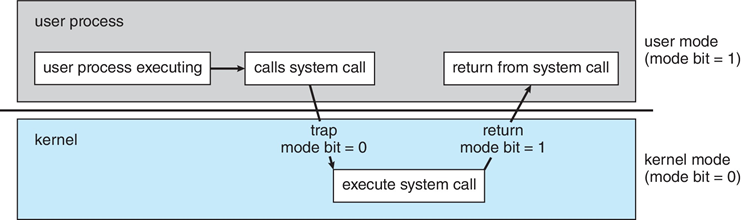

1.4 Operating System Operations操作系统的执行

- 硬件驱动的中断

- 软件错误或请求创建exception(异常) 或trap(陷入)

- 除以零,请求操作系统服务

- 其他进程问题包括无限循环、进程相互修改或操作系统

1.4.1 两种操作模式:

- User mode(用户态):执行用户程序时

- 只能访问属于它的存储空间和普通寄存器,只能执行普通指令

- 用户程序以及操作系统核外服务程序运行在用户态下

- 使用用户栈

- 非特权指令:用户程序中所使用的指令

- Kernel mode(内核态):执行操作系统程序时

- 也称为:monitor mode管态、system mode系统态、supervisor mode管态 、privileged mode特权模式

- 能够访问所有系统资源,可以执行特权指令,可以直接操作和管理硬件设备

- 操作系统内核程序运行在内核态下

- 使用内核栈

- 特权指令:不允许用户程序中直接使用的指令。例如:I/O指令、设置时钟、设置控制寄存器等指令都是特权指令

1.4.2 Timer(定时器):防止无限循环/进程占用资源

- 在特定时间段后设置中断

- 操作系统递减计数器

- 当计数器为零时,生成中断

- 在调度进程之前设置,以重新控制或终止超过分配时间的程序

1.5 Resource Management资源管理

- 进程管理 Process Management

- 主存管理 Main Memory Management

- 文件系统管理 File-System Management

- 大容量储存管理 Mass-Storage Management

- 高速缓存管理机制 Caching

- I/O系统管理 I/O System Management

1.5.1 进程管理

- 进程Process:所有处于执行中的程序

- 进程是一个最基本的单元

- 不同进程之间可以共享一些数据,但不会相互依赖

- 程序是passive entity(静态实体),进程是active entity(活动实体)

- 进程需要获得一些资源以完成任务

- CPU、内存、IO、文件、初始化数据

- 进程终止需要回收任何可重用资源

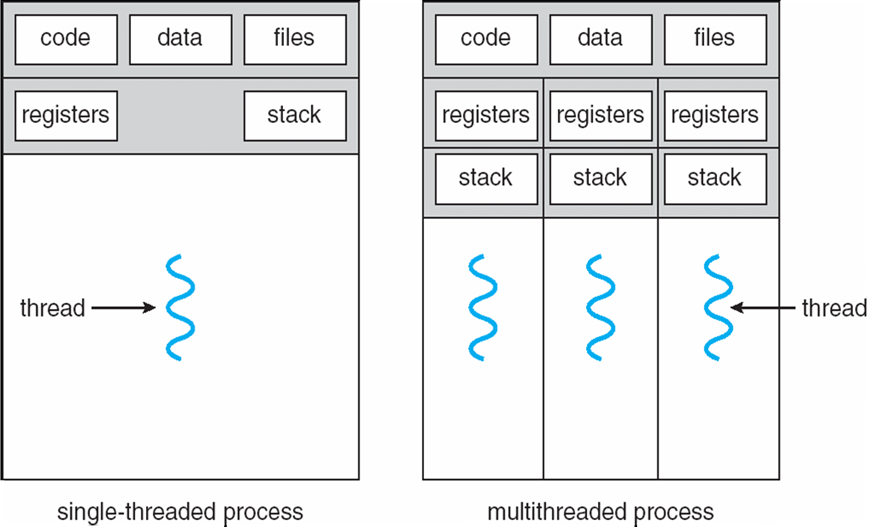

- 单线程进程(Single-threaded process)

- 有一个程序计数器(PC,program counter),指定要执行的下一条指令的位置

- 进程按顺序执行指令,一次一个,直到完成

- 多线程进程(Multi-threaded process)

- 每个线程有一个程序计数器(PC)

- 通常,系统有许多进程,一些用户,一些操作系统在一个或多个CPU上并发运行

- 通过在进程/线程之间复用CPU(multiplexing)实现并发(concurrency)

- 时间片:多个时钟周期的组合

- 轮转的调度方法:每一个进程执行一段时间后,暂停当前进程,执行下一个进程

- 每一次切换时,由于需要将当前进程的相关信息保存下来,所有会造成浪费

- Process Management的任务:

- 创建和删除用户和系统进程

- 暂停和恢复进程

- 提供进程同步机制

- 提供过程通信机制

- 提供死锁处理机制

1.5.2 内存管理

- 要执行程序,所有(或部分)指令必须在内存中

- 程序所需的所有(或部分)数据必须在内存中

- 内存管理确定内存中的内容和时间

- 优化CPU利用率和计算机对用户的响应

- Memory Management的任务:

- 跟踪当前正在使用内存的哪些部分以及由谁使用

- 决定哪些进程(或其部分)和数据要移入和移出内存

- 根据需要分配和释放内存空间

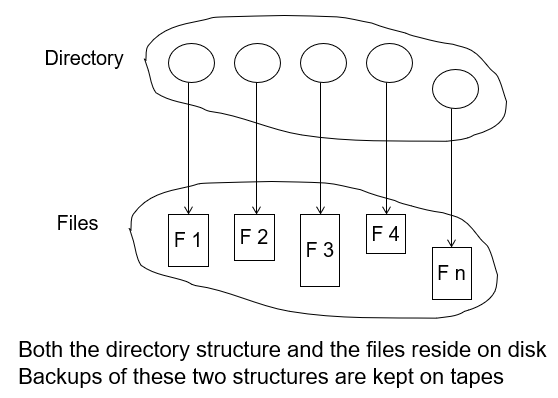

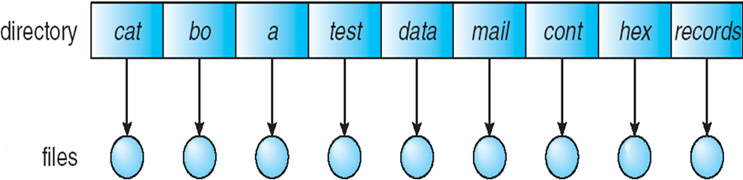

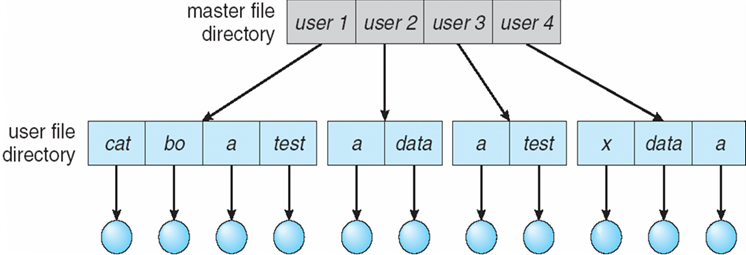

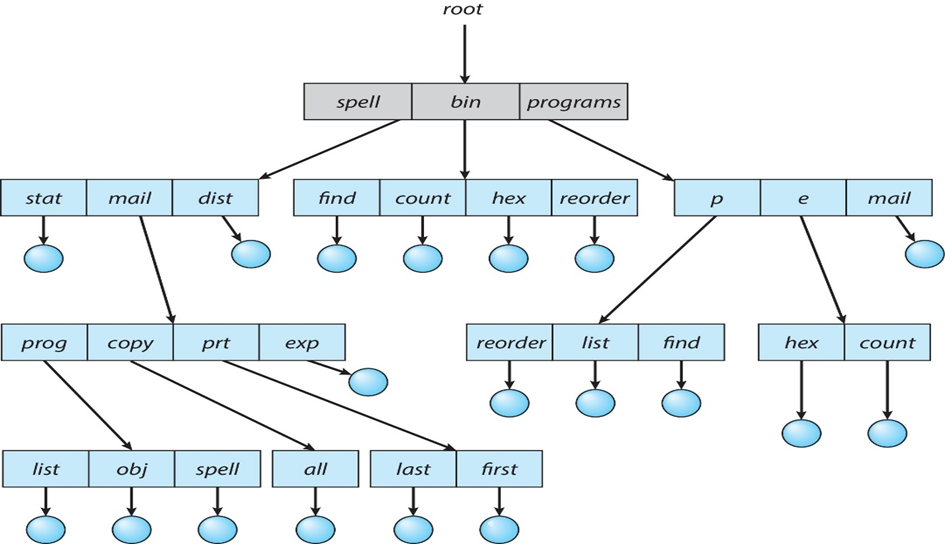

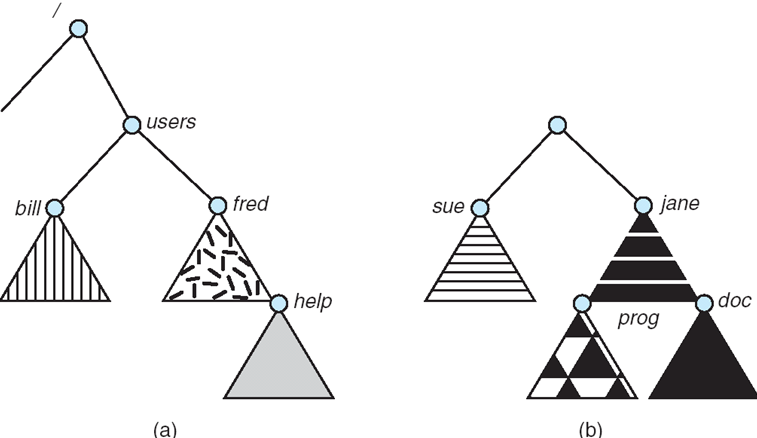

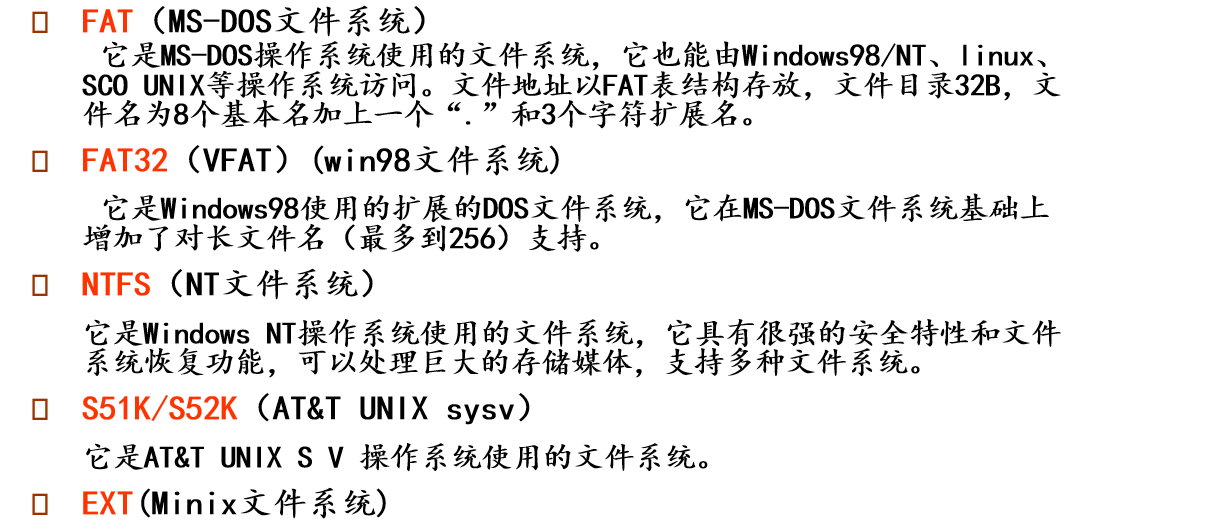

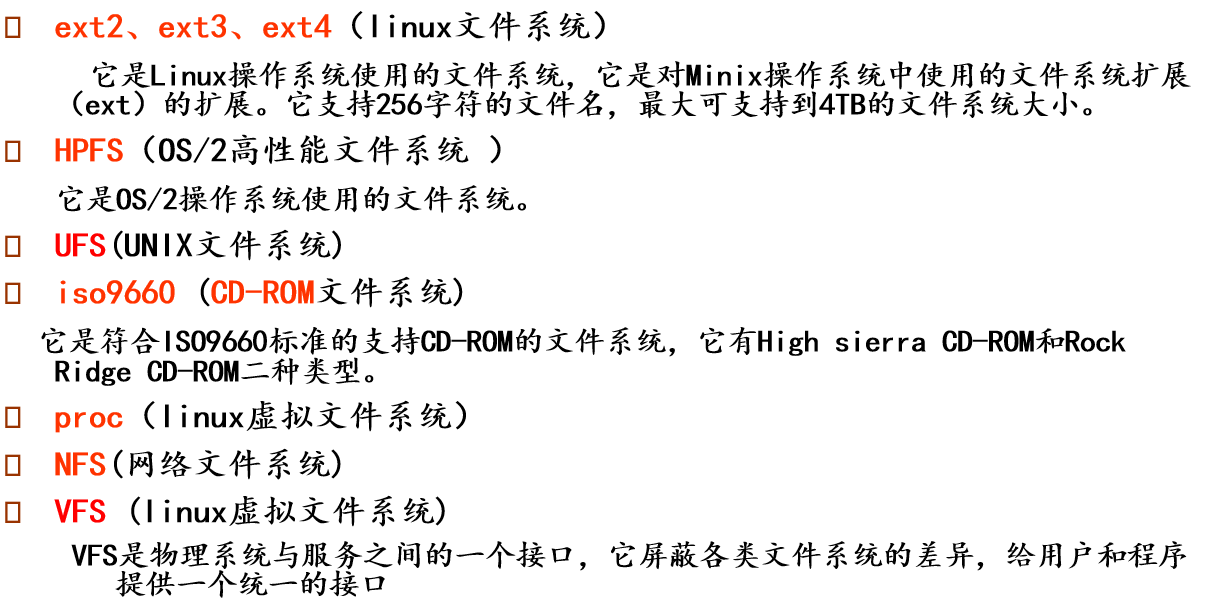

1.5.3 文件系统管理

- 操作系统提供信息存储的统一逻辑视图

- 将物理属性抽象为逻辑存储单元文件file

- 每个介质由设备(如磁盘驱动器、磁带驱动器)控制

- 不同的属性包括访问速度、容量、数据传输速率、访问方法(顺序或随机)

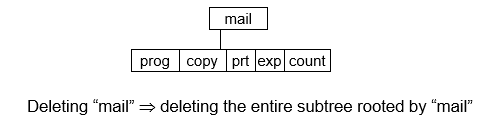

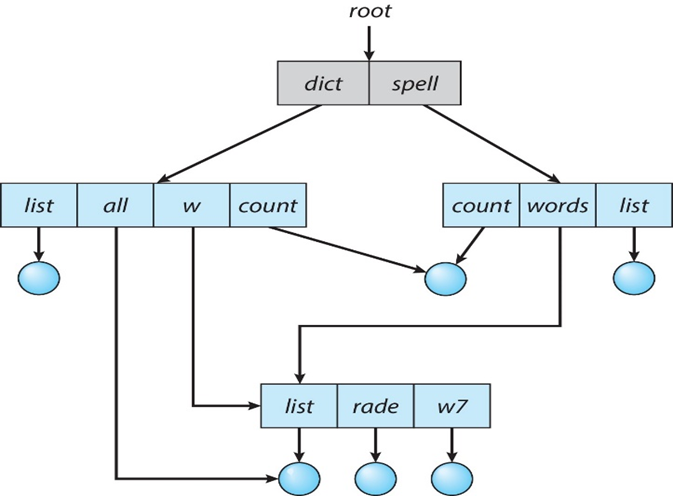

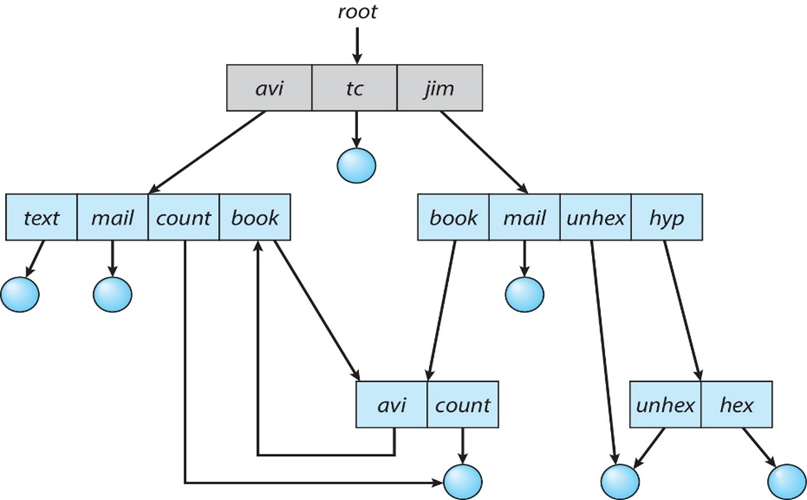

- 文件系统管理

- 文件通常被组织到目录中

- 大多数系统上的访问控制,以确定谁可以访问什么

- File-system Management的任务:

- 创建和删除文件和目录

- 用于操作文件和目录的原语primitives

- 将文件映射到辅助存储

- 将文件备份到稳定(非易失性)存储介质上

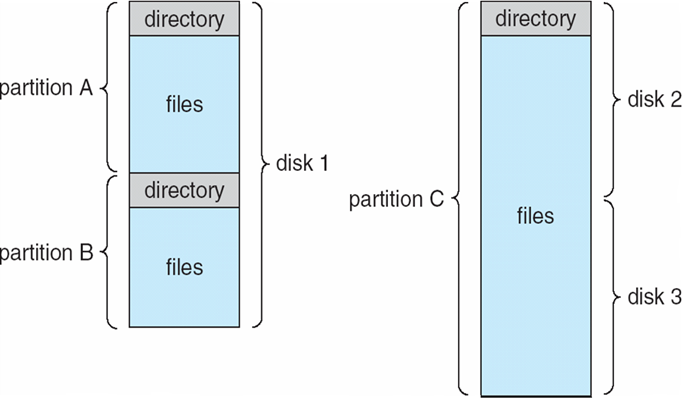

1.5.4 大容量储存管理

- 通常,磁盘用于存储不适合主内存的数据或必须保存“长”一段时间的数据

- 适当的管理至关重要

- 计算机操作的整体速度取决于磁盘子系统及其算法

- Mass-Storage Management的任务

- 安装mounting和拆卸unmounting

- 空闲空间管理

- 存储分配

- 磁盘调度

- 分区Partition

- 保护Protection

- 有些存储不需要很快

- 三级存储包括光盘、磁带

- 仍然必须由操作系统或应用程序进行管理

1.5.5 高速缓存机制Caching

重要原理,在计算机(硬件、操作系统、软件)的多个级别执行

将正在使用的信息临时从较慢的存储复制到较快的存储

Faster Storage(cache)首先检查,判断信息是否存在

- 如果存在,则直接从缓存中使用信息(fast)

- 如果不存在,则将数据复制到缓存并在其中使用

缓存小于正在缓存的存储

- 缓存管理是一个重要的设计问题

- 缓存大小和替换策略

多任务环境必须小心使用最新的值,无论它存储在存储层次结构中的何处

多处理器环境必须在硬件中提供缓存一致性,以便所有CPU在其缓存中都具有最新的值

分布式环境情况更加复杂

- 一个基准可以有多个副本

- 第19章涵盖的各种解决方案

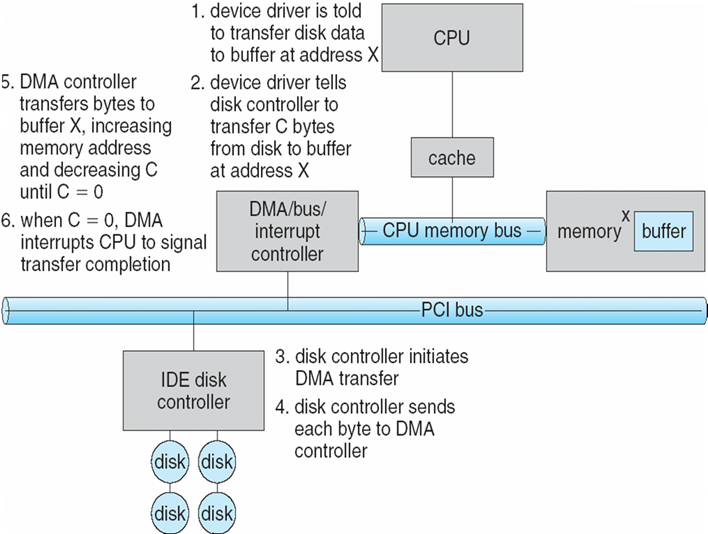

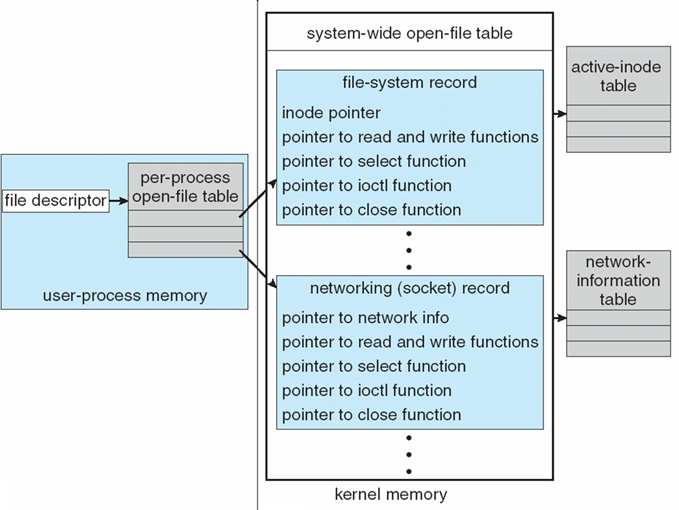

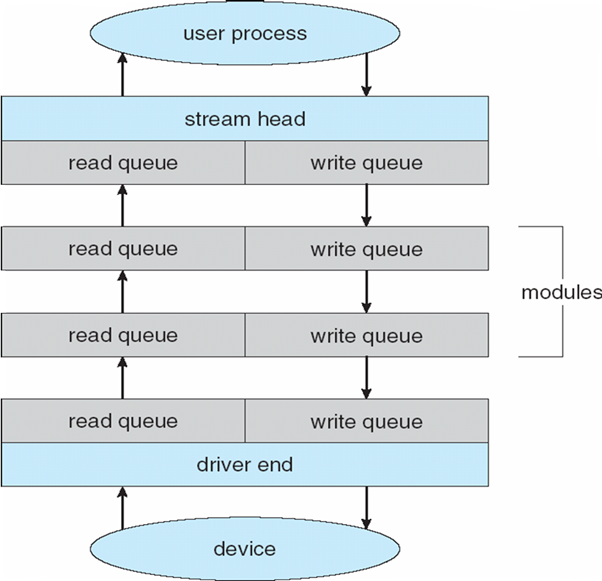

1.5.6 I/O子系统

- 操作系统的一个目的是向用户隐藏硬件设备的特性

- I/O Subsystem的任务:

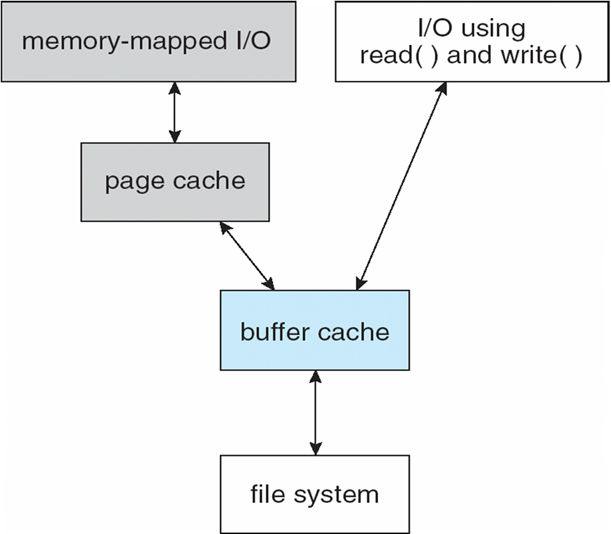

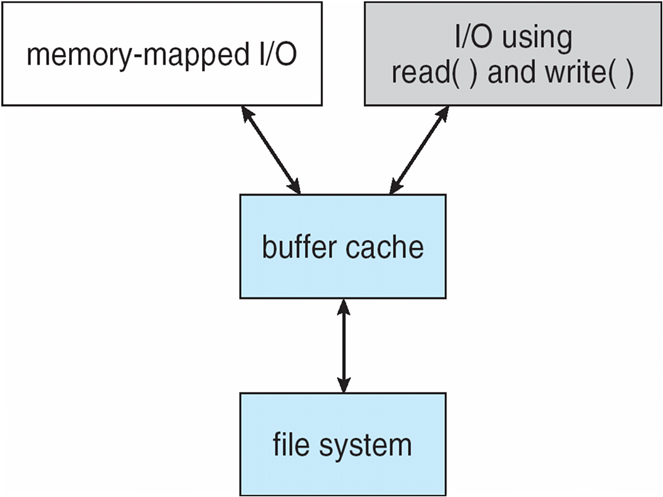

- I/O的内存管理,包括缓冲(在传输数据时临时存储数据)、缓存(将部分数据存储在更快的存储中以提高性能)、假脱机(一个作业的输出与其他作业的输入重叠)

- 通用设备驱动程序接口

- 特定硬件设备的驱动程序

1.6 Security and Protection安全和保护

- 保护Protection:控制进程或用户 访问操作系统定义的资源 的机制

- 安全性Security:防御系统内部和外部攻击

- 范围广泛,包括拒绝服务(denial-of-service)、蠕虫(worms)、病毒(viruses)、身份盗窃(identity theft)、服务盗窃(theft of service)

- 系统通常首先区分用户,以确定谁可以做什么

- 用户身份(user IDs、security IDs):包括姓名和相关号码,每个用户一个

- user ID与该用户的所有文件、进程关联,以确定访问控制

- 组标识符(group ID):允许定义和管理用户集,然后还可以与每个进程、文件关联

- 权限提升Privilege escalation:允许用户更改为具有更多权限的有效ID

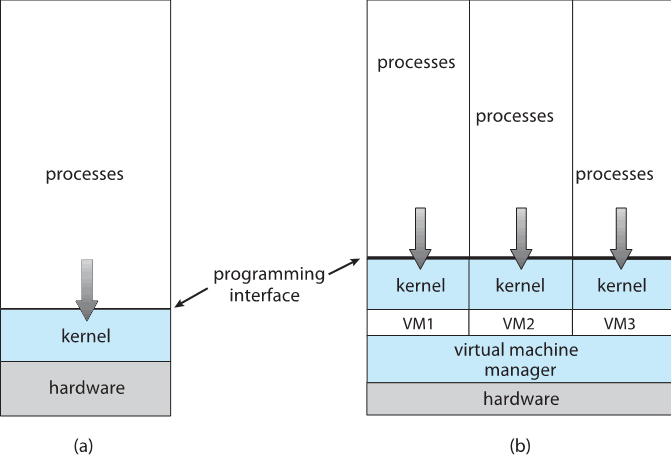

1.7 Virtualization虚拟化

- 允许操作系统在其他操作系统中运行应用程序

- 仿真Emulation:当源CPU类型与目标CPU类型不一样时使用该技术

- 通常是最慢的方法

- 当计算机语言未编译为本机代码时:Interpretation翻译

- 虚拟化Virtualization:为CPU本机编译的OS,运行本机也编译过的guest

OS

- 考虑运行WinXP客户机的VMware,每个客户机都运行本机WinXP主机操作系统上的应用程序

- VMM(虚拟机管理器 virtual machine Manager)提供虚拟化服务

- VMM可以本地化运行,在这种情况下,它们也是主机

- 因此,没有通用主机(VMware ESX和Citrix XenServer)

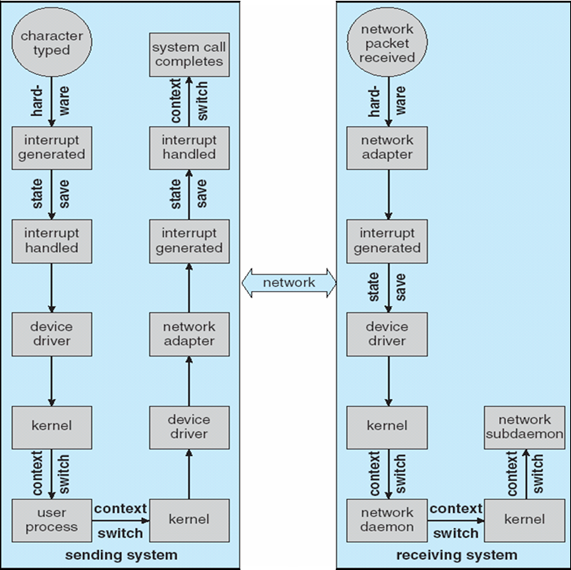

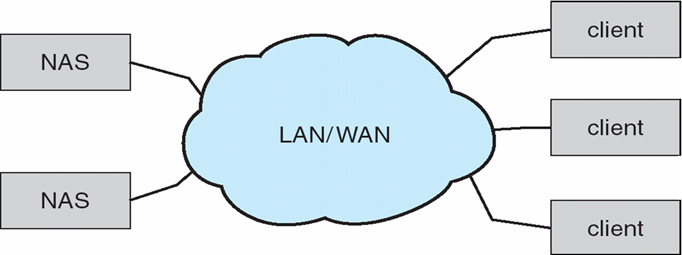

1.8 Distribute System分布式系统

- 分布式计算

- 独立的、可能异构的、联网在一起的系统的集合

- 网络(Network)是通信路径,TCP/IP最常见

- 局域网(LAN)

- 广域网(WAN)

- 城域网(MAN)

- 个人局域网(PAN)

- 网络操作系统(Network Operating

System):提供跨网络的系统之间的功能

- 通信方案允许系统交换消息

- 看起来是单一系统

1.9 Kernel Data Structures内核数据结构

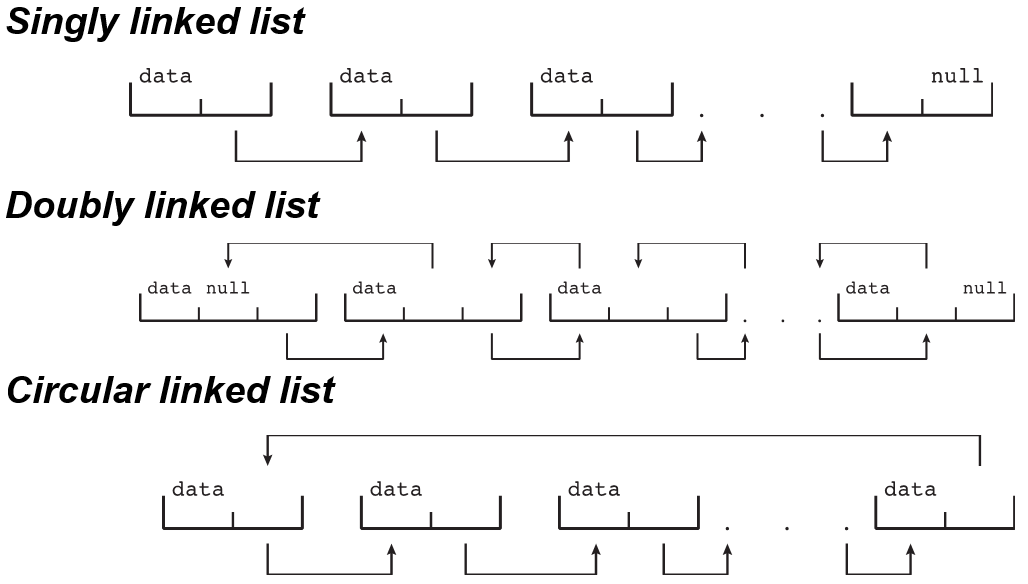

Linked List

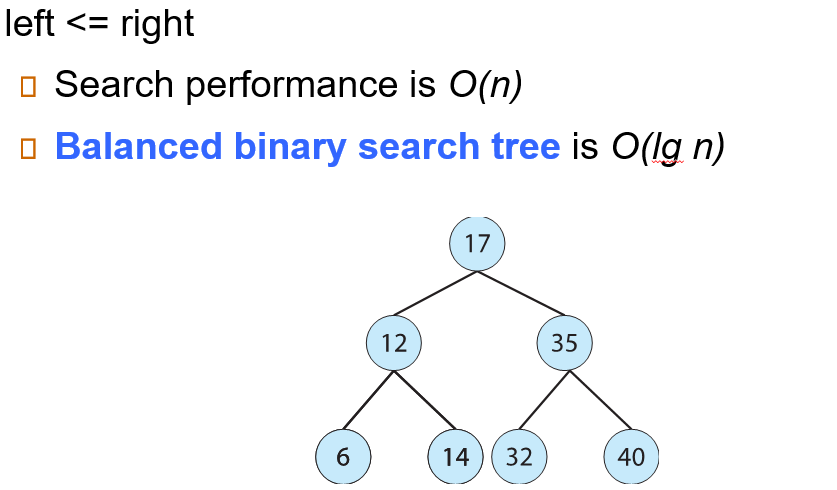

Binary Search Tree

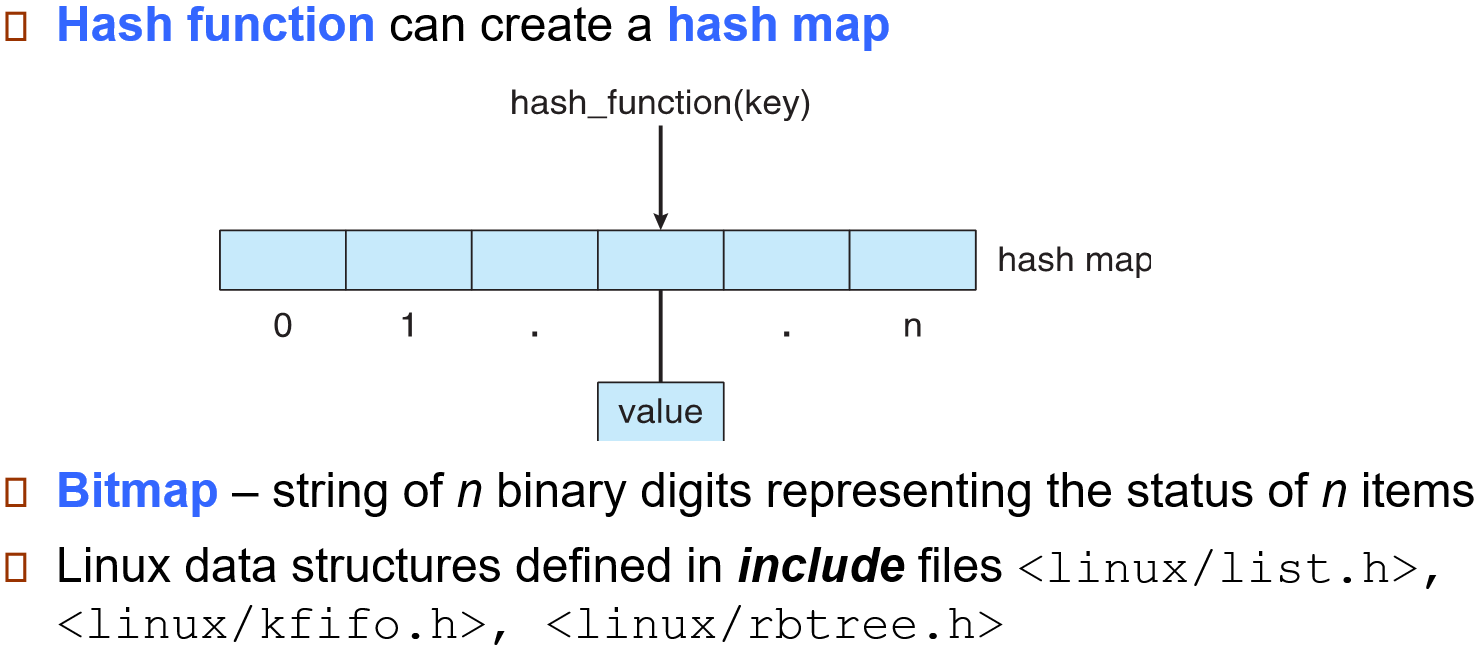

Hash Map

1.10 Computing Environments计算环境

1.10.1 传统计算 Traditional

- 独立通用机器

- 但由于大多数系统与其他系统(即互联网)互连,因此变得模糊

- 门户Portals提供对内部系统的web访问

- 网络计算机(thin clients)就像Web终端

- 移动计算机通过无线网络互连

- 网络无处不在,甚至家庭系统也使用防火墙保护家庭计算机免受互联网攻击

Mainfram Systems大型机系统:

Batch System:批处理系统

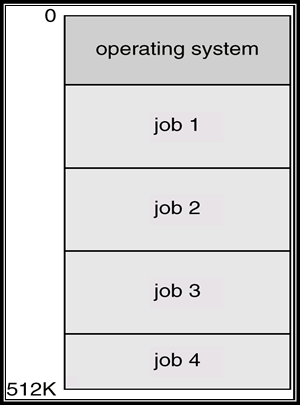

Multiprogramming:多道程序,多个作业同时保存在主存中,CPU在其中多路复用

Time-Sharing Systems:分时系统

- 分时:多个用户分时共享使用同一台计算机

- 也就是说把计算机的系统资源(尤其是CPU时间)进行时间上分割,即将整个工作时间分成一个个的时间片,每个时间片分给一个用户使用

- 这样将CPU工作时间分别提供给多个用户使用,每个用户依次地轮流且使用一个时间片

- 响应时间:是分时系统的重要指标,它是用户发出终端命令到系统作出响应的时间间隔。

- 系统的响应时间主要是根据用户所能接受的等待时间确定的。

- 假设分时系统中进程数(用户数)为n,每个进程的运行时间片为q,则系统的最大响应时间为:\(S=(n-1)×q\)

- 响应时间仅计算第一次被运行的时间点

- 分时:多个用户分时共享使用同一台计算机

Desktop Systems:桌面系统

- 个人计算机:专用于单个用户的计算机系统

- I/O设备:键盘、鼠标、显示屏、小型打印机

- 重点:用户的便利性和响应能力

- 可以采用为大型操作系统开发的技术,通常个人只使用计算机,不需要高级CPU利用率的保护功能

- 可以运行多种不同类型的操作系统

1.10.2 移动计算 Mobile

- 手持智能手机、平板电脑等

- 它们与“传统”笔记本电脑的功能区别是什么?

- 附加功能–更多操作系统功能(GPS、gyroscope陀螺仪)

- 允许新类型的应用程序,如增强现实

- 使用IEEE 802.11无线或蜂窝数据网络进行连接

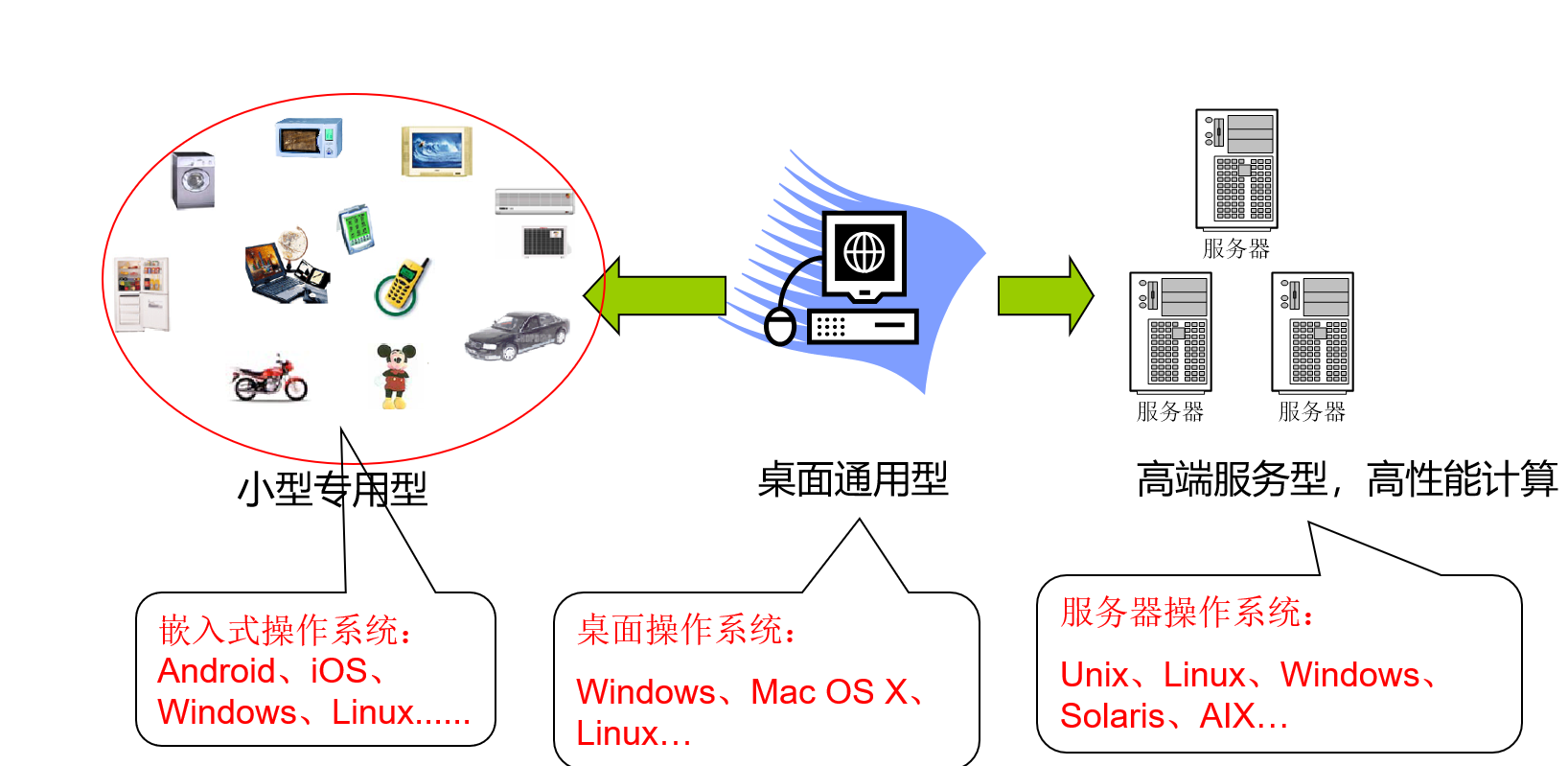

计算应用领域:

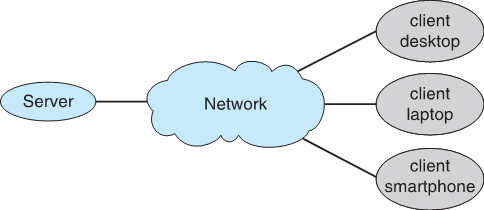

1.10.3 客户机Client-服务器Server计算

智能PC取代了无人机终端

现在许多系统都是服务器,响应客户端生成的请求

- 计算服务器系统compute-server system:为客户端提供请求服务(即数据库)的接口

- 文件服务器系统file-server system:为客户端提供存储和检索文件的接口

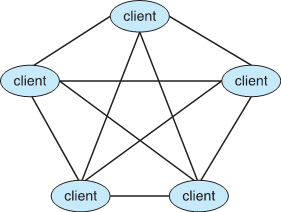

1.10.4 点对点计算 Peer-to-Peer

分布式系统的另一种模型

P2P无法区分客户端和服务器

- 相反,所有节点都被视为对等节点

- 可以分别充当客户端、服务器或两者

- 节点必须加入P2P网络

- 在网络上向中央查找服务注册其服务,或

- 广播服务请求并通过发现协议响应服务请求

示例包括Napster和Gnutella、Voice over IP(VoIP),如Skype

Blockchain technology 区块链技术

1.10.5 虚拟化计算 Virtualization

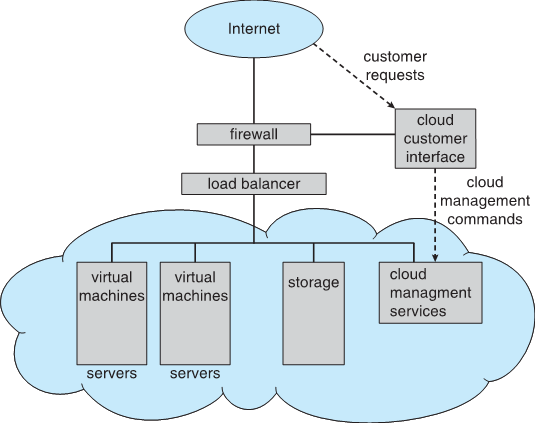

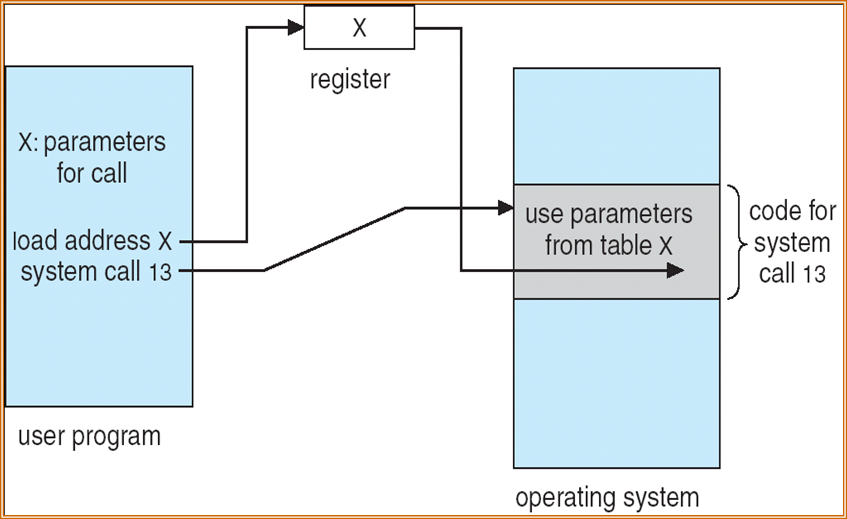

1.10.6 云计算 Cloud Computing

- 通过网络将计算、存储甚至应用程序作为服务提供

- 基于虚拟化的虚拟化逻辑扩展

- Amazon EC2拥有数千台服务器、数百万台虚拟机、PB存储空间,可在互联网上使用,根据使用情况付费

- Many types

- Public cloud(公有云):任何愿意付费的人都可以通过互联网获得

- Private cloud(私有云):由公司运营供公司自用

- Hybrid cloud(混合云):包括公共云组件和私有云组件

- Software as a Service (SaaS,软件即服务) :通过互联网提供的一个或多个应用程序(即文字处理器)

- Platform as a Service (PaaS,平台即服务) :软件堆栈可通过Internet(即数据库服务器)供应用程序使用

- Infrastructure as a Service (IaaS,基础设施即服务) :通过Internet可用的服务器或存储(即可用于备份的存储)

1.10.7 实时嵌入式系统 Real-Time Embedded Systems

- 实时嵌入式系统——最流行的计算机形式

- 各种相当大的、特殊用途的、有限用途的操作系统、实时操作系统

- 使用扩展

- 还有许多其他特殊的计算环境

- 有些有操作系统,有些在没有操作系统的情况下执行任务

- 实时操作系统具有明确定义的固定时间限制,运行顺序与要求的顺序一定相同

- 处理必须在约束内完成

- 只有在满足约束条件时才能正确操作

- 嵌入式系统:是以应用为中心,以计算机技术为基础,采用可剪裁软硬件,适用于对功能、可靠性、成本、体积、功耗等有严格要求的专用计算机系统,用于实现对其他设备的控制、监视或管理等功能

- 嵌入式操作系统:运行在嵌入式系统环境中,对整个嵌入式系统以及它所操作、控制的各种部件装置等资源进行统一协调、调度和控制的系统软件

1.10 总结

Chapter 2:Operating-System Structures

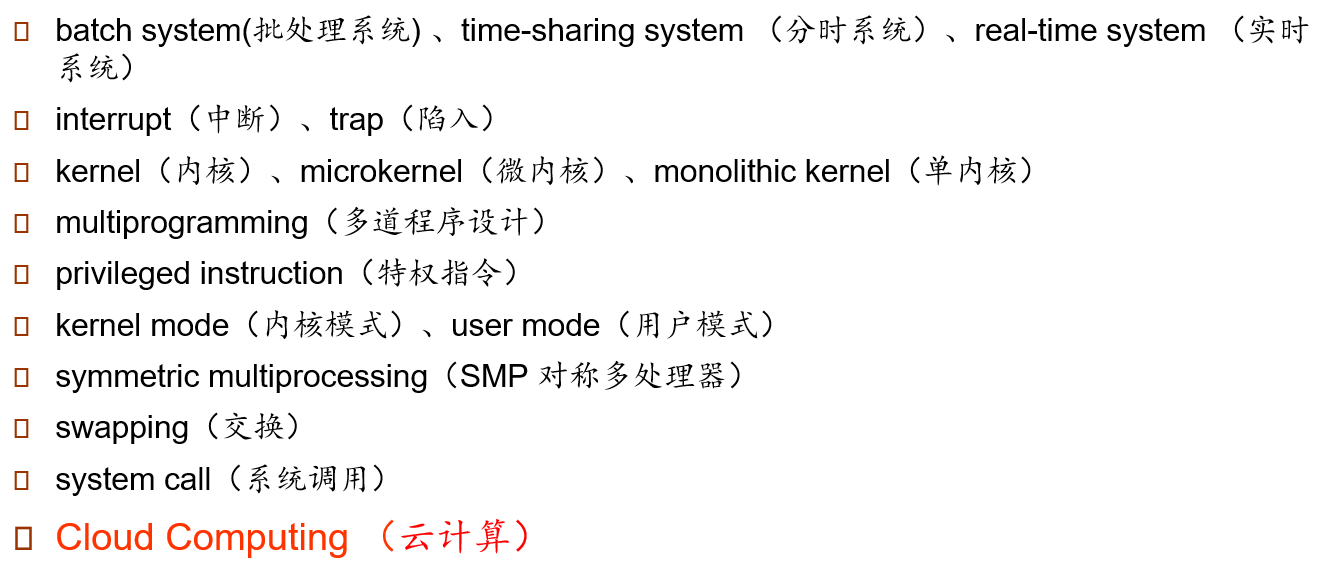

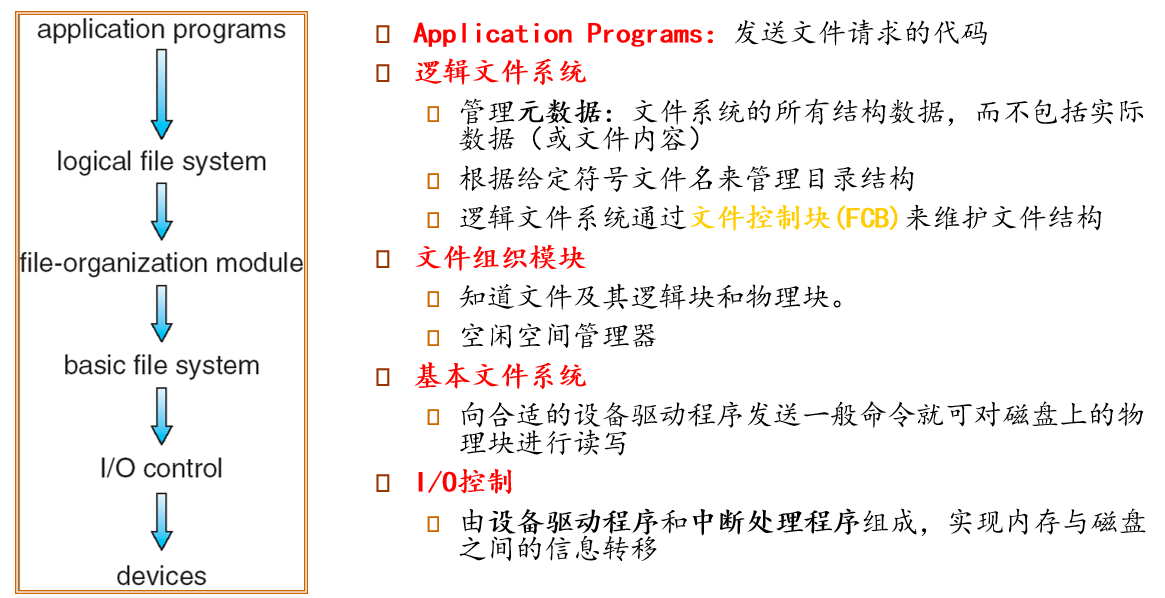

2.1 操作系统提供的服务

- 用户界面User Interface:

- 几乎所有操作系统都有用户界面(UI)

- 在命令行界面(CLI)、图形用户界面(GUI)和批处理之间有所不同

- 程序执行Program Execution:

- 系统必须能够将程序加载到内存并运行该程序,正常或异常结束执行(指示错误)

- I/O操作I/O operations:

- 正在运行的程序可能需要I/O,这可能涉及文件或I/O设备

- 文件系统操作File-System Manipulation:

- 程序需要读取和写入文件和目录,创建和删除它们,搜索它们,列出文件信息,权限管理

- 通信Communication:

- 进程可以在同一台计算机上或在网络上的计算机之间交换信息

- 通信可以通过共享内存或消息传递(数据包由操作系统移动)

- 错误检测Error Detection:

- 操作系统需要不断意识到可能的错误

- 错误可能出现在CPU和内存硬件、I/O设备、用户程序中

- 对于每种类型的错误,操作系统都应该采取适当的措施来确保正确和一致的计算

- 调试设施可以大大提高用户和程序员有效使用系统的能力

- 资源分配Resource allocation:

- 当多个用户或多个作业同时运行时,必须将资源分配给每个用户或作业

- 许多类型的资源(如CPU周期、主内存和文件存储)可能有特殊的分配代码,其他(如I/O设备)可能有一般的请求和发布代码。

- Accounting:

- 跟踪哪些用户使用了多少和什么类型的计算机资源

- 保护和安全Protection and Security:

- 存储在多用户或联网计算机系统中的信息的所有者可能希望控制该信息的使用,并发进程不应相互干扰

- 保护包括确保控制对系统资源的所有访问

- 来自外部的系统安全需要用户身份验证,扩展到保护外部I/O设备免受无效访问尝试

- 如果要保护系统,必须在整个系统中采取预防措施。链条的坚固程度取决于它最薄弱的环节

2.2 User Operating System Interface

- Operating System Interface操作系统的接口:

- User Interface (用户接口)

- Program Interface (程序接口,system call)

- User interface:用户接口,Almost all operating

systems have a user interface (UI)

- Command-Line Interface (CLI):命令行用户接口,文本界面

- Graphics User Interface (GUI):图形用户接口

- Touch-Screen Interface:触摸屏接口

- Choice of Interface:语音接口

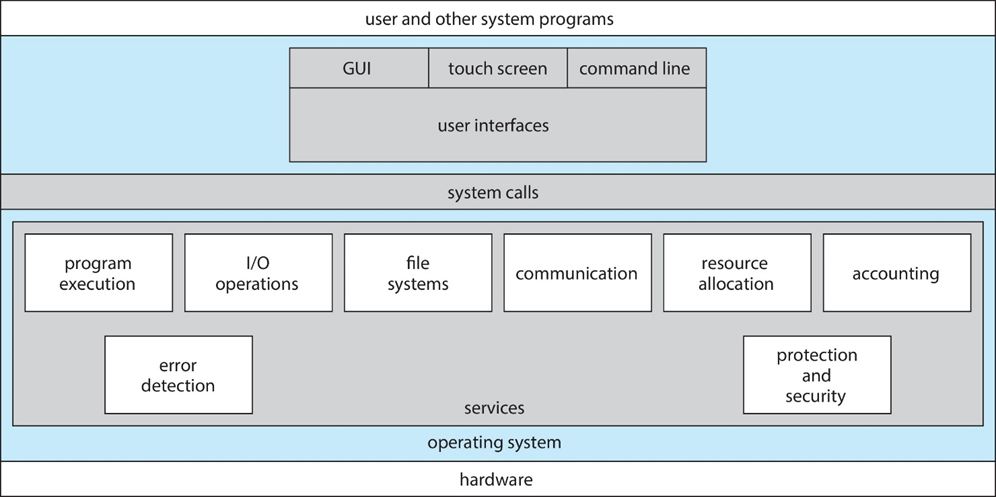

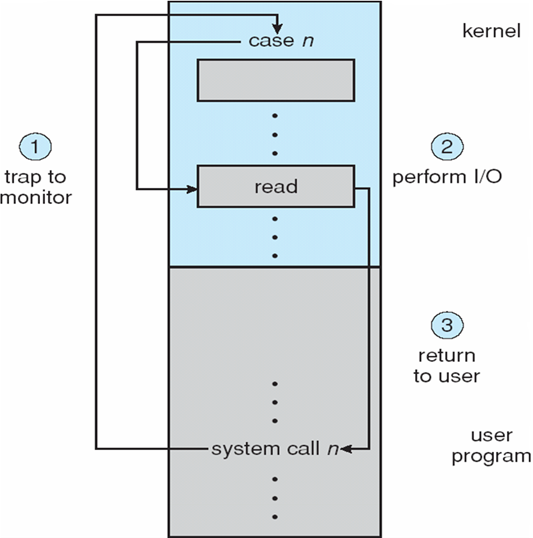

2.3 System Calls

系统调用System Call:操作系统提供的服务的编程接口

- 系统调用:进程和操作系统内核之间的编程接口

- 通常用高级语言(C或C++)编写

- 通常由程序通过高级应用程序接口(API)访问,而不是直接使用系统调用

- 系统调用过于复杂,不适于编程

- 通过API将系统调用封装起来,便于编程

- 三种最常见的API:

- 用于Windows的Win32 API

- 用于基于POSIX的系统的POSIX API(包括几乎所有版本的UNIX、Linux和Mac OS X)

- 用于Java虚拟机(JVM)的Java API

API与系统调用的区别

应用编程接口(API):其实是一组函数定义,这些函数说明了如何获得一个给定的服务

系统调用:是通过软中断向内核发出一个明确的请求,每个系统调用对应一个封装例程(wrapper routine,唯一目的就是发布系统调用),一些API应用了封装例程

API还包含各种编程接口,如:C库函数、OpenGL编程接口等

系统调用的实现是在内核完成的,而用户态的函数是在函数库中实现的

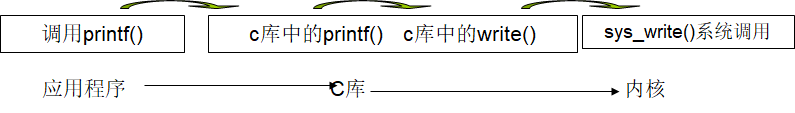

参数的传递:

放到register

放到内存中,用register传递指针

放到栈中,使用时从栈中pop出来

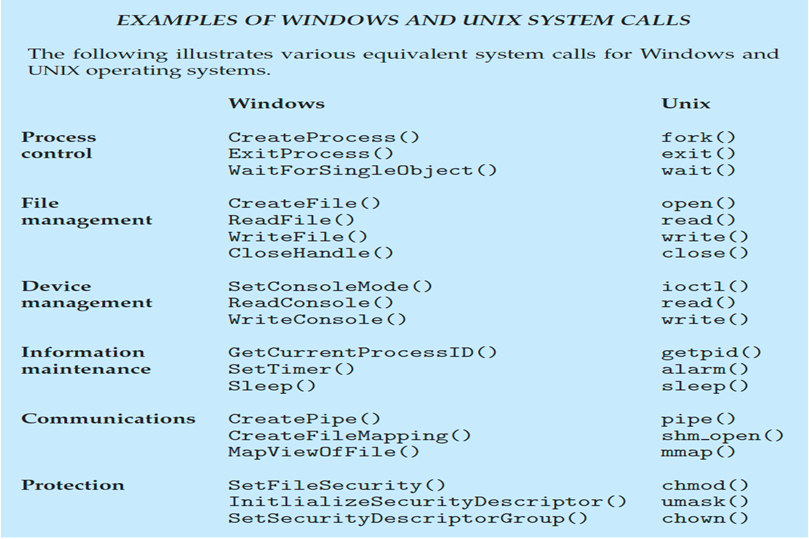

系统调用的种类

- Process control:进程控制

- 创建/终止/结束/中止/加载/执行 进程

- 获取/设置 进程属性

- 等待 一段时间/某个事件的发生

- 分配/释放/出错时转储 内存

- 用于确定错误的调试器Debugger,单步执行

- 用于管理进程之间共享数据访问的锁Locks

- File management:文件管理

- 创建/删除/打开/关闭/读/写/重定位 文件

- 获取/设置 文件属性

- Device management:设备管理

- 访问/释放/读/写/重定位 设备

- 获取/设置 设备属性

- 逻辑挂载/逻辑接触挂载 设备

- Information maintenance:信息维护

- 获取/设置 时间/日期/系统数据/进程属性/文件属性/设备属性

- Communications:通信

- 创建/删除 通信联系

- 如果是message passing model,则需要发送/接受信息

- 如果是shared-memory model,则需要创建/访问共享空间

- 传递状态信息

- 远程连接

- Protection:安全保护

- 对资源/文件的访问权限

- 用户的权限

- Process control:进程控制

2.4 System Services

系统程序System programs为程序开发和执行提供了方便的环境。它们可以分为:

- 文件操作:创建、删除、复制、重命名、打印、转储、列出并通常操作文件和目录

- 状态信息

- 文件修改:文本编辑器

- 编程语言支持:编译器、汇编器、调试器、解释器

- 程序加载和执行:加载/重新加载

- 通信:创建进程之间的连接,允许用户对另外一个用户进行传输文件/发送信息/远程控制

- 后台服务:启动时启动某些程序,打印错误日志,用户文本操作

- 应用程序

大多数用户对操作系统的认知是由系统程序System programs定义的,而不是实际的系统调用System calls

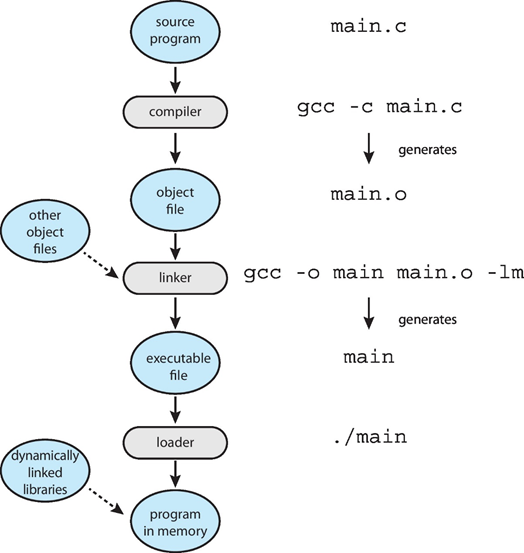

2.5 Linkers and Loaders

编译成目标文件的源代码,可加载到任何物理内存位置:可重定位的目标文件relocatable object file

链接器Linker将这些obj文件,合并为单个二进制可执行文件executable file

- 引入了库

程序作为二进制可执行文件加载load在辅助存储上

必须由要执行的加载程序带入内存

- 重新定位Relocation将最终地址分配给程序部件,并调整程序中的代码和数据以匹配这些地址

现代操作系统不会将库链接到可执行文件中

- 相反,动态链接库(DLL)是根据需要加载的,由所有使用同一版本库的用户共享

- 在程序运行时,按照需要加载一次

对象,可执行文件具有标准格式,因此操作系统知道如何加载和启动它们

2.6 为什么应用程序只运行在特定的操作系统上

- 在一个系统上编译的应用程序通常不能在其他操作系统上执行

- 每个操作系统都提供自己独特的系统调用、自己的文件格式等

- 应用程序可以是多操作系统

- 用解释语言编写,如Python、Ruby和多个操作系统上可用的解释器

- 以包含包含运行应用程序的VM的语言编写的应用程序(如Java)

- 使用标准语言(如C),在每个操作系统上分别编译,以便在每个系统上运行

- 应用程序二进制接口(Application Binary

Interface,ABI):是API的体系结构等价物

- 定义了二进制代码的不同组件如何在给定的体系结构、CPU等上与给定的操作系统交互

2.7 Operating-System Design and Implementation

- 操作系统的设计和实现不是“可解决的”,但一些方法已经证明是成功的

- 不同操作系统的内部结构可能有很大差异

- 从定义目标和规范开始

- 受硬件选择、系统类型的影响

- 用户目标和系统目标

- 用户目标:操作系统应便于使用、易于学习、可靠、安全和快速

- 系统目标:操作系统应易于设计、实施和维护,并且灵活、可靠、无错误和高效

操作系统的设计考虑

- 功能设计:操作系统应具备哪些功能

- 算法设计:选择和设计满足系统功能的算法和策略,并分析和估算其效能

- 结构设计:选择合适的操作系统结构

- 按照系统的功能和特性要求,选择合适的结构,使用相应的结构设计方法将系统逐步地分解、抽象和综合,使操作系统结构清晰、简单、可靠、易读、易修改,而且使用方便,适应性强

具体实现

- 变化很大

- 早期操作系统:汇编语言

- 然后:系统编程语言,如Algol、PL/1

- 现在:C,C++

- 实际上通常是多种语言的混合

- 组件中的最低级别

- 主体用C表示

- 用C、C++、脚本语言(如PERL、Python、shell脚本)编写的系统程序

- 更高级的语言更容易移植到其他硬件,但速度较慢

- 仿真可以允许操作系统在非本机硬件上运行

2.8 Operating-System Structure

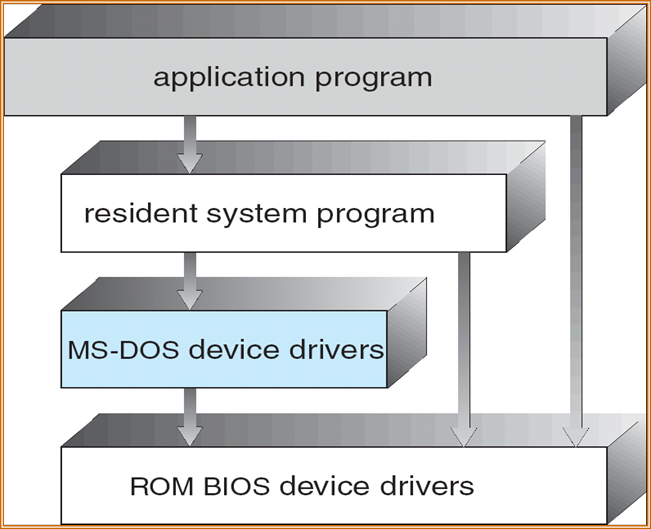

Simple Structure:简单结构

- MS-DOS:以最少的空间提供最多的功能

- 未划分为模块

- 虽然MS-DOS有一些结构,但其接口和功能级别没有很好地分离

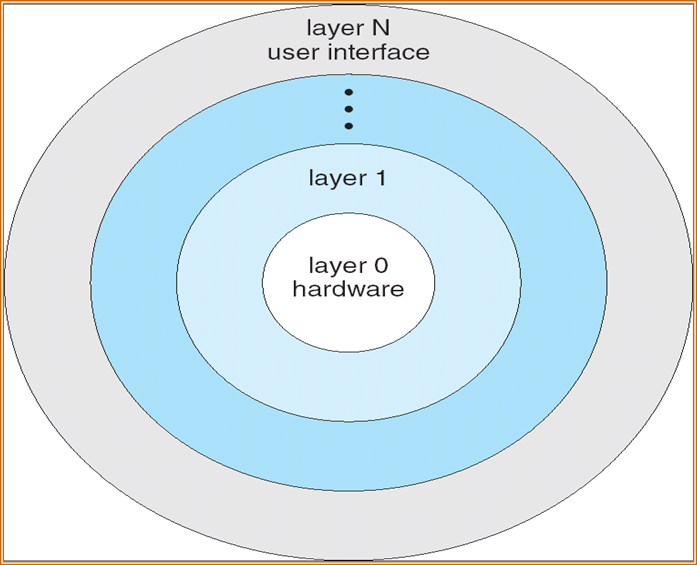

Layered Approach:层次化结构

- 操作系统被划分为若干层(级别),每一层都构建在较低层之上

- 底层(第0层)是硬件;最高的(N层)是用户界面

- 通过模块化,层的选择使得每个层只使用较低层的功能(操作)和服务

- 上一层只能使用下一层的功能

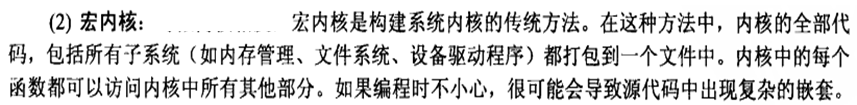

Monolithic Kernels Structure:单/宏内核结构

- 内核的整个代码都打包到一个文件中

- 每个函数都可以访问内核的所有其他部分

- 最早和最常见的操作系统体系结构(UNIX)

- 操作系统的每个组件都包含在内核中

- 示例:OS/360、VMS和Linux

- 优点:高效

- 缺点:很难定位问题,很难修改和维护,内核会变得越来越大

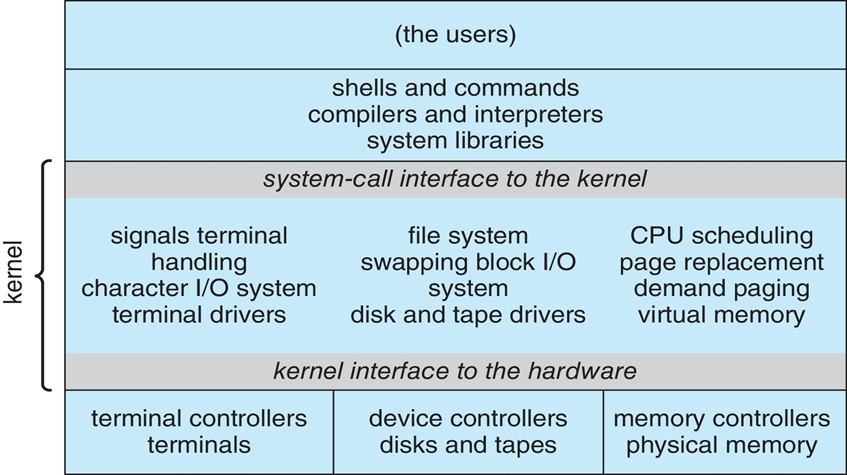

Microkernel:微内核,只保留必要的程序,在内核模式中运行的程序

只有最基本的功能由内核实现

所有其它功能委托给一些独立进程实现,这些进程通过明确定义的通信接口与中心内核通信

系统的各个部分彼此都很清楚的划分开来,同时也迫使程序员使用“清洁的”程序设计技术

优点:动态可扩展性、在运行时切换重要组件

缺点:在各个组件之间支持复杂通信需要额外的CPU时间

现有的系统多使用微内核结构

Modules:模块

- 大多数现代操作系统实现kernel modules(内核模块)

- 使用面向对象的方法

- 每个核心组件都是独立的

- 每个人都通过已知接口与其他人交谈

- 每个都可以根据需要在内核中加载

- 总体而言,与层相似,但更灵活

- 大多数现代操作系统实现kernel modules(内核模块)

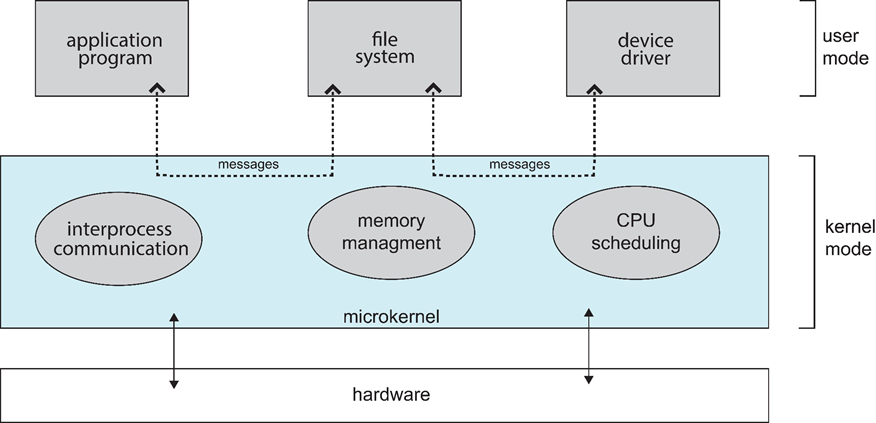

Hybrid Systems:混合结构

- 大多数现代操作系统实际上不是一个纯模型

- Hybrid System结合了多种方法来满足性能、安全性和可用性需求

Virtual Machines:虚拟机

- 虚拟机采用分层方法得出其逻辑结论。它将硬件和操作系统内核视为硬件

- 虚拟机提供与底层裸硬件相同的接口

- 操作系统主机会产生一种错觉,认为进程有自己的处理器和(虚拟内存)

- 为每位host提供一份底层计算机的(虚拟)副本

- 虚拟机软件:VMWARE、VirtualBox、Microsoft virtual PC

- 开放堆栈云计算平台

Chapter 3:Processes

3.1 进程的概念

3.1.1 进程

进程:一个正在执行的程序,独立的,有权获取资源的

- 计算机的基本工作单位

- jobs作业=user programs用户程序=tasks任务=process进程

- 包含一些资源的指令容器:例如CPU时间(CPU执行指令)、内存、文件、完成其任务的I/O设备

- 示例:

- 编译进程

- 字处理进程

- 调度程序进程(scheduler processes):sched、swapper

- 守护进程(daemon process):ftpd、httpd

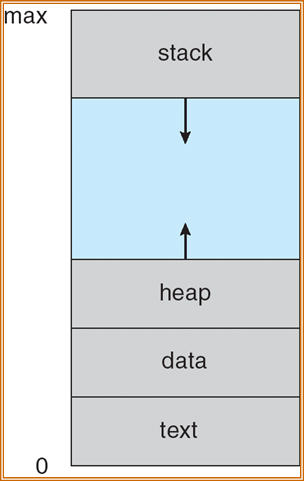

3.1.2 内存中的进程

- 程序代码,也被称为text section

- PC:Program Counter

- Register

- Data section:全局变量

- Stack:临时变量

- Heap:动态开辟的内存

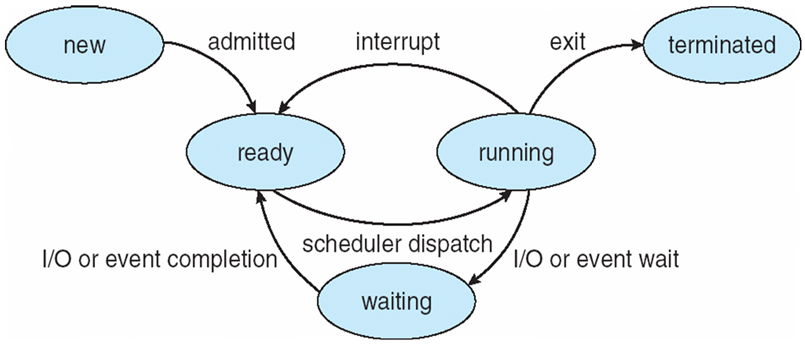

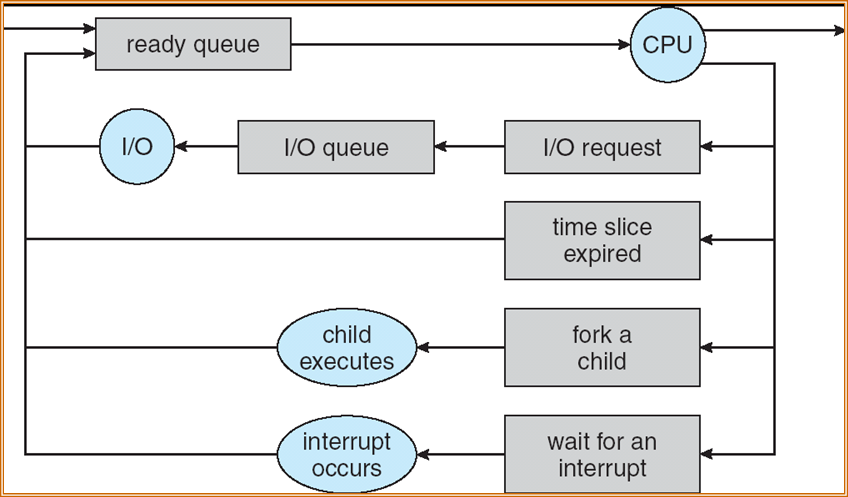

3.1.3 进程状态

- New(新):创建进程,在内存中开辟一段空间给进程

- Running(运行、执行): 进程正在使用CPU

- Ready(就绪):进程可以使用CPU

- Waiting(等待、blocked阻塞):进程等待一些事件的发生

- Terminated(终止):进程停止执行

3.1.4 进程状态的切换

- 程序:系统调用

- 操作系统:调度

- 外部程序:中断

- 只有ready状态才能转换到running状态

- 三个基本状态之间可能转换和转换原因如下:

- ready→running:当处理器空闲时,进程调度程序必将处理机分配给一个处于ready状态的进程 ,该进程便由ready状态转换为running状态

- running→waiting:处于running状态的进程在运行过程中需要等待某一事件发生后(例如因I/O请求等待I/O完成后),才能继续运行,则该进程放弃处理器,从running状态转换为waiting状态

- waiting→ready:处于waiting状态的进程,若其等待的事件已经发生,于是进程由waiting状态转换为ready状态。

- running→ready:处于running状态的进程在其运行过程中,因分给它的处理器时间片已用完,而不得不让出(被抢占)处理器,于是进程由running态转换为ready态。

- waiting→running,ready→waiting这二种状态转换一般不可能发生

- 处于running状态进程:如系统有一个处理器,则在任何一时刻,最多只有一个进程处于运行状态。

- 处于ready状态进程:一般处于就绪状态的进程按照一定的算法(如先来的进程排在前面,或采用优先权高的进程排在前面)排成一个就绪队列。

- 处于waiting状态进程:处于等待状态的进程排在等待队列中。由于等待事件原因不同,等待队列也可以按事件分成几个队列。

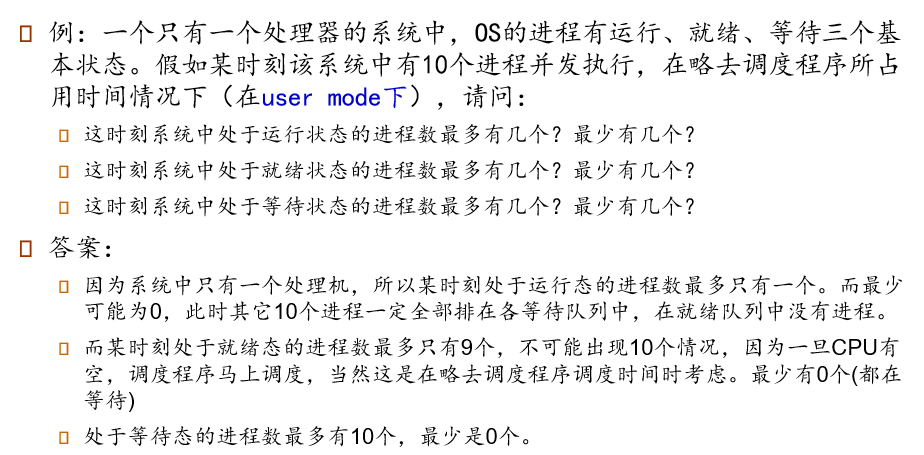

例:

3.1.5 进程与程序的区别

- 进程是动态的,程序是静态的:程序是有序代码的集合;进程是程序的执行

- 进程是暂时的,程序是永久的:进程是一个状态变化的过程,程序可长久保存

- 进程与程序的组成不同:进程的组成包括程序、数据和进程控制块(即进程状态信息)

- 进程与程序的对应关系:通过多次执行,一个程序可对应多个进程;通过调用关系,一个进程可包括多个程序

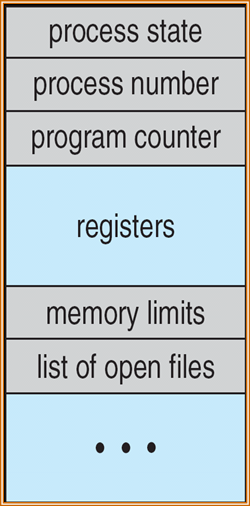

3.1.6 PCB 进程控制块

- 每个进程在操作系统内用进程控制块(Process Control

Block)来表示,它包含与特定进程相关的许多信息:

- Process state:进程状态

- Program counter:当前进程执行到的位置

- CPU registers:CPU中的寄存器

- CPU scheduling information:CPU的调度信息

- Memory-management information:内存管理信息

- Accounting information:统计信息

- File management :文件管理信息

- I/O status information:输入/输出状态信息

3.2 Process Scheduling 进程调度

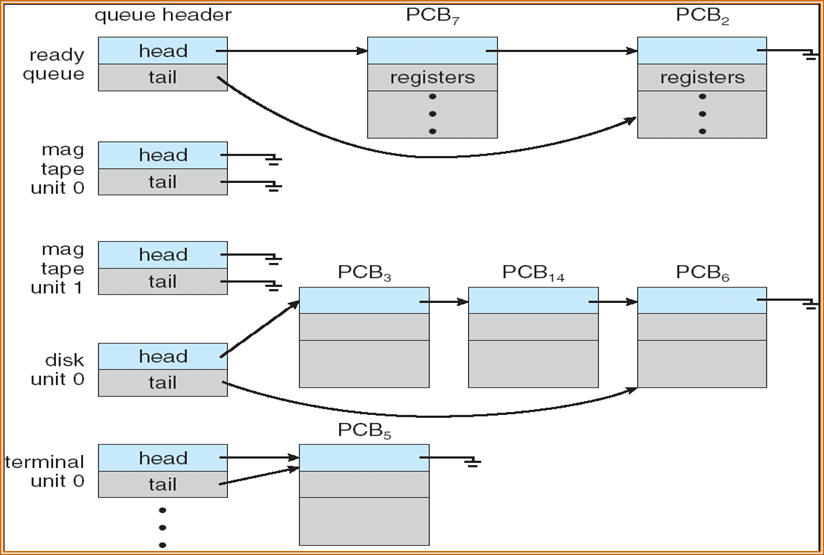

3.2.1 Scheduling Queue 调度队列

- Job queue作业队列:系统中所有进程的集合

- Ready queue就绪队列:驻留在主存中、就绪并等待执行的所有进程的集合

- Device queue设备队列:等待I/O设备的一组进程

进程会在不同队列之间迁移

进程调度的表示

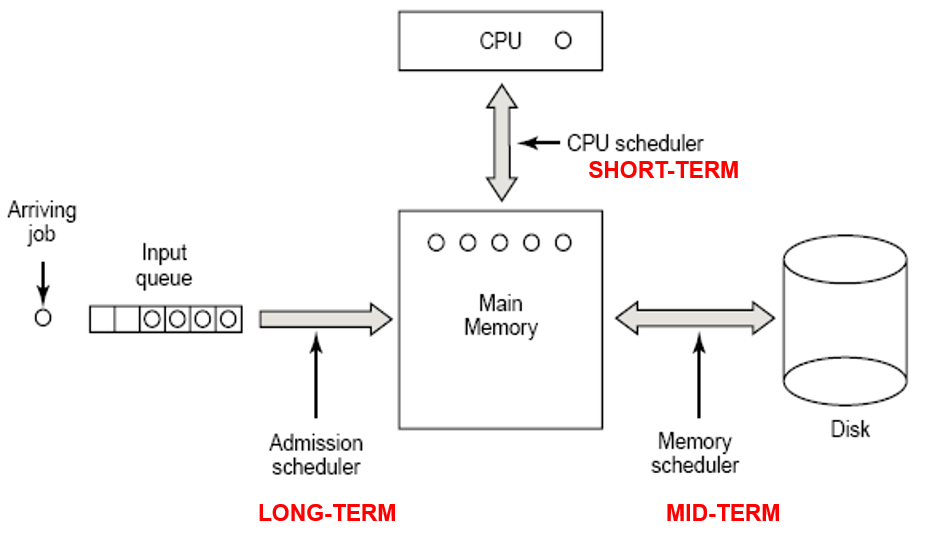

3.2.2 Schedulers 调度器

- Long-term scheduler / job scheduler:长程调度 /

作业调度

- 控制ready queue的长度:选择应加入ready queue的进程

- 调用的频率很低,基本上以秒/分钟为单位

- 控制多道程序设计multiprogramming的程度

- 大多数现代操作系统没有长期调度程序(如Windows、UNIX、Linux)

- Short-term scheduler / CPU scheduler:短程调度 /

CPU调度

- 选择ready queue中的哪一个进程能够进入CPU

- 调用的频率很好高,基本上以毫秒为单位

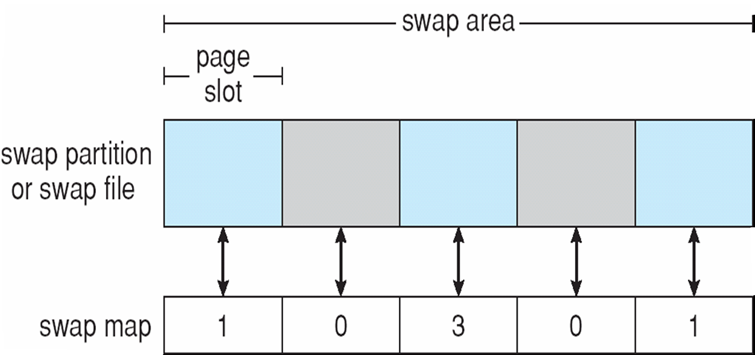

- Medium-Term Scheduler:中程调度

- 将一些进程从内存中临时移出,从而减少调度器须要处理进程的数目

- 这样将进程移出内存的机制叫做换出(Swapping)

- 按需调用,可以关闭中程调度

- 进程可以被分为:

- I/O-bound process:I/O型进程,需要做很多的I/O操作,有很多的CPU中断

- CPU-bound process:CPU型进程,需要很多的计算

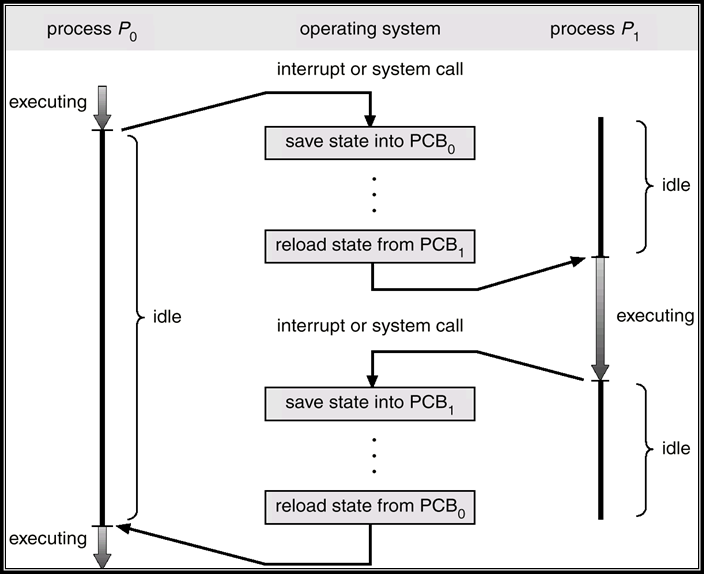

3.2.3 Context Switch 上下文切换

- 当CPU切换到另一个进程时,系统必须保存旧进程的状态,并通过上下文切换(Context Switch)加载新进程的保存状态

- 上下文切换时间开销大;系统在切换时没有任何有用的工作

- 时间取决于硬件支持

3.2.4 移动端的多任务

- 由于屏幕的实际情况,iOS的用户界面限制了

- 单个前台进程:通过用户界面控制

- 多个后台进程:内存中、正在运行,但不在显示器上,并且有限制

- 限制包括单个、短任务、接收事件通知、特定的长时间运行任务,如音频播放

- Android运行前台和后台,限制更少

- 后台进程使用服务执行任务

- 即使后台进程挂起,服务也可以继续运行

- 服务没有用户界面,占用内存少

3.3 Operations on Process 进程的操作

3.3.1 Process Creation 进程创建

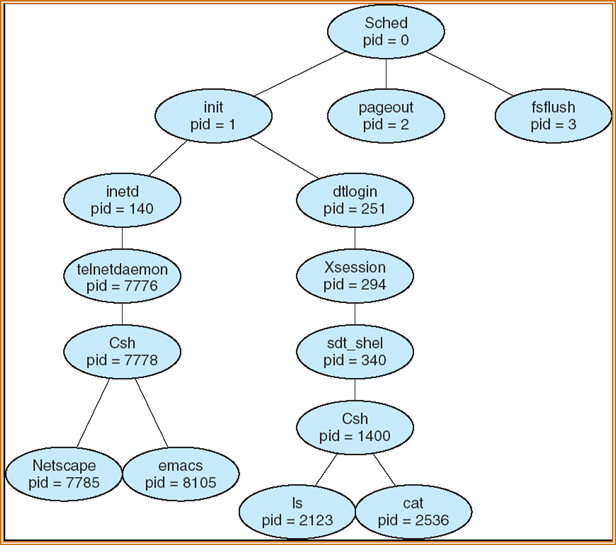

父进程创建子进程,子进程又创建其他进程,形成进程树

通常,通过进程标识符(process identifier,pid)识别和管理进程

资源共享:

- 父进程和子进程共享所有资源

- 子进程共享父进程资源的子集

- 父进程和子进程不共享资源

执行:

- 父进程和子进程同时执行

- 父进程一直等到子进程结束

地址空间:

- 子进程是父进程的副本

- 子进程已经加载进了一段程序

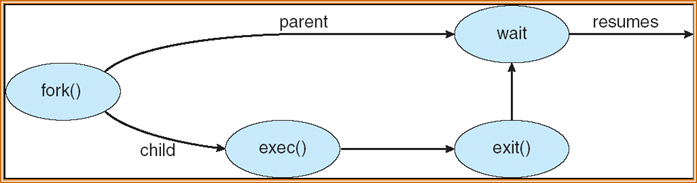

例:UNIX

- fork():系统调用,用于创建一个新的进程

- int pid1 = fork();

- 父进程使用fork创建子进程时,子进程会生成一份父进程的备份,除了返回值之外,两者完全一样

- 从系统调用fork中返回时,两个进程除了返回值pid1不同外,具有完全一样的用户级上下文

- 在子进程中,pid1的值为0

- 在父进程中, pid1的值为子进程的进程号

- exec():系统调用,用于在fork之后调用新程序,替换进程的内存空间

- exit():系统调用,终止子进程,并给父进程返回参数

- fork():系统调用,用于创建一个新的进程

C语言代码示例:进程的创建过程

|

3.3.2 Process Termination 进程终止

- 引起进程终止的事件

- 正常结束

- 异常结束

- 外界干预

- 进程执行完最后一条指令后,会询问操作系统如何终止它

- 从子进程向父进程输出数据

- 操作系统释放该进程的数据

- 如果父进程被终止,那么子进程会发生:

- 有些操作系统不会让子进程继续运行

- 子进程通过cascading termination终止运行

- 子进程被过继到另一个父进程

- 移动端操作系统

- 会因为系统资源不够,而终止一些进程

- 此时要有一个进程的优先级排序,从重要到不重要,排序如下:

- 前端进程

- 可见进程

- 服务进程

- 后台进程

- 空进程

- Android会优先终止最不重的进程

3.4 IPC:Interprocess Communication 进程通信

Independent Process:独立进程,不被其它进程的执行影响,也不能影响其它进程的执行

Cooperating Process:合作进程,可以其它进程的执行影响,也可以影响其它进程的执行

- 优点:

- 信息共享

- 加速计算

- 模块化

- 更加便捷

- 需要IPC:Interprocess Communication,进程通信

- 优点:

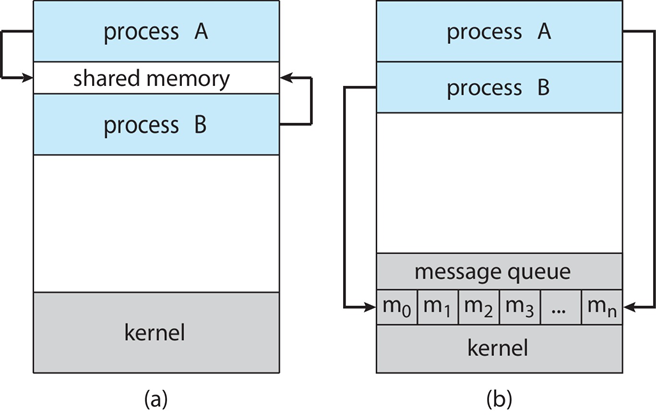

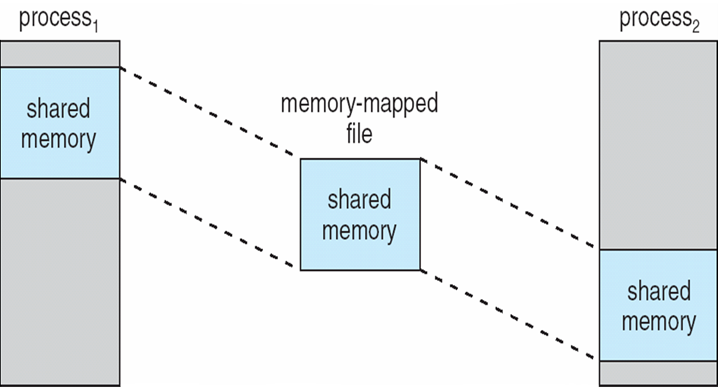

IPC的两种模式

- 共享内存

- 消息传递

通信类型:

- 直接通信

- send(P, message):直接发消息给进程P

- receive(Q, message):直接接收来自进程Q的消息

- 间接通信

- send(A, message):发送消息给邮件服务器A

- receive(A, message):从邮件服务器A接收消息

- 直接通信

常用通信机制:

- 信号(signal):进程发送信号

- 共享存储区(shared memory):不同进程共享一段空间,进行通信

- 管道(pipe):进程间通过一种操作将结果传输过去

- 消息(message)

- 套接字(socket)

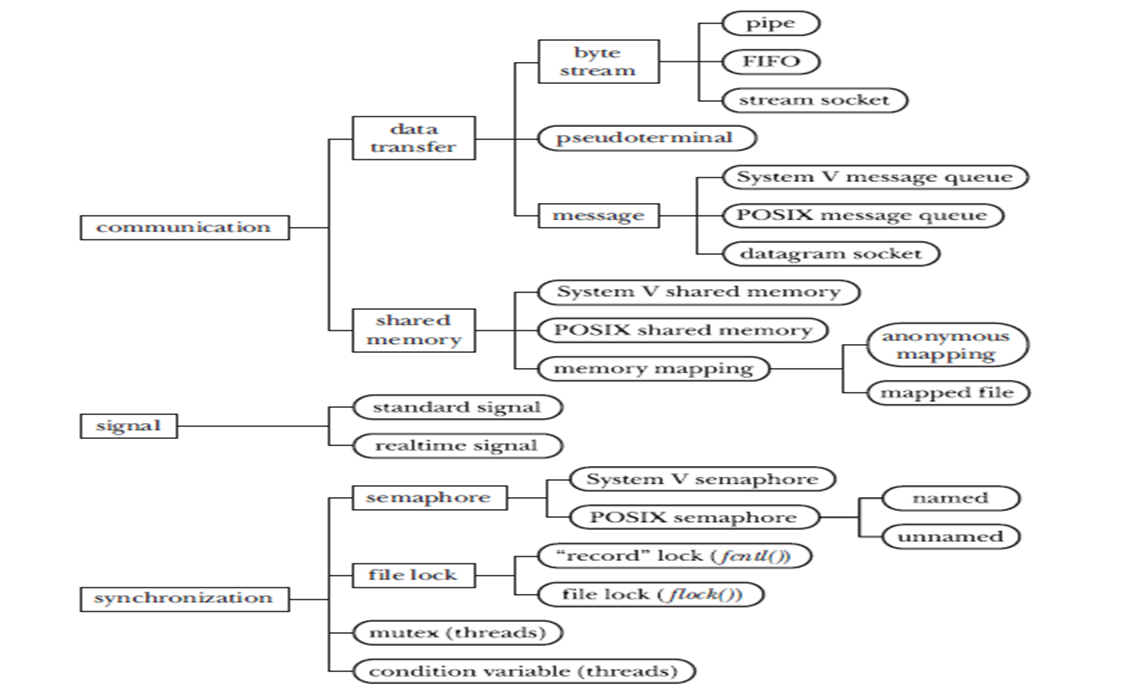

3.4.1 Linux进程通信机制

Linux实现进程间通信(IPC Inter Process Communication):

- System V IPC机制:

- 信号量:保证不同进程得到的信息是一样的

- 消息队列、

- 共享内存

- 管道(pipe)、命名管道

- 套接字(socket)

- 信号( signal )

- 文件锁(file lock)

- POSIX线程:

- 互斥锁(互斥体、互斥量)(mutex)、条件变量(condition variables)

- POSIX:

- 消息队列、信号、共享内存

3.4.2 Windows 进程线程通信机制

- 基于文件映射的共享存储区

- 无名管道和命名管道

- server32pipe.c、client32pipe.c

- 启动多个client进程进行通信

- 邮件槽

- 套接字

- 剪帖板(Clipboard)

- 信号

- 其他同步机制

3.5 IPC:in Shared-Memory Systems

- 希望通信的进程之间共享的内存区域

- 通信受用户进程的控制,而不是操作系统的控制

- 主要问题是:提供允许用户进程在访问共享内存时同步其操作的机制

- 在第6、7章会讨论同步

- 协同进程的并发执行需要允许进程相互通信并同步其操作的机制(第6章)。

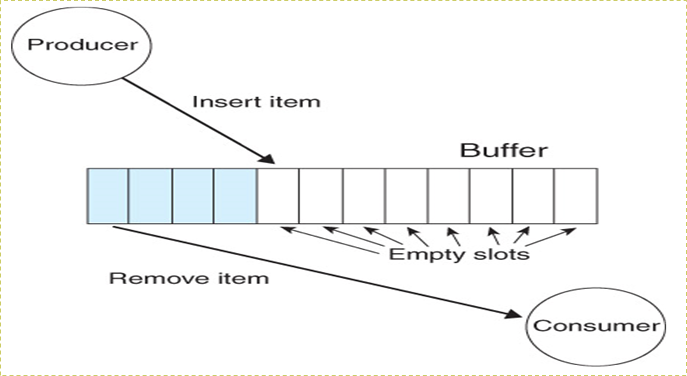

- 合作过程的共同范式:Producer-Consumer Problem(生产者-消费者问题)

- 生产者进程生成消费者进程使用的信息

- unbounded-buffer(无限缓冲区):对缓冲区的大小没有实际限制。

- bounded-buffer(有限缓冲区):假设存在固定的缓冲区大小。

3.5.1 Bounded-Buffer:Shared-Memory Solution

Shared data

typedef struct {

...

}item;

item buffer[BUFFER_SIZE];

int in = 0;

int out = 0;为了保证进程对共享空间的正确操作,只能使用BUFFER_SIZE-1的空间

- 空间是一个循环队列

Producer:生产者,生成数据

item nextProduced;

while (1) {

produce an item in nextProduced;

// buffer中没有空位, 什么都不做

while ((in + 1) % BUFFER_SIZE == out);

// 向buffer中添加一个item

buffer[in] = nextProduced;

in = (in + 1) % BUFFER_SIZE;

}Consumer:消费者,使用数据

item nextConsumed;

while (1) {

// buffer中没有item, 什么都不做

while (in == out);

// 从buffer中拿走一个item

nextConsumed = buffer[out];

out = (out + 1) % BUFFER_SIZE;

consume the item in nextConsumed ;

}

3.6 IPC:in Message-Passing Systems

- 进程通信和同步其操作的机制

- 消息系统:流程之间无需借助共享变量即可进行通信

- IPC设施提供两种操作:

- send(message)

- receive(message)

- message的大小是固定的或可变的

- 如果进程P和Q想要沟通,他们需要:

- 在他们之间建立通信联系

- 通过发送/接收交换message

- 实现的任务:

- 如何建立链接?

- 一个链接可以与两个以上的进程关联吗?

- 每对通信进程之间可以有多少个链接?

- 链路的容量是多少?

- 链接可以容纳的消息大小是固定的还是可变的?

- 链路是单向的还是双向的?

- 通信链路的实现

- 物理:

- 共享内存

- 硬件总线

- 网络

- 逻辑:

- 直接或间接

- 同步或异步

- 自动或显式缓冲

- 物理:

3.6.1 Direct Communication(直接通信)

- 进程必须明确命名:

- send(P, message):向进程P发送消息

- receive(Q, message):从进程Q接收消息

- 通信链路的属性

- 自动建立链接

- 链接只与一对通信进程相关联

- 每对之间只有一条链路

- 链接可能是单向的,但通常是双向的

3.6.2 Indirect Communication(间接通信)

- message从mailbox(也称为port)定向和接收

- 每个mailbox都有唯一的id

- 进程只有在共享mailbox时才能通信

- 通信链路的属性

- 仅当进程共享common mailbox时才建立链接

- 链接可能与许多进程关联

- 每对进程可以共享多个通信链路

- 链接可以是单向的或双向的

- 操作

- 创建新的mailbox(port)

- 通过mailbox发送和接收message

- 销毁mailbox

- 基本操作:

- send(A, message):将消息发送到邮箱A

- receive(A, message):从邮箱A接收消息

3.6.3 Synchronization同步

- 消息传递可以是阻塞的或非阻塞的

- Blocking(阻塞)被认为是同步的

- Blocking send:发送方被阻止,直到确认消息被收到

- Blocking receive:在消息可用之前,接收器被阻止

- Non-blocking(非阻塞)被认为是异步的

- Non-blocking send:发送方不断发送消息

- Non-blocking receive:接收器不断接收消息,可能是有效消息,也可能是Null消息

- 可能的不同组合

- 如果发送和接收都被是Blocking,称为完整性过程have a rendezvous

3.6.4 Buffering

- 附加到链接的消息队列,以三种方式之一实施

- 零容量

- 链路上没有消息排队

- 发送方必须等待接收方接收完成后,才能再次发送消息

- 容量有限

- n条消息的有限长度

- 如果链接已满,发送方必须等待

- 无限容量

- 无限长度

- 发送程序从不等待

- 零容量

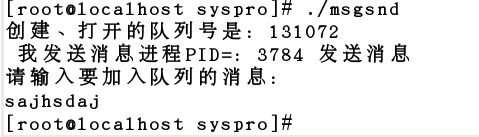

3.6.5 实例

- 例: 设计一个程序,要求

- 用函数msgget创建消息队列

- 从键盘输入的字符串添加到消息队列

- 创建一个进程,使用函数msgrcv读取队列中的消息并在计算机屏幕上输出

- 分析 :

- 程序先调用msgget函数创建、打开消息队列

- 接着调用msgsnd函数,把输入的字符串添加到消息队列中

- 子进程调用msgrcv函数,读取消息队列中的消息并打印输出

- 最后调用msgctl函数,删除系统内核中的消息队列

//msgfork.c |

分成两个独立的程序:msgsnd.c,msgrcv.c。分别编译和运行

3.7 IPC:example

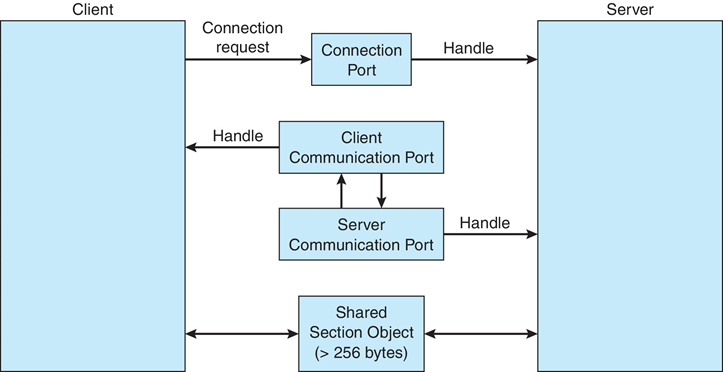

3.7.1 Windows

- 通过高级本地过程调用(LPC)功能以消息传递为中心

- 仅在同一系统上的进程之间工作

- 使用端口(如邮箱)建立和维护通信通道

- 通信工作如下:

- 客户端打开子系统连接端口对象的句柄

- 客户端发送连接请求

- 服务器创建两个专用通信端口,并将其中一个端口的句柄返回客户端

- 客户端和服务器使用相应的端口句柄发送消息或回调,并侦听回复

3.7.2 Pipe 管道通信

- 充当允许两个进程通信的管道

- 问题:

- 通信是单向的还是双向的?

- 在双向通信的情况下,是半双工还是全双工?(在工作时是否有一端读或写?)

- 沟通过程之间必须存在关系(即父子关系)吗?

- 管道可以通过网络使用吗?

- Ordinary pipes普通管道:无法从创建它的流程外部访问。通常,父进程创建个管道,并使用它与它创建的子进程通信。

- Named pipes命名管道:可以在没有父子关系的情况下访问。

3.7.2.1 Ordinary pipes

- 普通管道允许以标准 生产者-消费者 的形式进行通信

- 生产者写入一端(管道的写入端write-end)

- 消费者从另一端(管道的读取端read-end)读取

- 因此,普通管道是单向的

- 需要沟通流程之间的父子关系

- Windows调用这些匿名管道anoymous pipes

3.7.2.2 Named pipes

- 命名管道比普通管道更强大

- 通信是双向的

- 沟通过程之间不需要父子关系

- 多个进程可以使用命名管道进行通信

- 在UNIX和Windows系统上提供

3.8 Communication in Client–Server Systems

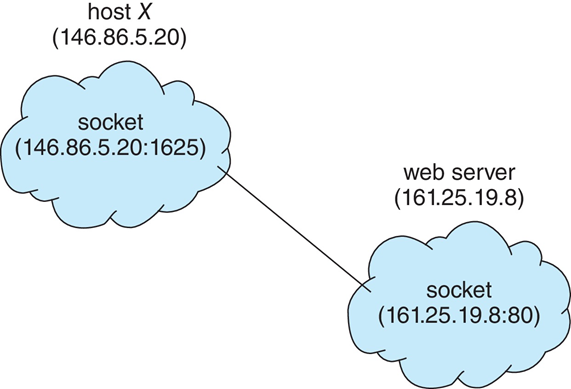

3.8.1 Socket 套接字

- Socket被定义为通信的端点

- IP地址和端口串联:消息包开头包含的数字,用于区分主机上的网络服务

- socket 161.25.19.8:1625指:主机161.25.119.8上的端口1625

- 通信由一对socket组成

- 1024以下的所有端口都是众所周知的,用于标准服务

- 特殊IP地址127.0.0.1(loopback),用于指运行进程的系统

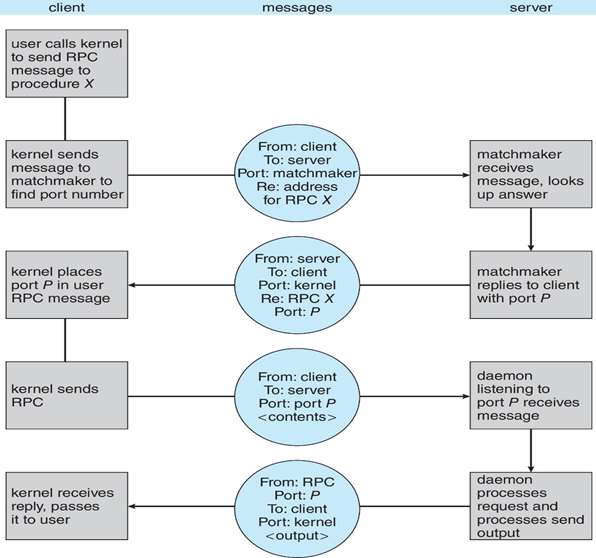

3.8.2 Remote Procedure Calls 远过程调用

- Remote Procedure

Calls(RPC,远过程调用):抽象网络系统上进程之间的过程调用

- 再次使用端口来区分服务

- 存根stubs:服务器上实际过程的客户端代理

- 客户端存根The client-side stub:定位服务器并整理(marshalls)参数

- 服务器端存根The server-side stub:接收此消息,解压缩编组参数,并在服务器上执行过程

- 在Windows上,stub代码根据用Microsoft接口定义语言(MIDL)编写的规范编译

- 通过外部数据表示(XDL,External Data

Representation)格式处理数据表示,以考虑不同的体系结构

- 大端和小端

- 远程通信比本地通信有更多的故障情况

- 消息只能传递确定的一次,而不能最多传递一次

- 操作系统通常提供rendezvous / matchmaker服务来连接客户端和服务器

- Android RPC的执行过程:

Chapter 4:Threads & Concurrency

4.1 Overview

进程:

- 资源拥有单位:

- 给每个进程分配一虚拟地址空间

- 保存进程映像

- 控制一些资源(文件,I/O设备)

- 有状态、优先级、调度

- 调度单位:

- 进程是由一个或多个程序的一次执行

- 可能会与其他进程交替执行

4.1.1 线程Thread的概念

- 进程:资源的拥有单元称为进程 / 任务

- 线程:资源的调度单位称为线程 /

轻型进程(light weight process)

- 线程只拥有在运行中必不可省的资源(PC、register、stack)

- 但它可与同属一个进程的其它线程共享进程拥有的全部资源

线程定义为:进程内一个执行单元或一个可调度实体

- 有执行状态(状态转换)

- 不运行时保存上下文

- 有一个执行栈

- 有一些局部变量的静态存储

- 可存取所在进程的内存和其他资源

- 可以创建、撤消另一个线程

4.1.2 线程的特点

- 不拥有系统资源(只拥有少量的资源,资源是分配给进程)

- 一个进程中的多个线程可并发执行(进程可创建线程执行同一程序的不同部分)

- 系统开销小、切换快。(进程的多个线程都在进程的地址空间活动)

4.1.3 线程的优点

- 创建一个新线程花费时间少(结束亦如此)

- 两个线程的切换花费时间少

- 如果机器设有 “存储[恢复]所有寄存器” 指令,则整个切换过程用几条指令即可完成

- 因为同一进程内的线程共享内存和文件,因此它们之间相互通信无须调用内核

- 适合多处理机系统

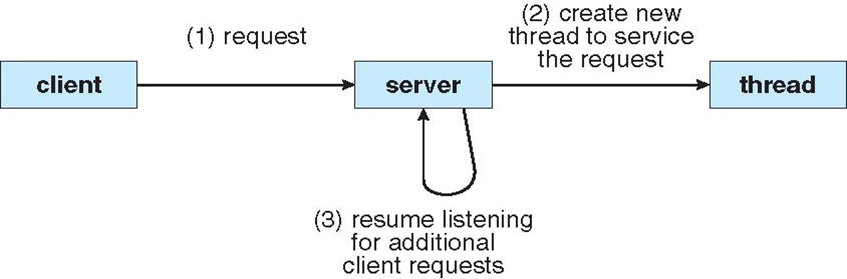

4.1.4 线程的使用案例

- LAN中的一个文件服务器,在一段时间内需要处理几个文件请求

- 有效的方法是:为每一个请求创建一个线程

- 在一个SMP机器上:多个线程可以同时在不同的处理器上运行

- 一个线程显示菜单,并读入用户输入;另一个线程执行用户命令

- 考虑一个应用:由几个独立部分组成,这几个部分不需要顺序执行,则每个部分可以以线程方式实现

- 当一个线程因I/O阻塞时,可以切换到同一应用的另一个线程

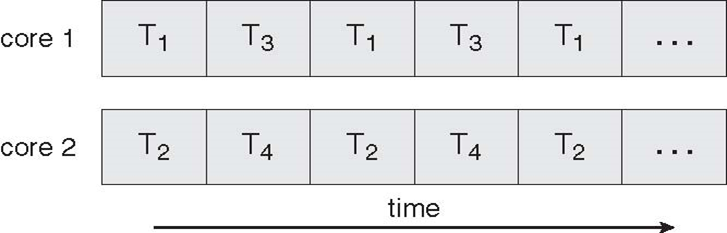

4.2 多核编程

多核系统给程序员带来新的挑战:

- 划分活动

- 负载均衡:保证任务的计算量尽量均衡

- 数据拆分

- 数据依赖性

- 测试和调试

多线程服务端结构

- 服务端、客户端各自是一个进程

- 当有请求时,服务端创建一个线程,处理请求

多核系统的并行执行:

4.3 Multithreading Models

线程的实现机制:

- 用户级线程 user-level thread

- 内核级线程 kernel-level thread

- 两者结合方法

4.3.1 User Threads 用户级线程

- 用户级线程:

- 不依赖于OS核心(内核不了解用户线程的存在)

- 应用进程利用线程库提供创建、同步、调度和管理线程的函数来控制用户线程

- 如:数据库系统informix、图形处理Aldus PageMaker

- 调度由应用软件内部进行,通常采用非抢先式和更简单的规则,也无需用户态/核心态切换,所以速度特别快

- 一个线程发起系统调用而阻塞,则整个进程在等待。

- 特点:

- 用户线程的维护由应用进程完成

- 内核不了解用户线程的存在

- 用户线程切换不需要内核特权

- 用户线程调度算法可针对应用优化

- 一个线程发起系统调用而阻塞,则整个进程在等待(多对一模型中)

- 三个主要的线程库(创建用户级线程)

- POSIX Pthreads 、 Win32 threads、 Java threads

4.3.2 Kernel Threads 内核级线程

- 内核级线程:

- 依赖于OS内核,由内核的内部需求进行创建和撤销,用来执行一个指定的函数

- 一个线程发起系统调用而阻塞,不会影响其他线程

- 时间片分配给线程,所以多线程的进程获得更多CPU时间

- 特点:

- 内核维护进程和线程的上下文信息

- 线程切换由内核完成

- 时间片分配给线程,所以多线程的进程获得更多CPU时间

- 如1个进程拥有10个线程,4个进程各自拥有1个线程,则CPU会对这14个线程进行分配资源

- 一个线程发起系统调用而阻塞,不会影响其他线程的运行

- Examples

- Windows XP/2000 及以后

- Solaris

- Linux

- Mac OS X

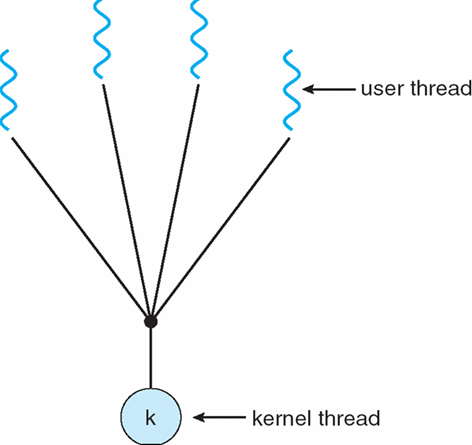

4.3.3 Many-to-One 多个用户线程, 一个内核线程

多个用户级线程 映射到 单个内核线程

由用户级运行库实现

- 在用户级别创建、调度和同步线程

操作系统不知道用户级线程

- 操作系统认为每个进程只包含一个控制线程

示例:

- Solaris Green Threads

- GNU Portable Threads

优点:

- 不需要操作系统支持,全部在用户态模式进行

- 可以由用户自己设定调整调度策略,以满足应用程序需求

- 由于没有系统调用,因此降低了线程操作的开销

缺点:

- 无法利用多处理器,不是没有真正并行,而是在多个用户级线程之间进行轮转

- 当一个线程阻塞时,整个进程块也会阻塞

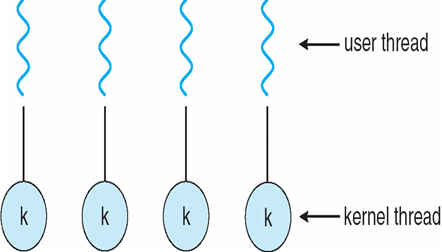

4.3.4 One-to-One 一个用户线程, 一个内核线程

每个用户级线程 都映射到 内核线程

- 操作系统为每个用户级线程提供一个内核线程

- 每个内核线程独立调度

- 操作系统执行的线程操作(创建、调度、同步)

- 示例

- Windows NT/XP/2000操作系统

- Linux操作系统

- Solaris 9及更高版本

- 优点:

- 每个内核线程在多处理器中,均可平行执行

- 当一个线程阻塞时,其它线程还能被正常调度

- 缺点:

- 线程间的操作消耗过大

- 操作系统会随着线程数目的增加而变大

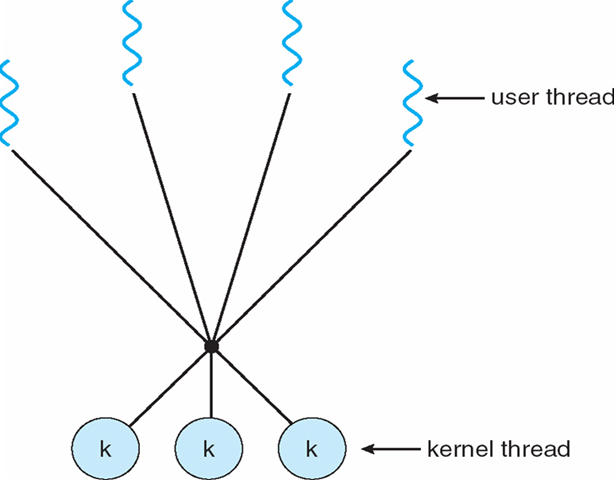

4.3.5 Many-to-Many 多个用户线程, 多个内核线程

将多个用户级线程 映射到 多个内核线程

- 允许操作系统创建足够数量的内核线程

- 示例:

- Solaris版本9之前的版本

- 带有ThreadFiber软件包的Windows NT/2000

4.3.6 Two-level Model 两级模型

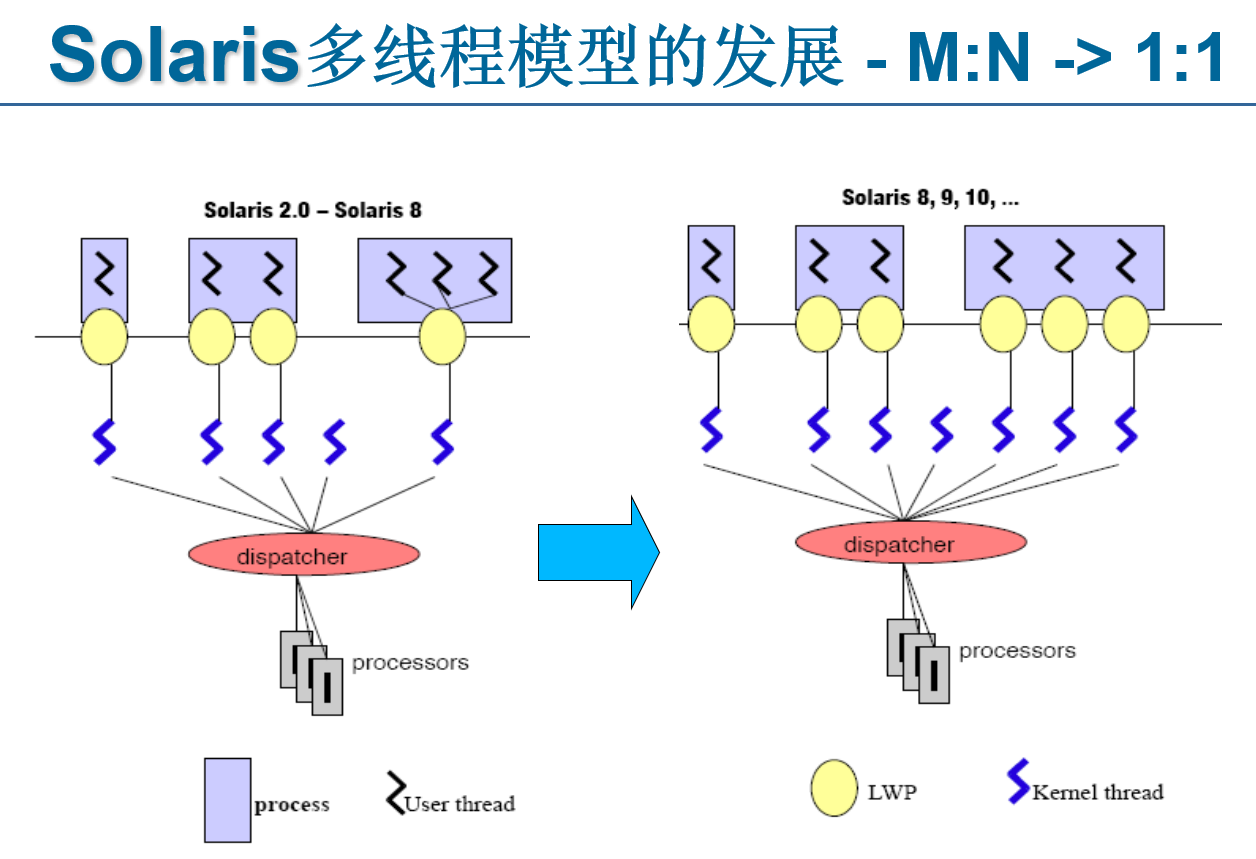

- Solaris的多线程是与传统UNIX调度模型相区别的主要特征

- LWP:每个进程内的内核线程的虚拟执行环境

- LWP允许进程内的内核线程互相独立地进行系统调用

- 如果没有LWP,一次就只能进行一次系统调用

- 每次的系统调用由一个线程来引发,它的寄存器会被放在LWP的堆栈里面,等它返回的时候,系统调用返回代码也会被放在LWP里面

- M-N的优点:

- 快速的用户线程创建和删除

- 线程同步不需要系统调用

- 快速的用户线程上下文切换

- M-N的缺点:

- 复杂的编程模型

- 信号处理的问题

- 1-1模型的优点:

- 每个用户级线程都有一个lwp和一个 kthread 相对应

- 只有内核级的线程调度

- 线程创建和删除、线程同步的开销大

- 线程调度和同步更到位

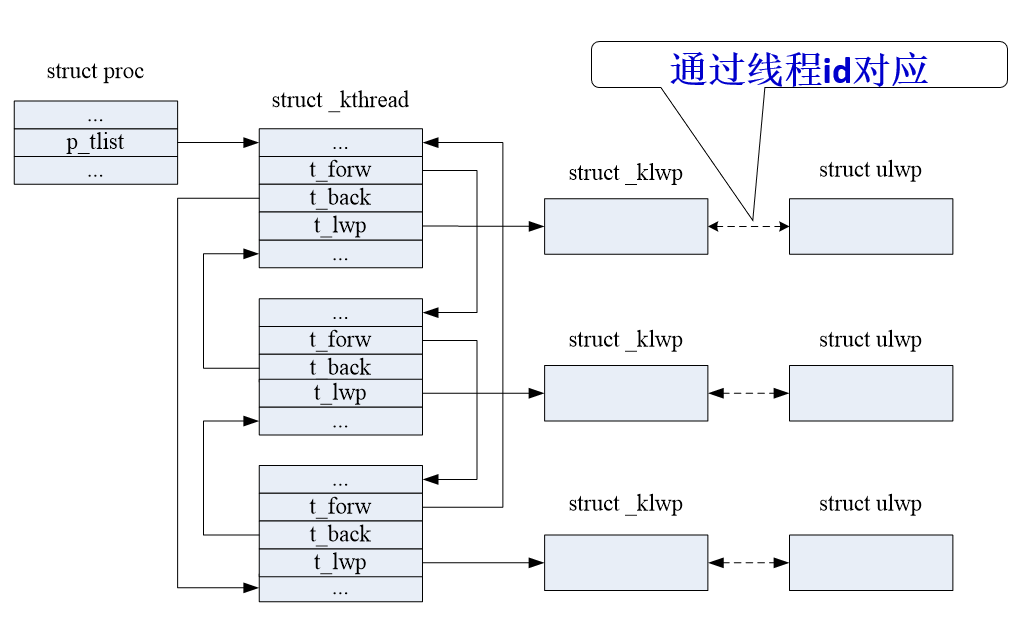

4.3.7 Solaris用户线程、内核线程、LWP三者之间的关系

- 对于一个用户进程来说,它的每个线程分成两个部分,一个部分是用户态下的部分,一个是系统态下的部分,也就是用户线程和内核线程

- 一个线程在用户态下执行的时候,运行的是用户线程的代码,而当发生系统调用的时候,就由内核线程来执行内核代码

- 在Solaris的线程模型中,每一个用户线程对应一个内核线程,这种对应通过lwp来体现。

- 所用的内核线程串成一个双向循环链表,可以通过进程的proc结构中的p_tlist字段找到这个链表

- 每一个lwp用_ klwp数据结构表示,每个内核线程用一个_ kthread结构表示,_ kthread结构中有一个字段t_lwp指向它所对应的**_klwp**结构。

- 用户线程用ulwp表示,ulwp与**_kthread的对应不是用指针来表示的,而是通过线程id**

- ulwp,**_kthread和_klwp中都有一个字段表示线程的id,通过id**它们就可以一一对应起来

4.4 Thread Libraries 线程库

- 线程库为程序员提供了创建和管理线程的API

- 实施的两种主要方式

- 没有内核支持的库:代码和数据结构都在用户空间,只导致用户空间中本地函数调用(而不是系统调用)

- 由操作系统直接支持的内核级库:代码和数据结构都在内核空间,通常导致系统调用

4.4.1 Pthread

可以作为用户级或内核级提供

用于线程创建和同步的POSIX(Portable Operating System Interface,便携式操作系统接口)标准(IEEE 1003.1c)API

http://standards.ieee.org/reading/ieee/stad_public/description/posix

API指定线程库的行为,实现取决于库的开发

在UNIX操作系统(Solaris、Linux、Mac OS X)中常见

4.4.2 Java Threads

- Java线程由JVM管理

- 通常使用底层OS提供的线程模型实现

- Java线程可以通过以下方式创建:

- extend 线程类

- 实现Runnable接口

4.5 Implicit Threading 隐私多线程

- 多核系统多线程编程,一个应用程序有可能有几百个甚至上千的线程,这样的程序面临许多挑战

- 编程挑战:任务分解、任务的工作量平衡、数据分割、数据依赖、测试与调试

- 程序执行顺序的正确性问题:同步、互斥

- 策略:隐私线程Implicit

Threading,当前一种流行趋势

- 将线程的创建与管理交给编译器和运行时库来完成

- 几种隐私线程的设计方法:

- Thread Pools:线程池

- Fork Join

- OpenMP:用于共享内存并行系统的多处理器程序设计的一套指导性编译处理方案

- OpenMP支持的编程语言包括C、C++和Fortran。

- Grand Central Dispatch(GCD,大中央调度)

- Apple for its macOS and iOS operating systems.

- Intel Thread Building Blocks(TBB):

- Intel开发的构建多线程库,open source

- TBB是一个可移植的C++库,能够运行在Windows、Linux、Macintosh以及UNIX等系统上

- Java

4.5.1 Thread Pool 线程池

- 预先创建出一系列线程,然后分配

- 线程池中如果没有空余线程,则需要等待

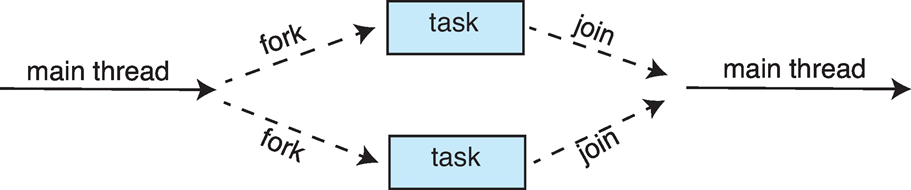

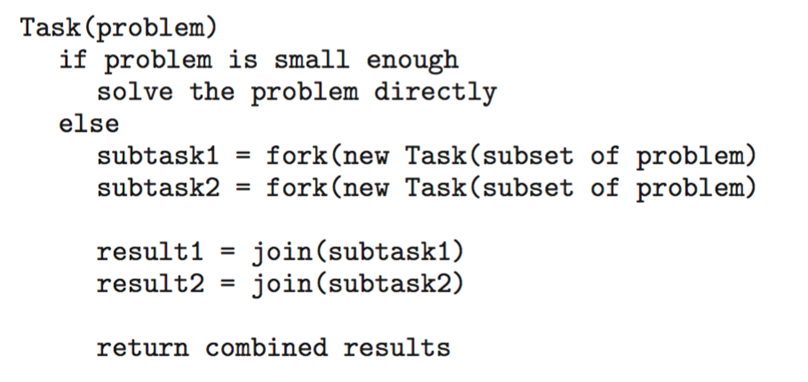

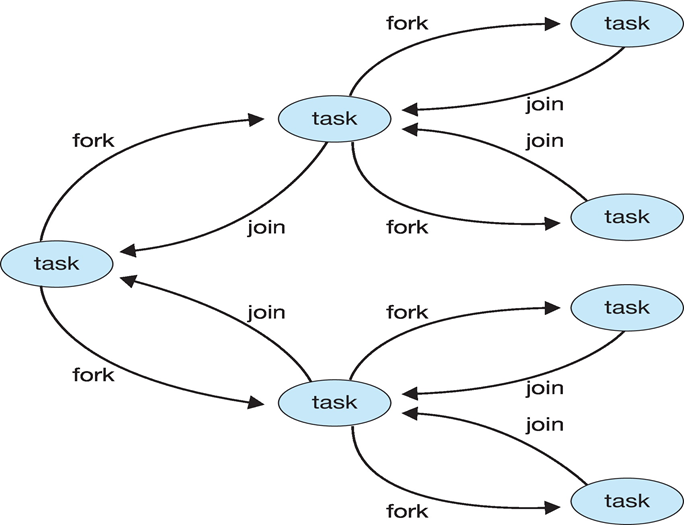

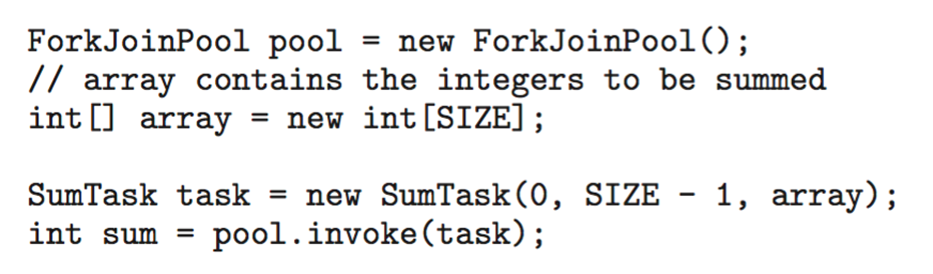

4.5.2 Fork-Join Parallelism

主线程将任务分为多个子任务fork,然后再合并到主线程join

伪代码

这一过程可以递归的进行

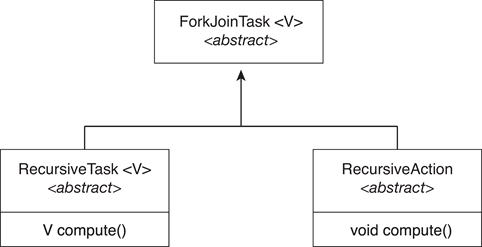

示例:

- The ForkJoinTask is an abstract base class

- RecursiveTask and RecursiveAction classes extend ForkJoinTask

- RecursiveTask returns a result (via the return value from the compute() method)

- RecursiveAction does not return a result

4.5.3 OpenMP

编译器指令集和C、C++、FORTRAN的API

为共享内存环境中的并行编程提供支持

标识并行区域–可以并行运行的代码块

int main(){

/* 串行代码 */

{

printf("I am a parallel region.");

}

for(int i = 0; i < N; i++)

c[i] = a[i] + b[i];

/* 串行代码 */

return 0;

}

4.5.4 Grand Central Dispatch

用于macOS和iOS操作系统的Apple技术

C、C++和Objective-C语言、API和运行时库的扩展

允许识别平行部分

管理线程的大部分细节

块位于“^{}”:

^{printf("I am a block");}

Block放置在调度队列中

- 从队列中移除时,分配给线程池中的可用线程

两种类型的调度队列:

- 串行:按FIFO的顺序删除块,队列按进程,称为主队列

- 程序员可以在程序中创建额外的串行队列

- 并行:按FIFO的顺序删除块,但一次可以删除多个

- 按服务质量划分的四个全系统队列:

- QOS_CLASS_USER_INTERACTIVE

- QOS_CLASS_USER_INITIATED

- QOS_CLASS_USER_UTILITY

- QOS_CLASS_USER_BACKGROUND

- 串行:按FIFO的顺序删除块,队列按进程,称为主队列

对于Swift语言,任务定义为闭包,类似于块,减去插入符号

- 使用dispatch_async()函数将闭包提交到队列

let queue = dispatch.get.global.queue(QOS.CLASS.USER/INITIATED, 0)

dispatch.async(queue, {print("I am a closure.")} )

4.5.5 Intel Threading Building Blocks (TBB)

用于设计并行C++程序的模板库

简单for循环的串行版本

for(int i = 0; i < n; i++)

apply(v[i]);使用TBB的parallel_for语句编写的for循环:

parallel_for(size_t(0), n, [=](size_t i){ apply(v[i]); } );

4.6 Threading Issues

- fork()和exec()系统调用的语义

- 目标线程的线程删除

- 异步或延迟

- 信号处理

- 线程池

- 线程特定数据

- 调度器激活

4.6.1 fork()和exec()的语义

- fork():有的Unix系统有两种形式的fork(),与应用程序有关

- 复制所有线程:如果调用fork()后不调用exec(),复制所有线程

- 只复制调用fork()的线程:如果调用fork()后立即调用exec(),操作系统只需复制调用fork()的线程

- exec():如果一个线程调用exec(),exec()参数指定的程序会替换整个进程(包括所有线程)

4.6.2 Thread的删除

- 线程取消(thread cancellation):在线程完成之前终止线程的任务,要取消的线程称为目标线程

- 线程取消的两种情况:

- 异步取消(asynchronous

cancellation):由一个线程立即终止目标线程。

- 对于异步取消,因为如果在已经给目标线程分配资源或目标线程正在更新与其他线程共享的数据的情况下,操作系统从回收系统资源时不能将所有资源全部回收。

- 延迟取消(deferred cancellation):目标线程周期性地检查其是否应该终止,允许目标线程以有序方式终止自己

- 异步取消(asynchronous

cancellation):由一个线程立即终止目标线程。

4.6.3 Signal Handling 信号处理

- UNIX系统中使用信号通知进程发生了特定事件

- 信号处理器用于处理信号

- 信号由特定事件生成

- 信号被传递到进程

- 信号已处理

- Options:

- 将信号传递给信号适用的线程

- 将信号传递给进程中的每个线程

- 将信号传递给进程中的某些线程

- 分配特定线程以接收进程的所有信号

- 信号可分为同步和异步:

- 同步信号:被发送到产生信号的同一进程

- E.g. 非法访问内存、被0所除

- 异步信号:由运行进程之外的事件产生,通常被发送到另一进程

- E.g. 使用特殊键、定时器到期

- 同步信号:被发送到产生信号的同一进程

4.6.4 Thread Pool 线程池

- 多线程服务器的潜在问题:

- 处理请求前创建线程需要时间,线程完成工作后要被丢弃;

- 如果允许所有并发请求都用新线程处理,则无法限制系统中并发执行的线程数量,大量消耗系统资源

- 在等待工作的池中创建多个线程

- 优点:

- 使用现有线程服务请求通常比创建新线程稍快

- 允许将应用程序中的线程数绑定到池的大小

4.6.5 Thread Specific Data 线程特有数据

- 允许每个线程拥有自己的数据副本

- 当您无法控制线程创建过程时(即使用线程池时),此功能非常有用

4.6.5 Scheduler Activations 调度器激活

- M:N和两级模型都需要通信来维护分配给应用程序的适当数量的内核线程

- 轻量级进程(Lightweight process, LWP):实现多对多模型或二级模型的系统在用户线程和内核线程之间通常设置一种中间数据结构,通常为LWP。

- 对于用户线程库,LWP表现为一种应用程序可以调度用户线程来运行的虚拟处理器。每个LWP与内核线程相连,该内核线程被操作系统调度到物理处理器上运行。如果物理处理器上运行的内核线程阻塞,则与其相连的LWP也阻塞,关系链顶端与LWP相连的用户线程也阻塞

- 调度程序激活提供了向上调用:一种从内核到线程库的通信机制

- upcall:内核通知应用程序与其有关的特定事件的过程;

- upcall handler:upcall处理句柄,在虚拟处理器(LWP)上运行。

- 此通信允许应用程序维护正确数量的内核线程

调度器激活(scheduler activation):一种解决用户线程与内核间通信的方法。

- 工作方式:内核提供一组LWP给应用程序,应用程序可调度用户线程到一个可用的LWP上。

- 当一个应用线程将要阻塞时,事件引发内核发送upcall到应用程序,通知应用程序线程阻塞并标识特殊线程

- 内核分配一个新的LWP给应用程序

- 应用程序在该新LWP上运行upcall handler:

- 保存该阻塞线程的状态

- 放弃阻塞线程运行的原虚拟处理器

- upcall handler调度另一个适合在新LWP上运行的线程

- 当原先阻塞的线程准备好执行时,内核发送另一个upcall到线程库,通知线程库原先阻塞的线程已经能够运行了

- 内核可能分配一个新的LWP

- 或抢占一个用户线程并在其LWP用于运行处理该事件的upcall handler

- 应用程序将已处于未堵塞状态的线程标记为“能够运行”,调度一条合适的线程到可用LWP上运行

4.7 Operating-System Examples

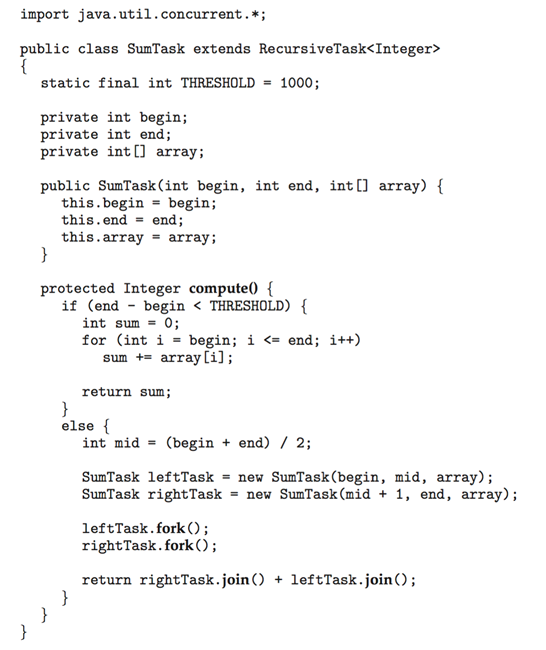

4.7.1 Windows XP Thread

- 应用程序以独立进程方式运行,每个进程可包括一个或多个线程

- 使用一对一映射,也提供对fiber库的支持(多对多模型)

- 每个线程包含

- 线程id

- 寄存器集

- 独立的用户堆栈和内核堆栈

- 专用数据存储区

- 寄存器集、堆栈和专用存储区域称为线程的上下文

- 同属一个进程的每个线程都能访问进程的地址空间

- 线程的主要数据结构包括:

- ETHREAD(executive thread block):执行线程块,包括指向线程所属进程的指针、线程开始控制的子程序的地址、指向KTHREAD的指针

- KTHREAD(kernel thread block):内核线程块,包括线程的调度和同步信息、指向内核栈的指针、指向TEB的指针

- TEB(thread environment block):用户空间的数据结构,供线程在用户模式下运行时访问,包含许多其他域、用户模式栈、用于线程特定数据的数组

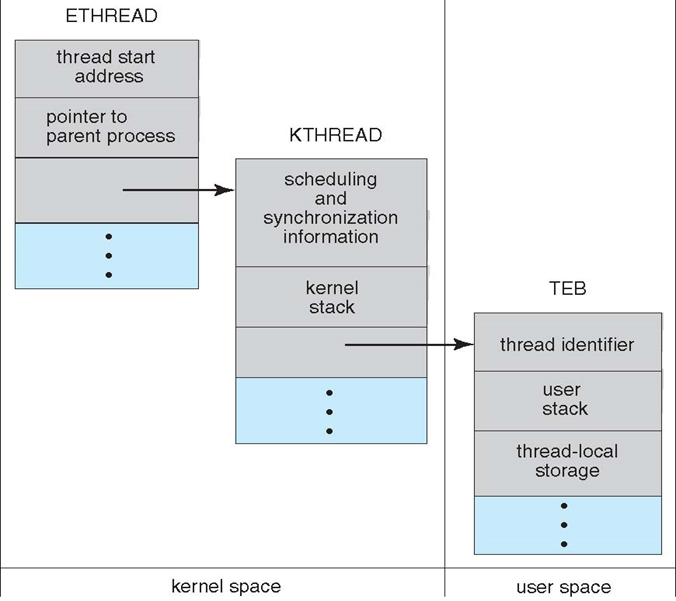

4.7.2 Linux Threads

Linux不区分进程和线程,通常称之为任务(task)

- Task_struct:Linux系统中每个任务都有一个唯一的内核数据结构struct task_struct,它并不保存任务本身的数据,而是指向其他存储这些数据的数据结构(e.g. 打开文件列表、信号处理信息、虚拟内存等)的指针

系统调用fork()提供传统进程复制功能,系统调用clone()提供创建线程功能。

调用fork()时,所创建的新任务具有父进程所有数据的副本

调用clone()时,所创建新任务根据所传递标志集指向父任务的数据结构。

调用clone()时传递一组标志,决定父任务与子任务之间发生多少共享

Chapte 5:CPU Scheduling

5.1 基础概念 Basic Concepts

5.1.1 CPU调度

CPU调度 == 处理器调度 == 进程调度

最大化CPU的利用率

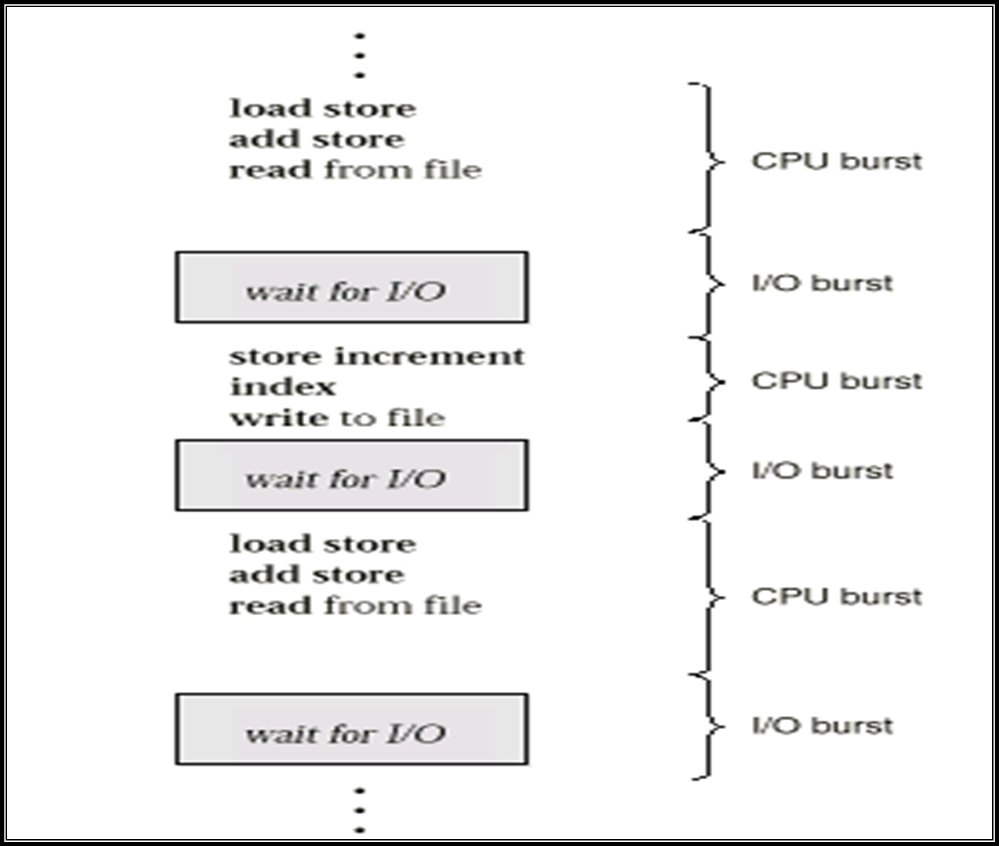

进程执行的特点:CPU Burst 和 I/O Burst交替进行

- CPU Burst Time,I/O Burst Time

- CPU-bound program:以CPU计算为主的程序

- I/O-bound program:以I/O为主的程序

- 只考虑进程的CPU Burst Time

进程的CPU Burst Time的统计规律

- 短时间的CPU Burst Time占据绝大部分

- 因此CPU调度是高频调度

5.1.2 CPU调度器 Scheduler

- 调度器起作用的时机:

- 进程从running到waiting状态

- 进程从running到ready状态

- 进程从waiting到ready状态

- 进程终止

- 调度方式:

- Nonpreemptive非抢占式调度:

- 调度程序一旦把处理器分配给某进程后,它便会一直运行下去,直到进程完成或发生某事件而阻塞时,才把处理器分配给另一个进程

- 调度时机:上述1、4

- Preemptive抢占式调度:

- 当一个进程正在运行时,系统可以基于某种原则,剥夺已分配给它的处理机,将之分配给其它进程

- 剥夺原则有:优先权原则、短进程优先原则、时间片原则

- 调度时机:上述2、3

- Nonpreemptive非抢占式调度:

5.1.3 调度程序 Dispatcher

- 实际执行调度的模块,任务如下:

- 切换上下文

- 切换到user mode

- 跳转到user program中正确的位置,并且重新启动program

- Dispatcher Latency调度延迟:调度程序停止一个进程到启动一个进程所需要的时间

5.2 调度标准 Scheduling Criteria

5.2.1 调度算法的选择准则和评价

- 面向用户(User-oriented)的准则和评价

- 周转时间Turnaround

time:进程从提交到完成所经历的时间。包括:在CPU上执行,就绪列和阻塞队列中等待。

- 周转时间 T = 完成时间 - 提交时间

- 平均周转时间 = \(\sum\) 周转时间/进程数

- 带权周转时间W = T(周转时间)/t(CPU执行时间)

- 平均带权周转时间 = \(\sum\) W/进程数

- 响应时间Response

time:从进程提出请求到首次被响应的时间段

- 第一次被调度到,而不是输出结果

- 在分时系统环境下

- 等待时间Waiting time:进程在就绪队列中等待的时间总和

- 截止时间:开始截止时间和完成截止时间

- 实时系统,与周转时间有些相似

- 开始截止时间:在某个时间点之前必须开始

- 完成截止时间:在某个时间点之前必须完成

- 公平性:不因作业或进程本身的特性而使上述指标过分恶化

- 如长进程等待很长时间

- 不同进程之间的上述指标不能差异过大

- 优先级:可以使关键任务达到更好的指标

- 周转时间Turnaround

time:进程从提交到完成所经历的时间。包括:在CPU上执行,就绪列和阻塞队列中等待。

- 面向系统的调度性能准则

- 吞吐量Throughput:单位时间内所完成的进程数

- 跟进程本身特性和调度算法都有关系

- 批处理系统

- 平均周转时间不是吞吐量的倒数,因为并发执行的进程在时间上可以重叠

- 如:在2小时内完成4个进程,而每个周转时间是1小时,则吞吐量是2个进程/小时

- 处理器利用率CPU utilization:使CPU尽可能的忙碌

- 各种设备的均衡利用:

- 如CPU繁忙的进程和I/O繁忙的进程搭配

- 大中型主机

- 吞吐量Throughput:单位时间内所完成的进程数

- 调度算法本身的调度性能准则

- 易于实现

- 执行开销比较小

5.2.4 最优准则 Optimization Criteria

- 最大的CPU利用率 Max CPU utilization

- 最大的吞吐量 Max throughput

- 最短的周转时间 Min turnaround time

- 最短的等待时间 Min waiting time

- 最短的响应时间 Min response time

- 公平

5.3 调度算法 Scheduling Algorithms (计算)

| 算法名 | 注释 |

|---|---|

| First-Come, First-Served (FCFS) Scheduling | 先来先服务调度 |

| Shortest-Job-First (SJF) Scheduling | 短作业优先调度 |

| Priority Scheduling | 优先权调度 |

| Round Robin (RR) | 时间片轮转调度 |

| Multilevel Queue Scheduling | 多级队列调度 |

| Multilevel Feedback Queue Scheduling | 多级反馈队列调度 |

- 高响应比优先调度算法:Highest Response Ratio

Next(HRRN)

- 响应比R = (等待时间 + 要求执行时间) / 要求执行时间

5.3.1 先来先服务调度 FCFS

5.3.1.1 算法内容

FCFS算法:First-Come, First-Served Scheduling

- 按照进程或作业提交顺序形成就绪状态的先后次序,分派CPU

- 当前进程或作业占用CPU,直到执行完或阻塞,才出让CPU(非抢占方式)

- 在进程或作业唤醒后(如I/O完成),并不立即恢复执行,通常等到当前作业或进程出让CPU

- 最简单的算法

FCFS的特点

- 比较有利于长进程,而不利于短进程

- 有利于CPU Bound的进程,而不利于I/O Bound的进程

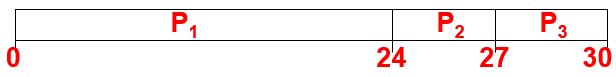

5.3.1.2 示例

| Process | Burst Time |

|---|---|

| P1 | 24 |

| P2 | 3 |

| P3 | 3 |

Gantt Chart:根据进程的顺序排列,下标画时间点

Turnaround Time:终止时间 - 到达时间

- P1 = 24,P2 = 27,P3 = 30

- Average Turnaround Time = (24 + 27 + 30) / 3 = 27

Waiting Time:Turnaround Time - 实际运行的时间

- P1 = 24 - 24 = 0,P2 = 27 - 3 = 24,P3 = 30 - 3 = 27

- Average Waiting Time = (0 + 24 + 27) / 3 = 17

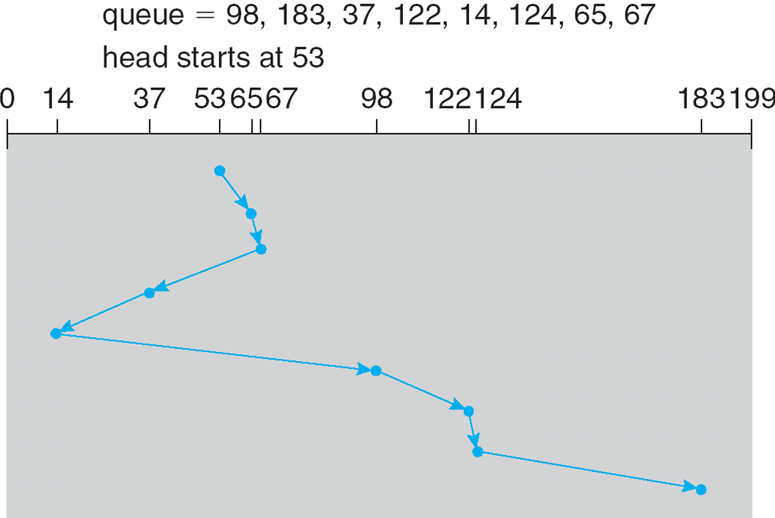

5.3.2 短作业优先调度 SJF

5.3.2.1 算法内容

SJF算法:Shortest-Job-First (SJF) Scheduling

- 对预计执行时间短的作业(进程)优先分派处理器

- 又称为“短进程优先”SPF(Shortest Process First),这是对FCFS算法的改进,其目标是减少平均周转时间

两种模式

- 非抢占nonpreemptive:一旦CPU被赋予进程,它就不能被抢占,直到完成其CPU Burst

- 抢占preemptive:如果新进程到达时CPU

Burst长度小于当前执行进程的剩余时间,则抢占

- 该方案被称为最短剩余时间优先(SRTF,Shortest-Remaining-Time-First)

优点:平均等待时间最小

5.3.2.2 最短剩余时间优先 SRTF

最短剩余时间优先SRTF(Shortest Remaining Time First):基于抢占的SJF算法

允许比当前进程剩余时间更短的进程来抢占

5.3.2.3 最高响应比优先 HRRN

- 最高响应比优先HRRN(Highest Response Ratio Next)

- 响应比R = (等待时间 + 要求执行时间) / 要求执行时间

- 是FCFS和SJF的折中

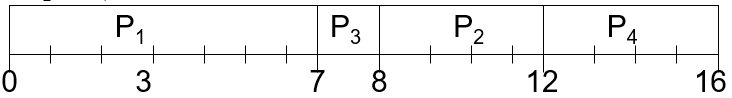

5.3.2.4 示例

| Process | Arrival Time | Burst Time |

|---|---|---|

| P1 | 0 | 7 |

| P2 | 2 | 4 |

| P3 | 4 | 1 |

| P4 | 5 | 4 |

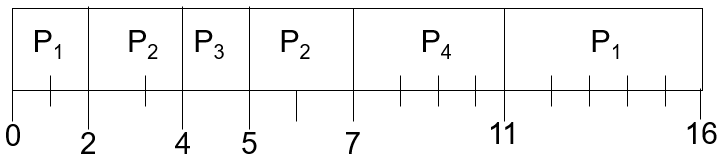

- SJF (non-preemptive):

- 第0时刻只有P1到来,因此先执行P1

- P1结束后为第7时刻,此时的进程有P2, P3, P4,P3的Burst Time最短,因此执行P3

- Turnaround Time

- P1 = 7 - 0 = 7,P2 = 12 - 2 = 10,P3 = 8 - 4 = 4,P4 = 16 - 5 = 11

- Average Turnaround Time = (7 + 10 + 4 + 11) / 4 = 8

- Waiting Time

- P1 = 0 - 0 = 0,P2 = 8 - 2 = 6,P3 = 7 - 4 = 3,P4 = 12 - 5 = 7

- Average Waiting Time = (0 + 6 + 3 + 7) / 4 = 4

- SJF (preemptive):

- 第2时刻,P2到来,其时间比P1剩余时间短,因此打断P1,执行P2

- 第4时刻,P3到来,其时间比P2剩余时间短,因此打断P2,执行P3

- 第5时刻,P3结束,此时等待队列如下,因此执行P2

- P1:5s

- P2:2s

- 第7时刻,P2结束,P4到来,此时等待队列如下,因此执行P4

- P1:5s

- P4:4s

- 第11时刻,P4结束,执行P1

- Turnaround Time

- P1 = 16 - 0 = 16,P2 = 7 - 2 = 5,P3 = 5 - 4 = 1,P4 = 11 - 5 = 6

- Average Turnaround Time = (16 + 5 + 1 + 6) / 4 = 7

- Waiting Time

- P1 = (0 - 0) + (11 - 2) = 9,P2 = (2 - 2) + (5 - 4) = 1,P3 = 4 - 4 = 0,P4 = 7 - 5 = 2

- Average Waiting Time = (9 + 1 + 0 + 2) / 4 = 4

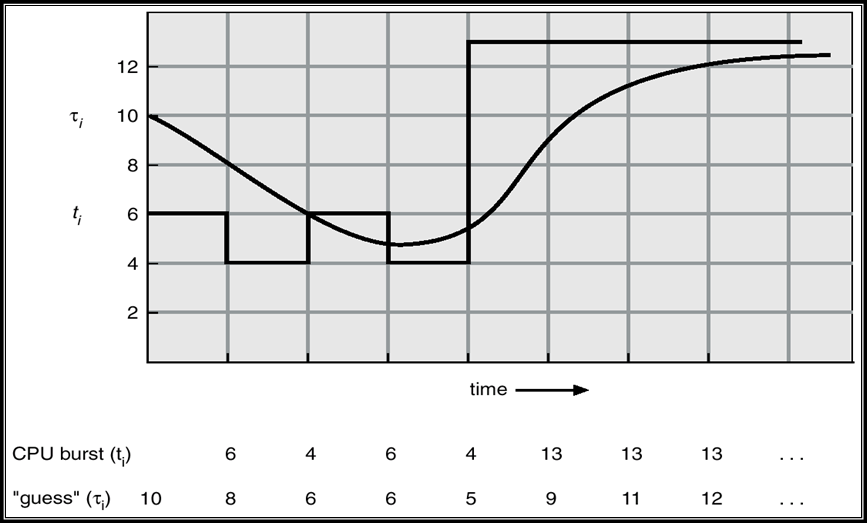

5.3.3.5 预测CPU Burst Time:指数平均法

只能估计长度

可以通过使用以前CPU突发的长度,使用指数平均来完成

- \(t_n\) = 第n次CPU burst的真实值

- \(\tau_n\) = 第n次CPU burst的预测值

- \(\alpha\),\(0 \le \alpha \le 1\)

- 定义:\(\tau_{n+1}=\alpha t_n+(1-\alpha)\tau_n\)

几种\(\alpha\)的取值

- \(\alpha=0\):\(\tau_{n+1} = \tau_{n}\),只考虑预测值

- \(\alpha=1\):\(\tau_{n+1} = t_{n}\),只考虑实际值

展开\(\tau_{n+1}\) \[ \begin{aligned} \tau_{n+1}= &\ \ \ \ \ \ \alpha t_n \\ &+ (1-\alpha)\ t_{n-1} \\ &+ \ ...\\ &+(1-\alpha)^i\ \alpha t_{n-i} \\ &+ \ ...\\ &+(1-\alpha)^{n+1} \tau_{0} \end{aligned} \]

5.3.3 优先级调度 Priority Scheduling

5.3.3.1 算法内容

- 该算法总是把处理机分配给就绪队列中具有最高优先权的进程

- SJF是以下一次CPU脉冲长度作为优先数的优先级调度

- 常用以下两种方法来确定进程的优先权:

- 静态优先权:静态优先权是在创建进程时确定的,在整个运行期间不再改变。依据有:进程类型、进程对资源的要求、用户要求的优先权。

- 动态优先权:动态优先权是基于某种原则,使进程的优先权随时间改变而改变。

- 假定:最小的整数 <=> 最高的优先级.

- 两种模式

- 非抢占式Non-preemptive priority

scheduling:将优先级较高的进程置于队列的前端

- 默认所有进程一起到来

- 抢占式Preemptive priority

scheduling:在较高优先级进程到达时中断并抢占正在运行的进程

- 默认所有进程的到达时间有前后区别

- 非抢占式Non-preemptive priority

scheduling:将优先级较高的进程置于队列的前端

- 问题:饥饿Starvation,低优先级的进程永远不会被执行

- 解决方法:老化Aging,随着进程运行时间的增长,其优先级会降低

5.3.3.2 示例

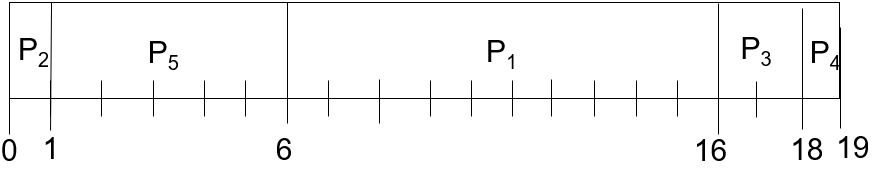

非抢占式:non-preemptive

| Process | Burst Time | Priority |

|---|---|---|

| P1 | 10 | 3 |

| P2 | 1 | 1 |

| P3 | 2 | 4 |

| P4 | 1 | 5 |

| P5 | 5 | 2 |

- 平均Turnaround time:(16+1+18+19+6) / 5 = 12

- 平均waiting time:(6+0+16+18+1) / 5 = 8.2

抢占式:preemptive

| Process | Arrival Time | Burst Time | Priority |

|---|---|---|---|

| P1 | 0 | 10 | 3 |

| P2 | 1 | 1 | 1 |

| P3 | 4 | 2 | 4 |

| P4 | 5 | 1 | 2 |

| P5 | 8 | 5 | 2 |

- 平均Turnaround time:(17+1+15+1+5) / 5 = 7.8

- 平均waiting time:(7+0+13+0+0) / 5 = 4

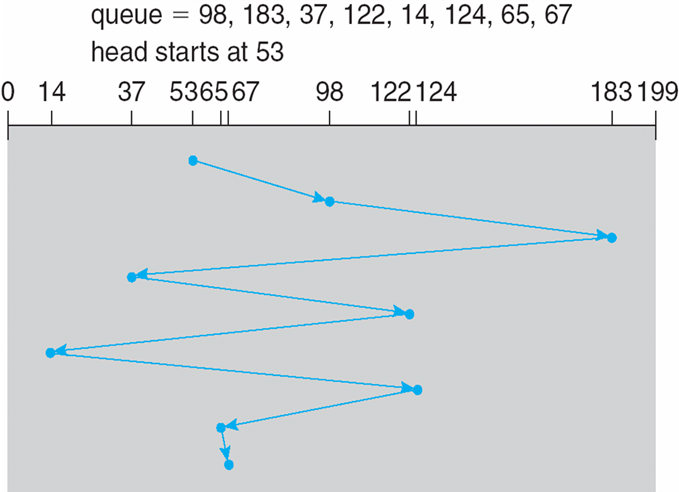

5.3.4 时间片轮转调度 RR

5.3.4.1 算法内容

- 基本思路:通过时间片轮转,提高进程并发性和响应时间特性,从而提高资源利用率。

- RR算法:Round Robin

- 将系统中所有的就绪进程按照FCFS原则,排成一个队列

- 每次调度时将CPU分派给队首进程,让其执行一个时间片

(timeslice)

- 时间片的长度从几个ms到几百ms

- 在一个时间片结束时,发生时钟中断

- 调度程序据此暂停当前进程的执行,将其送到就绪队列的末尾,并通过上下文切换执行当前的队首进程

- 进程可以未使用完一个时间片,就出让CPU(如阻塞)

- 每个进程都有一小单位的CPU时间(time quantum),通常为10-100毫秒。经过这段时间后,进程被抢占并添加到就绪队列的末尾

- 如果ready

queue中有n个进程,并且time

quantum为q,那么每个进程一次获得最多为q个时间单位的CPU时间的1/n,进程最大等待(n-1)q个时间单位

- 当q很大时,变为了FIFO

- 当q很小时,上下文切换的开销过高

- 时间片长度的影响因素:

- 就绪进程的数目:当响应时间一定时,数目越多,时间片越小

- 系统的处理能力:应当使用户输入通常在一个时间片内能处理完,否则使响应时间、平均周转时间、平均带权周转时间过长

- 优点:response更好

- 缺点:比SJF的average turnaround time长

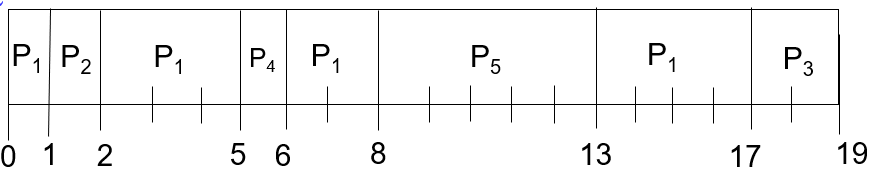

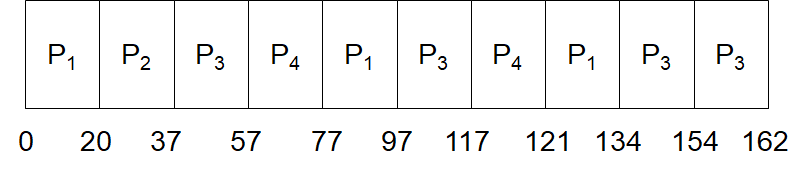

5.3.4.2 示例

| Process | Burst Time |

|---|---|

| P1 | 53 |

| P2 | 17 |

| P3 | 68 |

| P4 | 24 |

- 平均Turnaround time:(134+37+162+121) / 4 = 113.5

- 平均waiting time:(81+20+94+97) / 4 = 70.5

5.3.4.3 Time Quantum 时间片的选择

- 要求80%的CPU burst time应该小于q

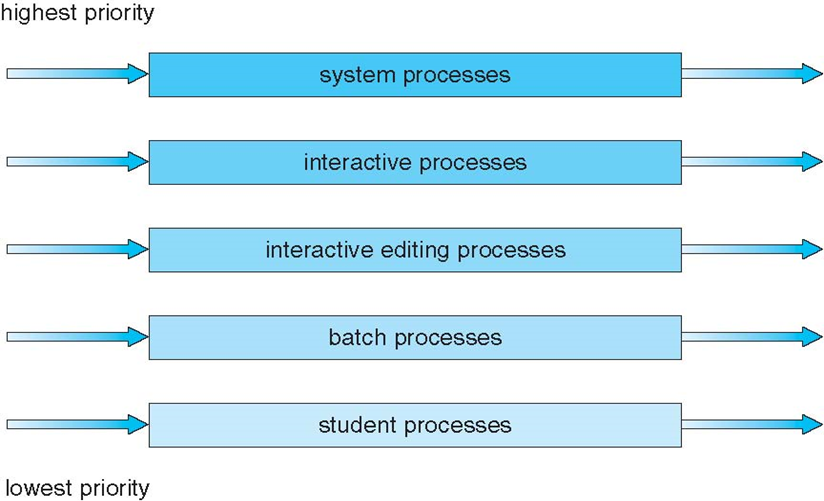

5.3.5 多级队列调度

本算法引入多个就绪队列,通过各队列的区别对待,达到一个综合的调度目标

- 根据进程的性质或类型的不同,将Ready队列再分为若干个子队列

- 每个作业固定归入一个队列

- 各队列的不同处理:不同队列可有不同的优先级、时间片长度、调度策略等

- 如:系统进程、用户交互进程、批处理进程等

- Ready Queue的分类

- foreground (interactive) 前台(交互式)— RR,时间片轮转调度

- background (batch) 后台 (批处理)— FCFS,先来先服务调度

- 多级队列算法调度须在队列间进行

- 固定优先级调度:即前台运行完后再运行后台

- 有可能产生饥饿

- 给定时间片调度:即每个队列得到一定的CPU时间,进程在给定时间内执行

- 不同队列的时间片长度不一样

- 如,80%的时间执行前台的RR调度,20%的时间执行后台的FCFS调度

- 固定优先级调度:即前台运行完后再运行后台

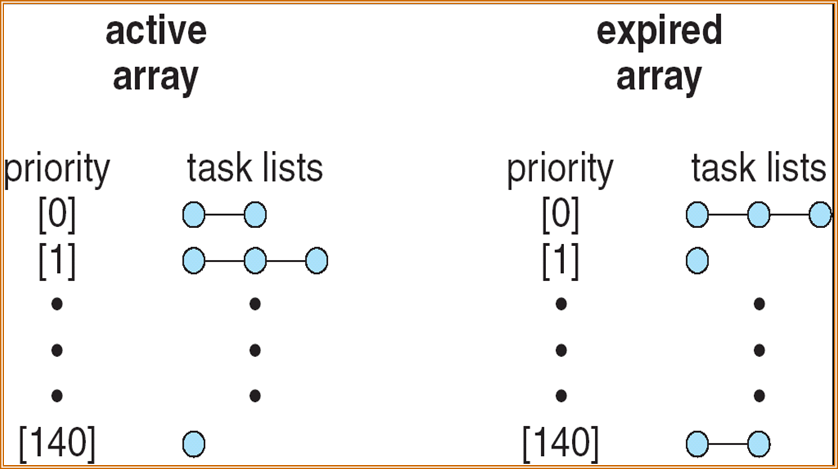

5.3.6 多级反馈队列

- 多级反馈队列算法:Multilevel Feedback Queue Scheduling

- 是时间片轮转算法和优先级算法的综合和发展

- 同一个进程可以在不同队列之间转移

- 优点:

- 为提高系统吞吐量和缩短平均周转时间而照顾短进程

- 为获得较好的I/O设备利用率和缩短响应时间而照顾I/O型进程

- 不必估计进程的执行时间,动态调节

- 方法:

- 设置多个就绪队列,分别赋予不同的优先级,如逐级降低,队列1的优先级最高。每个队列执行时间片的长度也不同,规定优先级越低则时间片越长,如逐级加倍

- 新进程进入内存后,先投入队列1的末尾,按FCFS算法调度;若按队列1一个时间片未能执行完,则降低投入到队列2的末尾,同样按FCFS算法调度;如此下去,降低到最后的队列,则按"时间片轮转"算法调度直到完成

- 仅当较高优先级的队列为空,才调度较低优先级的队列中的进程执行。如果进程执行时有新进程进入较高优先级的队列,则抢占执行新进程,并把被抢占的进程投入原队列的末尾

- 几点说明:

- I/O型进程:让其进入最高优先级队列,以及时响应I/O交互。通常执行一个小时间片,要求可处理完一次I/O请求的数据,然后转入到阻塞队列

- 计算型进程:每次执行完时间片,进入更低优先级级队列。最终采用最大时间片来执行,减少调度次数

- I/O次数不多,而主要是CPU处理的进程:在I/O完成后,优先放回I/O请求时离开的队列,以免每次都回到最高优先级队列后再逐次下降

- 为适应一个进程在不同时间段的运行特点,I/O完成时,提高优先级;时间片用完时,降低优先级;

5.4* 多处理器调度 Multiple-Processor Scheduling

- 当多个CPU可用时,CPU调度更加复杂

- 多处理器中的 同构处理器Homogeneous processors

- 负载分担

- 非对称多处理Asymmetric multiprocessing:只有一个处理器访问系统数据结构,减少了数据共享的需要

5.5* 线程调度 Thread Scheduling

- 本地调度:线程库如何决定将哪个线程放入可用的LWP

- 全局调度:内核如何决定下一个运行哪个内核线程

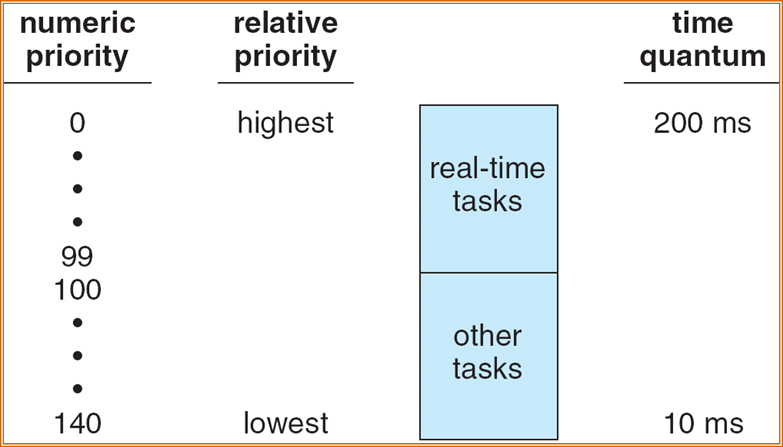

5.6 操作系统示例 Operating Systems Examples

- 两种算法:Time-sharing、Real-time

- 时间共享 Time-sharing

- 基于credit的优先级:下一步执行拥有最高credit的进程

- 触发计时器中断时扣除credit

- 当credit=0时,选择另一个进程

- 当所有进程的credit均为0时,将重新编辑

- 基于优先级和历史等因素

- 实时 Real-time

- 软实时

- Posix.1b compliant:两种

- FCFS和RR

- 优先级最高的进程总是首先运行

5.7 总结

- CPU Burst Time 、I/O Burst Time

- CPU-bound program(CPU型程序) 、I/O-bound program(I/O型程序)

- long-term scheduler(长程调度)、medium-term scheduler(中程调度)short-term scheduler(短程调度)

- time slicing(时间片)

- response time(响应时间)、turnaround time(周转时间)、waiting time(等待时间)、Average Turnaround time(平均周转时间)Average waiting time(平均等待时间)

- preemptive scheduling(抢占式调度)、Nonpreemptive scheduling(非抢占式调度)

- throughput(吞吐量):单位时间内完成的任务

- 从ready queue中选择一个进程,为它分配CPU

- 调度算法

- first-come, first served (FCFS)

- shortest job first (SJF)

- provably optimal, but difficult to know CPU burst

- general priority scheduling

- starvation, and aging

- round-robin (RR)

- for time-sharing, interactive system

- problem: how to select the time quantum?

- Multilevel queue

- different algorithms for different classes of processes

- Multilevel feedback queue

- allow process to move from one (ready) queue to another

Chapter 6:Process Synchronization 进程同步

6.1 Background

对共享数据的并发访问可能导致数据不一致:data inconsistency

维护数据一致性需要有机制来确保合作流程的有序执行

有界缓冲区问题的共享内存解决方案(第3章)允许缓冲区中最多有n-1个项。使用所有N个缓冲区的解决方案并不简单

假设我们通过添加一个变量counter来修改生产者–消费者代码

- counter初始化为0,并在每次向缓冲区添加新项时递增

- counter++和counter--必须被原子性的执行

typedef struct {

. . .

} item;

item buffer[BUFFER_SIZE];

int in = 0;

int out = 0;

int counter = 0;

// Producer process(thread):

item nextProduced;

while (1) {

while (counter == BUFFER_SIZE) ; /* do nothing */

buffer[in] = nextProduced;

in = (in + 1) % BUFFER_SIZE;

counter++;

}

// Consumer process (thread):

item nextConsumed;

while (1) {

while (counter == 0) ; /* do nothing */

nextConsumed = buffer[out];

out = (out + 1) % BUFFER_SIZE;

counter--;

}

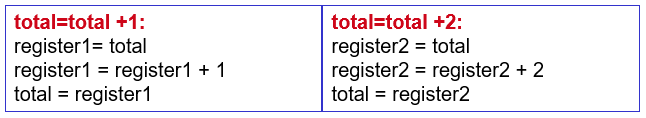

6.1.1 原子操作

原子操作 Atomic operation:是指完整地完成而不中断的操作

counter++和counter--均会被实现为三条指令:

register = counter;

register = register +/- 1;

counter = register;如果生产者和消费者都试图同时更新缓冲区,汇编语言语句可能会交错

交错取决于生产者和消费者流程的安排方式

6.1.2 非原子操作冲突示例

有两个进程P1、P2,它们分别执行下面的程序体,其中total是两个进程都能访问的共享变量,初值为0(可理解为共享存储段中的存储单元),count是每个进程的私有变量。假设这两个进程并发执行,并可自由交叉(interleave),则这两个进程都执行完后,变量total可能得到的最小取值是

3

int count;

for (count =1; count <= 50; count++)

total = total + 1;

}

P2: {

int count;

for (count =1; count <= 50; count++)

total = total + 2;

}

total = total + 1和total = total + 2经过编译后各为三条指令

P1和P2并发执行过程中,这些指令会交替运行。如果两个进程按如下顺序执行:

操作 对应指令 对应的值 P1第1次循环 register1 = total register1 = 0 P1第1次循环 register1 = register1 + 1 register1 = 1 P2循环49次 P1第1次循环 total =register1 total =1 P2第50次循环 register2 = total register2 = 1 P2第50次循环 register2 = register2 + 2 register2 = 3 P1循环48次 P1第50次循环 register1 = total register1 = 49 P1第50次循环 register1 = register1 + 1 register1 =50 P1第50次循环 total = register1 total = 50 P2第50次循环 total = register2 total = 3 两个进程运行结束后,变量total的值为3。

6.1.3 Race Condition

- Race Condition(竞争条件):多个进程同时访问和操作共享数据,共享数据的最终值取决于哪个进程最后完成,执行的结果取决于访问发生的特定顺序

- 为了防止出现争用情况,必须同步并发进程

6.1.4 进程同步的概念

进程之间竞争资源面临三个控制问题:

- 互斥(mutual exclusion):指多个进程不能同时使用同一个资源

- 死锁(deadlock):指多个进程互不相让,都得不到足够的资源

- 永远得不到资源

- 饥饿(starvation):指一个进程长时间得不到资源(其他进程可能轮流占用资源)

- 资源分配不公平

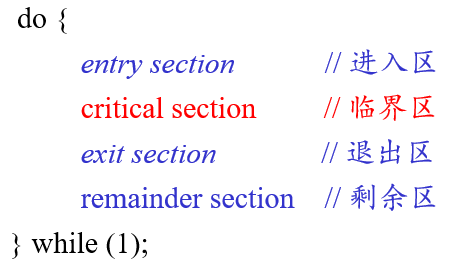

6.2 The Critical-Section Problem(重点)

6.2.1 问题的定义

- n个进程都在竞争使用某些共享数据

- 每个流程都有一个代码段,称为关键部分(临界区), 其中访问共享数据。

- 问题:确保当一个进程在其关键部分执行时,不允许其他进程在其重要部分执行

6.2.2 临界区&临界资源

- 临界资源:一次只允许一个进程使用(访问)的资源

- 如:硬件打印机、磁带机等,软件的消息缓冲队列、变量、数组、缓冲区等。

- 临界区:访问临界资源的那段代码

- 对临界区问题的解法必须满足:

- Mutual Exclusion(互斥)

- 如果进程Pi正在临界区中执行,则其他进程不能在临界区中执行

- Progress(空闲让进)

- 如果没有进程在临界区中执行,并且存在一些进程希望进入临界区,则不能无限期地推迟选择下一个将进入临界区的进程

- Bounded Waiting(让权等待)

- 在一个进程发出进入临界区的请求之后,在该请求被批准之前,其他进程被允许进入临界区的次数必须存在一个界限

- 不是必须的

- Mutual Exclusion(互斥)

6.2.3 一个进程的结构应该是

6.3 多进程临界区问题的解决方法:软件方法

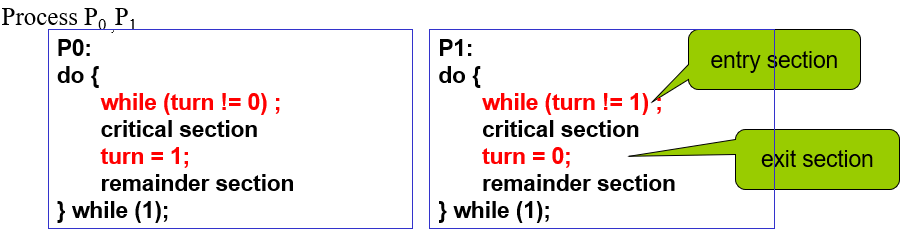

6.3.1 Peterson Solutions:两个进程

- Software Solution:通过软件方法解决进程互斥

- 针对两个进程之间的同步

- 假设Load和Store均是原子操作

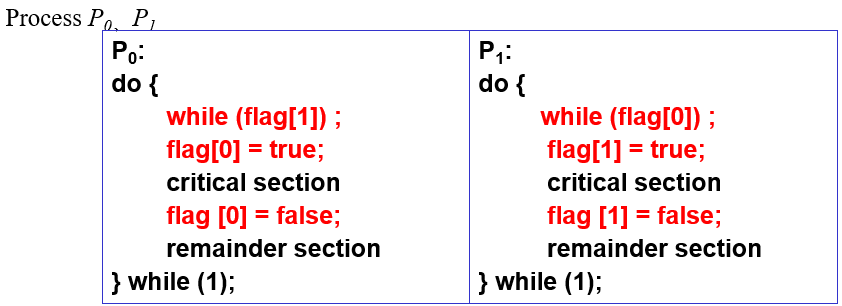

6.3.1.1 算法1

只有两个进程P0,P1

共享变量

- int turn = 0

- turn = i:表示轮到Pi进入临界区,i = 0/1

进程P0和P1的操作:

满足互斥,但是不满足空闲让进

缺点:

- 强制轮流进入临界区,没有考虑进程的实际需要。容易造成资源利用不充分

- 在Pi出让临界区之后,Pj使用临界区之前,Pi不可能再次使用临界区

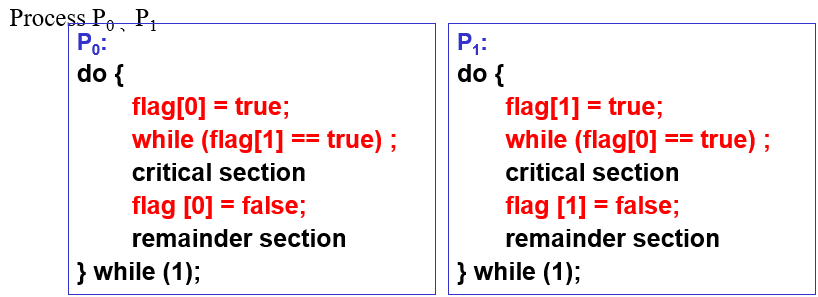

6.3.1.2 算法2-1

共享变量

- bool flag[2] = false

- flag[i] = true:表示Pi想要进入临界区,i = 0/1

进程P0和P1的操作:

满足互斥,但是不满足空闲让进

缺点:

- P0和P1可能都进入不了临界区

- 当P0执行了flag[0] = true后,然后P1执行了flag[1] = true,这样两个进程都无法进入临界区

6.3.1.3 算法2-2

共享变量

- bool flag[2] = false

- flag[i] = true:表示Pi想要进入临界区,i = 0/1

进程P0和P1的操作:

满足空闲让进,但是不满足互斥

缺点:

- P0和P1可能同时进入临界区

- 当flag [0] = flag [1] = false时, P0执行了while (flag[1])后,P1执行while (flag[0]) ,这样两个进程同时进入了临界区

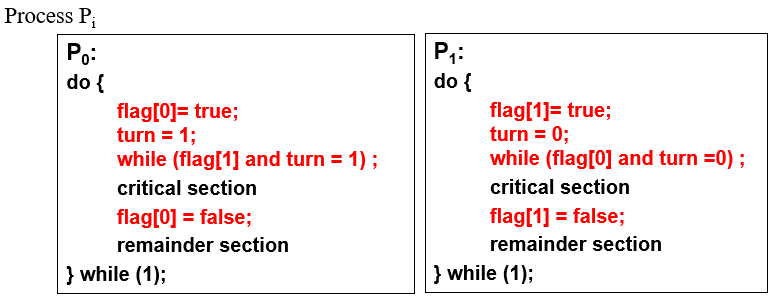

6.3.1.4 Peterson算法

共享变量

- int turn = 0

- bool flag[2] = false

- turn = i:表示轮到Pi进入临界区,i = 0/1

- flag[i] = true:表示Pi准备好进入临界区,i = 0/1

进程P0和P1的操作:

满足了三个要求,但是只能解决2个进程的临界区问题

6.3.2 Bakery Algorithm:n个进程

思想:

- 进入临界区之前,进程会获得一个number,拥有最小number的进程可以进入临界区

- 如果Pi和Pj的number相同,则先执行进程id小的进程

- 编号方案总是按枚举的递增顺序生成数字,如1,2,3,3,3,3,4,5...

定义:

- order:(a, b),a为number,b为进程id

- (a, b) < (c, d):当且仅当 a<c 或者 a=c, b<d

共享数据:

- bool choosing[n] = false;

- int number[n] = 0;

- choosing[i] = true:表示Pi正在获取它的number

- number[i]:是Pi的当前number。如果值为0,表示Pi未参加排队,不想获得该资源

进程Pi的操作:

do { |

6.4 多进程临界区问题的解决方法:硬件方法

- 许多系统为关键部分代码提供硬件支持

- 单处理器:可以禁用中断

- 当前运行的代码将在没有抢占的情况下执行

- 在多处理器系统上通常效率太低

- 使用此功能的操作系统不可广泛扩展

- 特殊的原子硬件指令:原子 => 不可中断

- 从内存中取一个变量并且设置为某个值:test and set

- 交换内存中两个变量的内容:swap

6.4.1 Test-and-Set:测试与设置

返回变量的原始值,并将其赋值为true

bool TestAndSet(bool &target) {

bool rv = target;

target = true;

return rv;

}将其变为一条原子指令之后,进程与临界区的交互变为:

bool lock = false; // 共享数据

// 进程P[i]

while(1) {

// 第一个进程准备进入临界区时, 该指令返回false, 并将lock赋值为true

// 其它进程再执行该指令时, 会由于返回值为true, 而停到这里

// 进程执行完成后, 将lock赋值为false, 其它进程可以访问临界区

while(TestAndSet(lock));

critical_section(); // 进入临界区执行的部分

lock = false; // 之后的第一个进程可以进入临界区

remainder_section();// 不需要进入临界区执行的部分

};

6.4.2 Swap:交换

交换两个变量的值

void Swap (boolean *a, boolean *b){

boolean temp = *a;

*a = *b;

*b = temp:

}将其变为一条原子指令之后,进程与临界区的交互变为:

bool lock = false; // 共享数据

// 进程P[i]

while(1) {

bool key = true;

// 第一个进程准备进入临界区时, key与lock交换, key变为false, lock变为true

// 其它进程再执行该指令时, key与lock交换后均为true, 会停到这里

// 进程执行完成后, 将lock赋值为false, 其它进程可以访问临界区

while(key == true) Swap(&lock, &key);

critical_section(); // 进入临界区执行的部分

lock = false; // 之后的第一个进程可以进入临界区

remainder_section();// 不需要进入临界区执行的部分

};

6.4.3 硬件方法的优缺点

优点

- 适用于任意数目的进程,在单处理器或多处理器上

- 简单,容易验证其正确性

- 可以支持进程内存在多个临界区,只需为每个临界区设立一个布尔变量

缺点

- 不能实现让权等待:

- 因为等待要耗费CPU时间

- 可能饥饿:

- 从等待进程中随机选择一个进入临界区,有的进程可能一直选不上

- 可能死锁:

- 单CPU情况下,P1执行特殊指令进入临界区,这时拥有更高优先级P2执行并中断P1

- 如果P2又要使用P1占用的资源,按照资源分配规则拒绝P2对资源的要求,P2陷入等待循环

- 然后P1也得不到CPU,因为P1比P2优先级低

- 不能实现让权等待:

解决饥饿

- waiting[i]:进程Pi正在等待进入临界区

bool waiting[n] = false, lock = false; // 共享数据

// 进程P[i]

while(1) {

// 第一个进程准备进入临界区时, 将lock变为true, 返回给key为false

// 之后的进程始终为true, 也就是不能进入临界区

waiting[i] = true;

bool key = true;

while (waiting[i] && key) key = TestAndSet(lock);

waiting[i] = false;

critical_section(); // 进入临界区执行的部分

// 选择下一个进入临界区的进程(下一个waiting[j] = true)

// 让waiting[j] = false, 则被选中的进程跳出while循环, 可以进入临界区

// lock的释放由进程P[j]执行

int j;

for(j = (i + 1) % n; j != i; j = (j + 1) % n){

if(waiting[j]) {

waiting[j] = false;

break;

}

}

// 没有进程等待进入临界区, 则直接释放lock

if (j == i) lock = false ;

remainder_section();// 不需要进入临界区执行的部分

}- 该算法满足所有关键部分的要求。

- 证明满足互斥要求:

- 我们注意到,只有当waiting[i]=false或key=false时,进程Pi才能进入临界区

- 只有在执行TestAndSet时,key的值才能变为false

- 执行TestAndSet的第一个进程将发现key==false;所有其他人都必须等待

- 只有当另一个进程离开临界区时,waiting[i]才能变为false;只有一个waiting[i]设置为false,保持互斥要求。

6.4.4 自旋锁 spinlock

- Windows、Linux内核用来达到多处理器互斥的机制“自旋锁”,它类同于TestAndSet指令机制。自旋锁是一个与共用数据结构有关的锁定机制。

- 自旋锁像它们所保护的数据结构一样,储存在共用内存中。为了速度和使用任何在处理器体系下提供的锁定机构,获取和释放自旋锁的代码是用汇编语言写的。例如在Intel处理器上,Windows使用了一个只在486处理器或更高处理器上运行的指令。

- 当线程试图获得自旋锁时,在处理器上所有其它工作将终止。因此拥有自旋锁的线程永远不会被抢占,但允许它继续执行以便使它尽快把锁释放。内核对于使用自旋锁十分小心,当它拥有自旋锁时,它执行的指令数将减至最少。

6.5 Semaphores 信号量

6.5.1 信号量

信号量分类:

- 整型信号量:integer semaphore

- 记录型信号量:record semaphore

- AND型信号量,信号量集

- 二值信号量:binary semaphore

信号量的任务:解决busy waiting,即之前进程中的while()语句

整型信号量:S

对S的两个标准操作:wait()、signal()

- 也成为P()、V()

- 这两个操作是原子操作

两种信号量

- 计数信号量 Counting semaphore:整数取值范围

- 二值信号量 Binary semaphore:只有0/1两个值

6.5.2 用信号量解决冲突

wait(S){ |

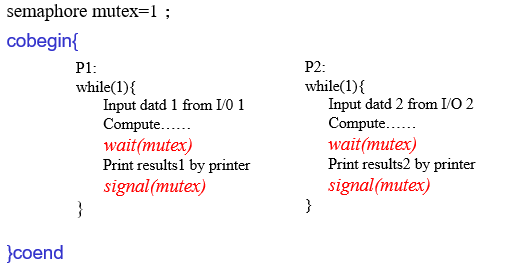

Semaphore mutex = 1; // 共享数据, 初始值表示最多可以有多少个进程同时进入临界区 |

- 必须保证没有两个进程可以在同一信号量上同时执行wait()和signal()

- 没有解决busy waiting的问题

- 但是将解决临界区问题的代码简化了

6.5.3 没有busy waiting的信号量实现

实现了一个waiting queue,等待队列中的每一个实体有2个元素:

typedef struct{

int value; // S: 记录型信号量

struct process *list; // 等待队列中的下一个进程

} semaphore;2个操作

- block():将调用操作的进程放置在适当的等待队列中

- 进程:running → waiting

- wakeup():删除等待队列中的一个进程,并将其置于就绪队列中

- 进程:waiting → ready

- block():将调用操作的进程放置在适当的等待队列中

具体实现

wait(semaphore * S){

S->value--;

if(S->value < 0){

// 将这个进程加入S->list

block();

}

}

signal(semaphore *S) {

S->value++;

if (S->value <= 0) {

// 将进程P从S->list中移除

wakeup(P);

}

}

6.5.4 wait、signal操作讨论

- 通常用信号量表示资源或临界区

- 信号量的物理含义

- S.value>0:表示有S.value个资源可用;

- S.value=0:表示无资源可用或表示不允许进程再进入临界区;

- S.value<0:则|S.value|表示在等待队列中进程的个数或表示等待进入临界区的进程个数

- wait(S)≡P(S)≡down(S):表示申请一个资源

- signal(S)≡V(S)≡up(S): 表示释放一个资源

- wait、signal操作必须成对出现,有一个wait操作就一定有一个signal操作

- 当为互斥操作时(控制A, B不会同时访问临界区),它们同处于同一进程

- 当为同步操作时(控制先让A执行, 再让B执行),则不在同一进程中出现

- 如果两个wait操作相邻,那么它们的顺序至关重要,而两个相邻的signal操作的顺序无关紧要

- 一个同步wait操作与一个互斥wait操作在一起时,同步wait操作在互斥wait操作前

- wait、signal操作的优缺点

- 优点:简单,而且表达能力强

- 缺点:不够安全;wait、signal操作使用不当会出现死锁;实现复杂

6.5.5 信号量用于通用同步操作

先执行Pi中的A操作,再执行Pj中的B操作

- 信号量flag初始化为0

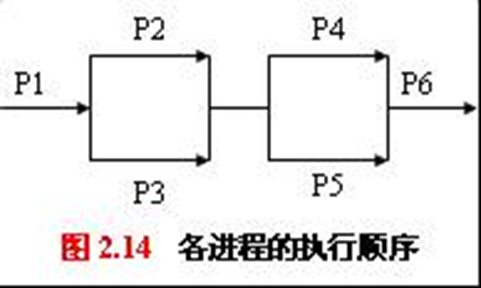

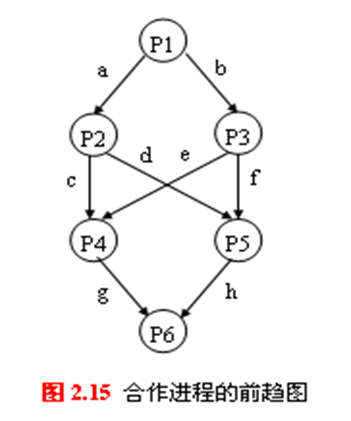

P[i] P[j] … … A wait(flag) signal(flag) B … … 一组合作进程,执行顺序如图。请用P(wait)、V(signal)操作实现进程间的同步操作

设置8个信号量a~h,初始值均为0

各进程的操作:

P1(){

...;

signal(a);

signal(b);

}

P2(){

wait(a);

...;

signal(c);

signal(d);

}

P3(){

wait(b);

...;

signal(e);

signal(f);

}

P4(){

wait(c);

wait(e);

...;

signal(g);

}

P5(){

wait(d);

wait(f);

...;

signal(h);

}

P6(){

wait(g);

wait(h);

...;

}

两个进程互斥:信号量初始为1

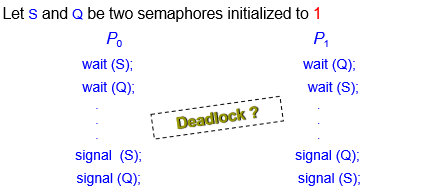

6.5.6 死锁和饥饿

死锁Deadlock:两个或多个进程无限期地等待一个事件,该事件只能由其中一个等待进程引起

饥饿Starvation:无限期阻塞。进程可能永远不会从其挂起的信号量队列中删除

优先级反转Priority Inversion:低优先级进程持有高优先级进程所需的锁时的调度问题

6.6 同步的经典问题

6.6.1 有限缓冲区问题:Bounded-Buffer Problem

有限缓冲区问题,也成为生产者-消费者问题,是最著名的同步问题

- 它描述一组生产者(P1……Pm)向一组消费者(C1……Cq)提供消息

- 它们共享一个有限缓冲池(bounded buffer pool)

- 生产者向其中投放消息,消费者从中取得消息

- 生产者-消费者问题是许多相互合作进程的一种抽象

N个buffer,每个可以存储1个item

- 信号量full:初始化为0,表示已经使用的buffer个数

- 信号量empty:初始化为N,表示还未使用的buffer个数

- 信号量mutex:初始化为1,作为互斥信号量

需要保证:

- 对同一个buffer的操作是互斥操作

生产者进程:

do {

// produce an item in nextp

...;

wait(empty); // 保证所有生产者插入的数量 < 当前buffer的剩余空间的大小

wait(mutex); // 保证互斥

// add nextp to buffer

...;

signal(mutex); // 保证互斥

signal(full); // 声明有一个数据插入到buffer中, 便于消费者的使用

} while (1);消费者进程:

do {

wait(full); // 保证所有消费者使用的数量 < 当前buffer中存在的数据数量

wait(mutex); // 保证互斥

// remove an item from buffer to nextc

...;

signal(mutex); // 保证互斥

signal(empty); // 声明有一个buffer已经为空, 便于生产者使用

// consume the item in nextc

...;

} while (1);

6.6.2 读写问题:Readers and Writers Problem

- 一个数据集(如文件)如果被几个并行进程所共享:

- Reader:有些进程只要求读数据集内容,它称读者

- Writer:一些进程则要求修改数据集内容,它称写者

- 几个Reader可以同时读些数据集,而不需要互斥

- 一个Writer不能和其它进程(不管是写者或读者)同时访问些数据集,它们之间必须互斥

6.6.2.1 第一Readers-Writers问题

读优先,要求:

- 允许多个Reader同时阅读

- 同一时间只有一个写入程序可以访问共享数据

- Writer能会挨饿

共享数据:

- Data set

- 信号量mutex:初始化为1,作为互斥信号量

- 信号量wrt:初始化为1,作为不同Writer之间的互斥信号量

- 整数readcount:初始化为0

Writer进程:

do {

wait (wrt); // 有wrt锁时, Writer不能写

// writing is performed

...;

signal (wrt); // 释放wrt锁

} while (1);Reader进程:

do{

wait(mutex); // 对readcount的互斥锁

readcount++;

if(readcount == 1) wait(wrt); // 第一个Reader到时

signal(mutex); // 释放对readcount的互斥锁

...;

// reading is performed

...;

wait(mutex); // 对readcount的互斥锁

readcount--;

if(readcount == 0) signal(wrt); // 最后一个Reader离开时

signal(mutex); // 释放对readcount的互斥锁

}while(1);

6.6.2.2 第二Readers-Writers问题

- 要求:

- 一旦Writer准备好了,Writer就会尽快进行写作

- Reader可能会饿死

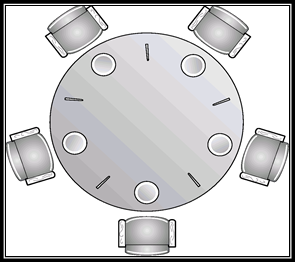

6.6.3 哲学家就餐问题:Dining-Philosopher Problem

多进程、多资源的同步问题

问题说明:

- n个哲学家坐在一个圆桌旁

- 每个哲学家与邻居共用一根筷子

- 每个哲学家都必须有一双筷子才能吃

- 邻居不能同时吃饭

- 哲学家在思考和吃饭之间交替

共享数据:

- 信号量:chopstick[5],初始值为1

哲学家i:

do {

// 等待两只筷子的使用

wait(chopstick[i]);

wait(chopstick[(i+1) % 5]);

// 使用两只筷子

...;

eat();

...;

// 声明已经使用完两只筷子

signal(chopstick[i]);

signal(chopstick[(i+1) % 5]);

// 不使用筷子的操作

...;

think();

...;

} while (1);该方法很容易产生死锁

- 原因:两个wait语句并不是原子操作

- 例如:每个哲学家均拿起了自己左边的一根筷子

避免死锁的方法:

- 同时只允许n-1个哲学家申请资源 ==> 至少有一个哲学家拿到了2个筷子

- 奇数编号的哲学家先拿左边再拿右边,偶数编号的哲学家先拿右边再拿左边

- 把哲学家分为三种状态:思考、饥饿、吃饭,并且一次拿到两只筷子,否则不拿

- hungry状态唯有保证自己能够拿到2只筷子,才能进入eat状态

- 本质上是保证了两句wait的原子性

- 每个哲学家拿起第1根筷子一定时间后,若拿不到第2根筷子,再放下第1根筷子

- 但是可能大家一起拿一起放

6.7* Monitors(管程)

管程是一种高级同步机制

- 管程是管理进程间同步的机制,它保证进程互斥地访问共享变量,并方便地阻塞和唤醒进程

- 管程可以函数库的形式实现

- 相比之下,管程比信号量好控制

6.7.1 信号量同步的缺点

- 同步操作分散:信号量机制中,同步操作分散在各个进程中,使用不当就可能导致各进程死锁(如wait、signal操作的次序错误、重复或遗漏)

- 可读性差:要了解对于一组共享变量及信号量的操作是否正确,必须通读整个系统或者并发程序

- 不利于修改和维护:各模块的独立性差,任一组变量或一段代码的修改都可能影响全局

- 正确性难以保证:操作系统或并发程序通常很大,很难保证这样一个复杂的系统没有逻辑错误

6.7.2 管程的引入

1973年,Hoare和Hanson所提出;其基本思想是把信号量及其操作原语封装在一个对象内部。即:将共享变量以及对共享变量能够进行的所有操作集中在一个模块中。

- 管程的定义:管程是关于共享资源的数据结构及一组针对该资源的操作过程所构成的软件模块

- 管程可增强模块的独立性:系统按资源管理的观点分解成若干模块,用数据表示抽象系统资源,同时分析了共享资源和专用资源在管理上的差别,按不同的管理方式定义模块的类型和结构,使同步操作相对集中,从而增加了模块的相对独立性

- 引入管程可提高代码的可读性,便于修改和维护,正确性易于保证:采用集中式同步机制。一个操作系统或并发程序由若干个这样的模块所构成,一个模块通常较短,模块之间关系清晰

6.7.3 管程的主要特性

- 模块化:一个管程是一个基本程序单位,可以单独编译

- 抽象数据类型:管程是一种特殊的数据类型,其中不仅有数据,而且有对数据进行操作的代码

- 信息封装:管程是半透明的,管程中的外部过程(函数)实现了某些功能,至于这些功能是怎样实现的,在其外部则是不可见的

6.7.4 管程的实现要素

- 管程中的共享变量在管程外部是不可见的,外部只能通过调用管程中所说明的外部过程(函数)来间接地访问管程中的共享变量

- 为了保证管程共享变量的数据完整性,规定管程互斥进入

- 管程通常是用来管理资源的,因而在管程中应当设有进程等待队列以及相应的等待及唤醒操作

6.7.5 管程的的组成

- 名称:为每个共享资源设立一个管程

- 数据结构说明:一组局部于管程的控制变量

- 操作原语:对控制变量和临界资源进行操作的一组原语过程(程序代码),是访问该管程的唯一途径。这些原语本身是互斥的,任一时刻只允许一个进程去调用,其余需要访问的进程就等待

- 初始化代码:对控制变量进行初始化的代码

monitor monitor-name{ |

6.7.6 管程中的多个进程进入

- 当一个进入管程的进程执行等待操作时,它应当释放管程的互斥权;当一个进入管程的进程执行唤醒操作时(如P唤醒Q),管程中便存在两个同时处于活动状态的进程,如何处理?。

- 若进程P唤醒进程Q,则随后可有两种执行方式(进程P、Q都是管程中的进程)

- P等待,直到Q离开管程或下一次等待。Hoare采用。

- Q等待,直到P离开管程或下一次等待。1980年,Lampson和Redell采用

- 入口等待队列(entry queue):因为管程是互斥进入的,所以当一个进程试图进入一个巳被占用的管程时它应当在管程的入口处等待,因而在管程的入口处应当有一个进程等待队列,称作入口等待队列

- 紧急等待队列:如果进程P唤醒进程Q,则P等待Q继续,如果进程Q在执行又唤醒进程R,则Q等待R继续,...,如此,在管程内部,由于执行唤醒操作,可能会出现多个等待进程(已被唤醒,但由于管程的互斥进入而等待),因而还需要有一个进程等待队列,这个等待队列被称为紧急等待队列。它的优先级应当高于入口等待队列的优先级

6.7.7 条件变量(condition)

- 由于管程通常是用于管理资源的,因而在管程内部,应当存在某种等待机制。当进入管程的进程因资源被占用等原因不能继续运行时使其等待。为此在管程内部可以说明和使用一种特殊类型的变量---条件变量

- 每个条件变量表示一种等待原因,并不取具体数值---相当于每个原因对应一个队列

6.7.8 同步操作原语

- 同步操作原语wait和signal:针对条件变量x,x.wait()将自己阻塞在x队列中,x.signal()将x队列中的一个进程唤醒

- x.wait():如果紧急等待队列非空,则唤醒第一个等待者;否则释放管程的互斥权,执行此操作的进程排入x队列尾部

- 紧急等待队列与x队列的关系:紧急等待队列是由于管程的互斥进入而等待的队列,而x队列是因资源被占用而等待的队列

- x.signal():如果x队列为空,则相当于空操作,执行此操作的进程继续;否则唤醒第一个等待者,执行x.signal()操作的进程排入紧急等待队列的尾部

6.7.9 用管程解决哲学家问题

monitor dp { |

6.8 总结

Chapter 7:Deadlocks死锁

7.1 System Model

- 死锁:

- 一组被阻塞的进程,每个进程持有一个资源,并等待获取该组中另一个进程持有的资源

- 指多个进程因竞争共享资源而造成的一种僵局,若无外力作用,这些进程都将永远不能再向前推进

- 系统模型

- 资源类型\(R_1,R_2,...R_m\)

- CPU时钟、内存空间、I/O设备

- 每个资源类型\(R_i\)可以有\(W_i\)个实例

- 每种资源类型可以有多个实例

- 实例对应着实际能够分配的资源类型

- 进程对资源的使用有以下三种类型

- Request 申请

- Use 使用

- Release 释放

- 资源类型\(R_1,R_2,...R_m\)

7.2 死锁的特征

7.2.1 产生死锁的4个必要条件

- Mutual exclusion互斥:

- 同一时间只有一个进程能够使用一个资源实例

- Hold and wait占有并等待、请求和保持:

- 进程已经保持了至少一个资源,但又提出了新的资源要求,而该资源又已被其它进程占有,此时请求进程阻塞,但又对已经获得的其它资源保持不放

- No preemption不可抢占、不剥夺:

- 资源只能由持有该资源的进程在该进程完成任务后自愿释放

- Circular wait循环等待:

- 存在一组{P0,P1,…,Pn}等待进程,使得P0正在等待P1所持有的资源,P1正在等待P2持有的资源,…,Pn–1正在等待Pn持有的资源,Pn正在等待P0持有的

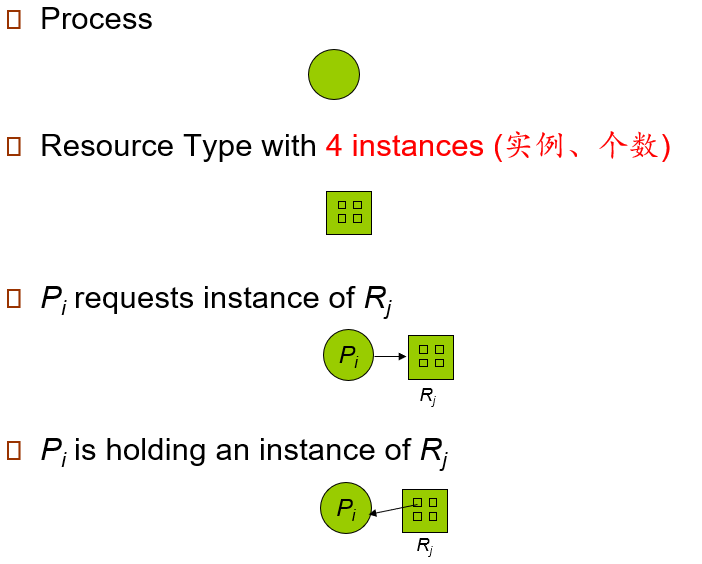

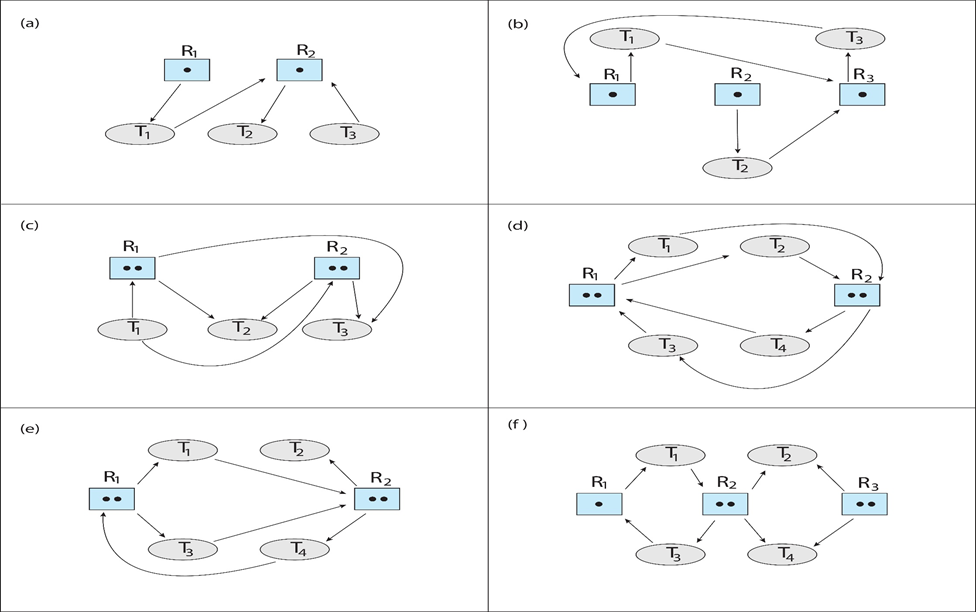

7.2.2 资源分配图 Resource-Allocation Graph

节点\(V\):

- 进程节点:P = {P1, P2, …, Pn}

- 资源节点:R = {R1, R2, …, Rm}

边\(E\):

- 请求边:Pi → Rj

- 分配边:Rj → Pi

节点&边的图例

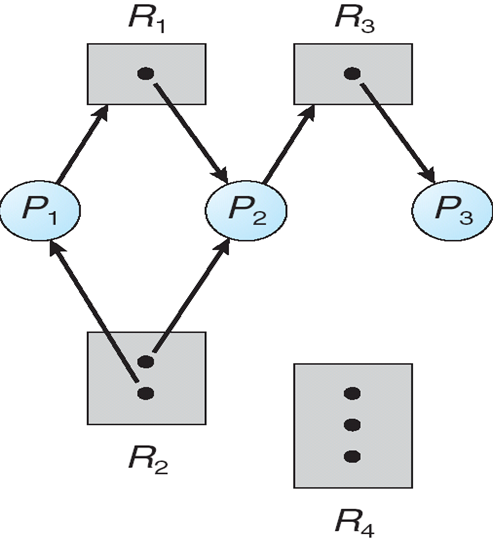

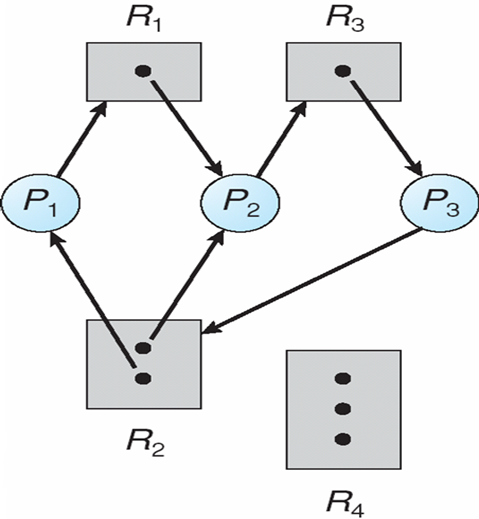

例:

- P1获取了R2资源,请求R1的资源

- P2获取了R1、R2资源,请求R3资源

- P3获取了R3资源

判断条件

- 如果图中没有环 ==> 没有死锁

- 如果图中有环

- 如果每个资源只有一个实例 ==> 死锁

- 如果每个资源拥有多个实例 ==> 有可能死锁,也可能不死锁

死锁定理:

- \(S\)为死锁状态的充分条件是:\(S\)状态的资源分配图是不可完全简化的

- 资源分配图(有向图)的简化:离散数学算法

7.3 处理死锁的方法

- 保证系统不进入死锁状态

- Prevention死锁预防

- Avoidance死锁避免

- 允许系统进入死锁状态,然后恢复

- Detection死锁检测

- Recovery死锁解除

- 忽略死锁状态,操作系统假装不发生死锁,人为解决死锁状态

7.4 死锁预防 Deadlock Prevention

- 不保证相互排斥(Mutual Exclusion)

- 不需要可共享资源;必须保留不可分割的资源

- 虚拟化

- 不保证保持等待(Hold and Wait)

- 必须确保无论进程何时请求资源,它都不会保留任何其他资源

- 要求进程在开始执行之前请求并分配其所有资源,或者仅当进程没有资源时才允许进程请求资源

- 资源静态预分配方式

- 资源利用率低;可能导致饥饿

- 允许抢占(No Preemption)

- 如果持有某些资源的进程请求另一个无法立即分配给它的资源,那么当前持有的所有资源都将被释放

- 抢占的资源将添加到进程正在等待的资源列表中

- 只有当进程能够重新获得它的旧资源以及它所请求的新资源时,它才会重新启动

- 保证不出现循环等待(Circular Wait)

- 给所有资源类型的编号,并要求每个进程以递增的顺序请求资源

- F(磁带驱动器)=1,F(磁盘驱动器)=5,F(打印机)=12

- 资源的有序申请破坏了循环等待条件

7.5 死锁避免 Deadlock Avoidance

- 要求每个进程声明其可能需要的每种类型的最大资源数量

- 死锁避免算法动态检查资源分配状态,以确保永远不会出现循环等待条件

- 资源分配状态由可用和已分配资源的数量以及进程的最大需求来定义

7.5.1 安全状态 Safe State

当进程请求可用资源时,系统必须决定立即分配是否使系统处于安全状态

安全状态是指系统的一种状态,在此状态开始系统能按某种顺序(如P1、P2……Pn)来为各个进程分配其所需资源,直至最大需求,使每个进程都可顺序地一个个地完成。

- 这个序列(P1、P2…….Pn)称为安全序列

- 若系统此状态不存在一个安全序列,则称系统处于不安全状态

- 如果存在所有进程的安全序列,则系统处于安全状态

序列(P1、P2……Pn)是安全的, 满足:对于每个Pi,Pi仍然可以请求的资源,可以由当前可用资源+所有Pj所持有的资源来满足,其中j<i。

- 如果Pi资源需求不立即可用,则Pi可以等到所有Pj完成

- 当Pj完成时,Pi可以获得所需的资源、执行、返回分配的资源并终止

- 当Pi终止时,Pi+1可以获得其所需的资源,依此类推

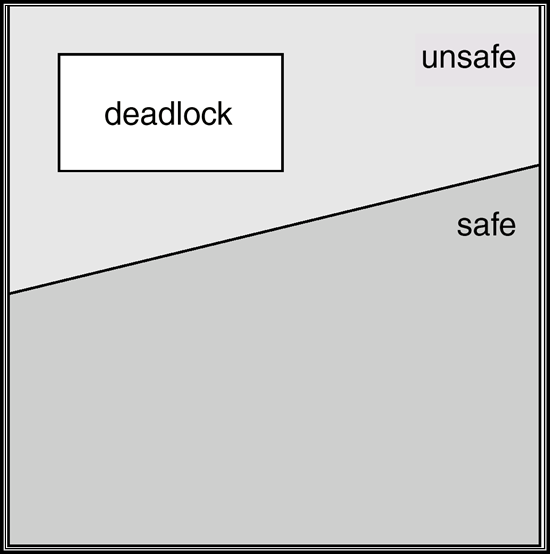

定理

- 系统处于安全状态 ==> 没有死锁

- 系统处于不安全状态 ==> 可能死锁

- 死锁避免:保证系统不会进入不安全状态

避免算法

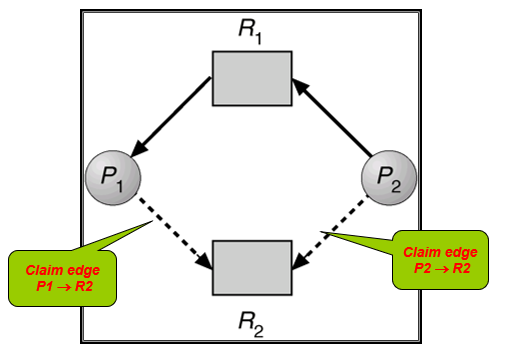

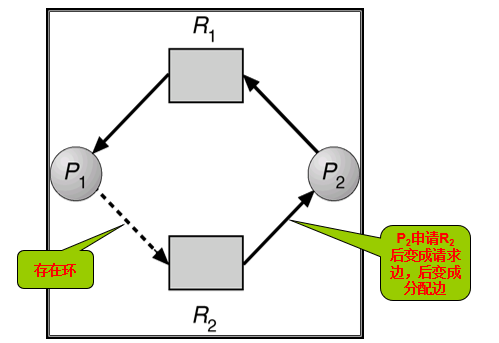

- 每个资源只有一个实例:resource-allocation graph

- 每个资源有多个实例:banker’s algorithm

7.5.3 Resource-Allocation Graph Algorithm 资源分配图算法

- 需求边Pi→Rj:Pi可能会请求资源Rj,用虚线表示

- 需求边转化为请求边:当且仅当该进程请求了该资源

- 请求边转化为分配边:当且仅当资源被分配给了这个进程

- 分配边转化为请求边:当且仅当资源被进程释放

- 资源必须在系统中声明优先级

- 算法:假设进程Pi申请资源Rj。只有在需求边Pi→Rj变成分配边 Rj→Pi 而不会导致资源分配图形成环时,才允许申请。

- 用算法循环检测,如果没有环存在,那么资源分配会使系统处于安全状态。如果存在环,资源分配会使系统不安全。进程Pi必须等待。

7.5.3 Banker’s Algorithm 银行家算法

- 每个过程必须事先声明最大使用量

- 当进程请求资源时,它可能需要等待

- 当一个进程获得其所有资源时,它必须在有限的时间内返回这些资源

- 参数定义

- n:进程数目

- m:资源的种类

- Available:长度为m的向量。如果Availabe[j]=k,表示Rj有k个实例可以使用

- Max:n×m的矩阵。如果Max[i] [j]=k,那么Pi会申请至多k个Rj资源

- Allocation:n×m的矩阵。如果Allocation[i] [j]=k,那么Pi已经申请了k个Rj资源

- Need:n×m的矩阵。如果Need[i]

[j]=k,那么Pi还需要k个Rj资源来完成任务

- Need[i] [j] = Max[i] [j] - Allocation[i] [j]

7.5.3.1 Safety Algorithm 安全算法

- 令Work为一个长度为m的向量,Finish为一个长度为n的向量,初始化为:

- Work = Availabe

- Finish[i] = { false }

- 找到一个序号i,满足

- Finish[i] = false

- Need[i] \(\le\) Work

- 如果不存在,进入步骤4

- Work = Work + Allocation[i]

- Finish[i] = true

- 返回步骤2

- 如果Finish = { true },则系统已经在安全状态

7.5.3.2 Resource-Request Algorithm 资源-请求算法

Request[i]:进程Pi的请求向量,如果Request[i] [j]=k,那么Pi想要申请k个Rj资源

如果Request[i] \(\le\) Need[i],则进入步骤2。否则,引发错误条件,因为进程已超过其最大声明

如果Request[i] \(\le\) Availabe,则进入步骤3。否则,Pi必须等待,因为资源不能满足需求

通过如下修改状态,尝试将请求的资源分配给Pi

Available = Available - Request[i];

Allocation[i] = Allocation[i] + Request[i];

Need[i] = Need[i] - Request[i];- 调用Safety Algorithm

- 如果安全,则可以分配给Pi

- 如果不安全,则Pi必须等待,并恢复旧的资源分配状态

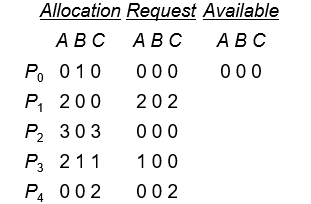

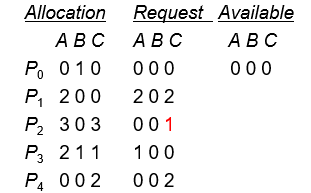

7.5.3.3 例

系统的状态(是否安全)?

P1的请求(1,0,2)是否通过?

P4的请求(3,3,0)是否通过?

P0的请求(0,2,0)是否通过?

7.6 死锁检测 Deadlock Detection

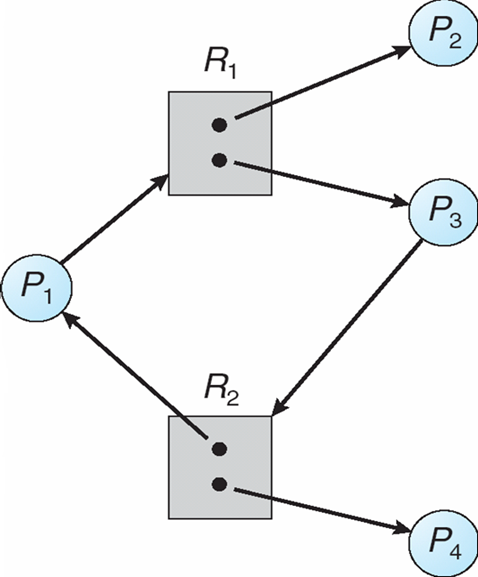

7.6.1 每个资源只有一个实例

- 维护一个等待图wait-for-graph:资源分配图的变形

- 节点:进程

- 边:Pi→Pj表示Pi正在等待Pj释放资源

- 定期调用检测图中是否存在环的算法

- 检测图中是否存在环的算法为O(n2),其中n是图中顶点的数量

7.6.2 每个资源有多个实例

- 数据结构:

- Available:长度为m的向量。如果Availabe[j]=k,表示Rj有k个实例可以使用

- Allocation:n×m的矩阵。如果Allocation[i] [j]=k,那么Pi已经申请了k个Rj资源

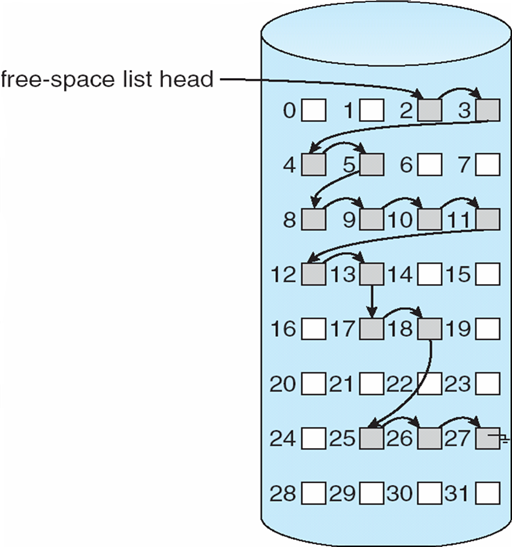

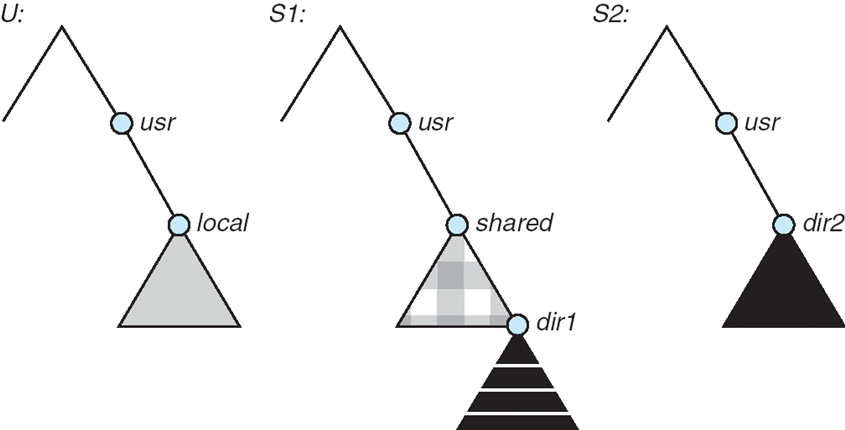

- Request:n×m的矩阵。如果Request[i] [j]=k,那么Pi正在申请k个Rj资源

- 检测算法:O(m×n2)

- 令Work为一个长度为m的向量,Finish为一个长度为n的向量,初始化为:

- Work = Availabe

- Finish[i] = { Allocation[k] [i]==0 ? true : false }

- 找到一个序号i,满足

- Finish[i] = false

- Request[i] \(\le\) Work

- 如果不存在,进入步骤4

- Work = Work + Allocation[i]

- Finish[i] = true

- 返回步骤2

- 如果存在Finish[i] == false,则系统处于死锁状态,且是Pi被死锁

- 令Work为一个长度为m的向量,Finish为一个长度为n的向量,初始化为:

7.6.3 示例

一共5个进程:P0~ P4,3中资源:A(7个示例)、B(2个示例)、C(6个示例)

T0时的snapshot:

- 执行序列:P0, P2, P3, P1, P4

T1时的snapshot:

- 将P0执行结束后,无法执行P1~ P4的任意一个进程,系统进入死锁状态

- 处于死锁状态的进程为P1~ P4

7.6.4 死锁检测算法的使用

- 死锁检测算法的使用频率,取决于死锁发生的频率、希望有多少进程需要被回滚

- 死锁发生的频率越高,死锁检测算法的使用频率越高

- 希望回滚的进程越少,死锁检测算法的使用频率越高

- 如果随机调用检测算法,那么资源图中可能会有很多循环,因此我们将无法判断是哪个死锁进程“导致”了死锁

7.7 从死锁中恢复

- 检测到死锁后采取措施:

- 通知系统管理员

- 系统自己恢复

- 打破死锁两种方法:

- 进程终止

- 抢占资源

7.7.1 进程终止 Process Termination

- 中止所有死锁进程

- 一次中止一个进程,直到消除死锁循环

- 许多因素可能决定选择哪种进程,包括:

- 进程的优先级

- 这个进程计算了多长时间,还有多长时间才能完成

- 进程使用的资源

- 资源进程需要完成

- 需要终止多少进程

- 该进程是交互式的还是批处理的

7.7.2 抢占资源 Resource Preemption

- 选择受害者:将成本降至最低最小化代价

- 回滚rollback: 返回到某个安全状态,从该状态重新启动进程。

- 饥饿starvation:同样的过程可能总是被选为受害者,包括成本因素中的回滚次数。

Chapter 8:Main Memory

8.1 Background

- 程序必须(从磁盘)放入内存,并放置在进程中才能运行

- CPU只能直接访问主存储器和寄存器

- 寄存器访问的时间:1个CPU clock

- 主存储器访问的时间:需要很多周期

- cache位于主内存和CPU寄存器之间

- 确保正确操作所需的内存保护

8.1.1 存储架构

8.1.2 主存

基于冯·诺依曼体系结构,数据和程序指令存在于共享内存空间中

- 程序重复执行以下内容:fetch-decode-execute

- 执行部分通常需要:数据获取和存储操作

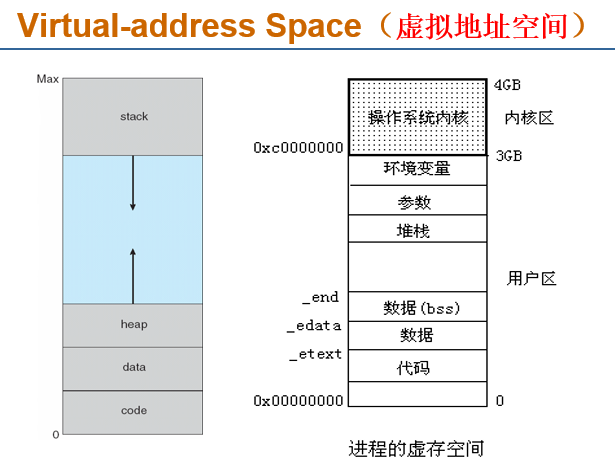

8.1.3 逻辑地址 vs 物理地址

- Logical

address(逻辑地址,相对地址,虚地址):generated by the CPU; also

referred to as virtual address

- 用户的程序经过汇编或编译后形成目标代码,目标代码通常采用相对地址的形式。

- 其首地址为0,其余指令中的地址都相对于首地址来编址。

- 不能用逻辑地址在内存中读取信息。

- Physical address(物理地址,绝对地址,实地址)

:address seen by the memory unit

- 内存中存储单元的地址。物理地址可直接寻址

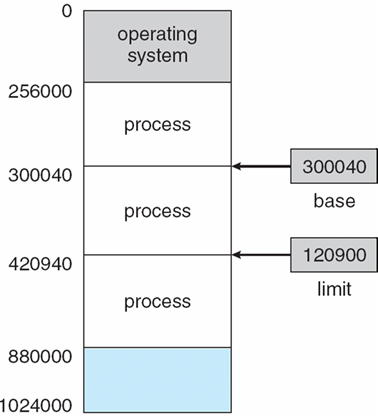

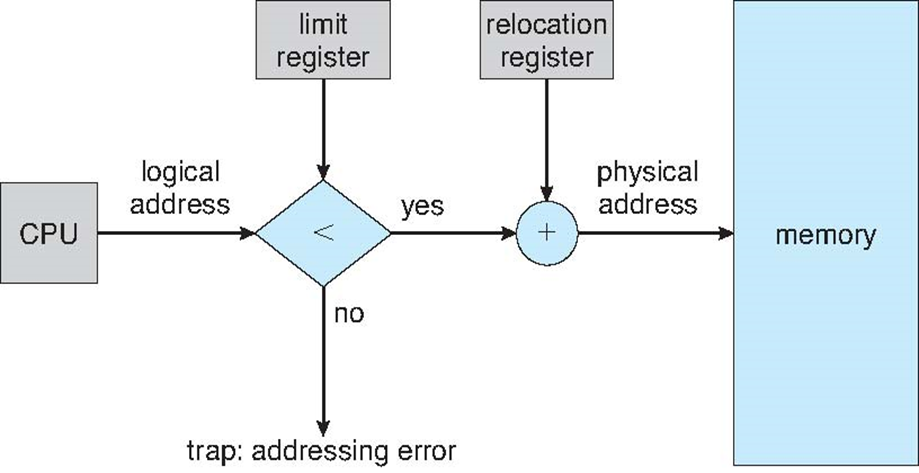

8.1.4 基址寄存器、限长寄存器

基址寄存器base register、限长寄存器limit register:定义了逻辑内存空间

8.1.5 将指令和数据与内存绑定

Address binding(地址绑定、地址映射、重定位):指令和数据到内存地址的转换可以在三个不同的阶段进行

- 编译时间:

- 如果内存位置先验已知,则可以生成绝对代码

- 如果开始位置更改,则必须重新编译代码

- 加载时间:

- 如果编译时内存位置未知,则必须生成可重定位代码 relocatable code

- 执行时间:

- 如果进程在执行过程中可以从一个内存段移动到另一个内存,则绑定延迟到运行时

- 需要地址映射的硬件支持(如:Base and Limit Registers)

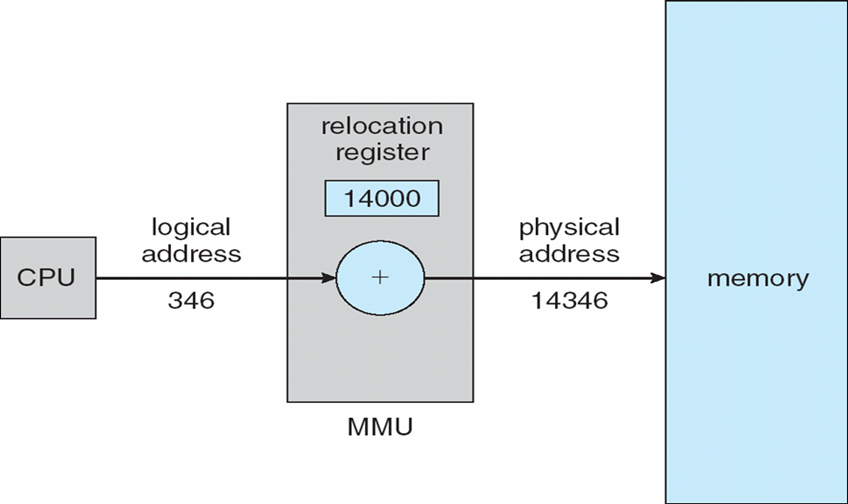

8.1.6 Memory-Management Unit (MMU)

- 将虚拟地址映射到物理地址的硬件设备

- 在MMU方案中,重定位寄存器(relocation register)中的值被添加到用户进程在发送到内存时生成的每个地址

- 用户程序处理逻辑地址;它永远看不到真实的物理地址

8.1.7 Dynamic Loading 动态载入

- 使用动态加载,进程启动时不会加载外部库

- 库以可重定位的形式存储在磁盘上

- 仅在需要时将库加载到内存中

- 更好的内存空间利用率;从未加载未使用的例程

- 当需要大量代码来处理不经常发生的情况时很有用

- 无需通过程序设计实现操作系统的特殊支持

8.1.8 Dynamic Linking 动态链接

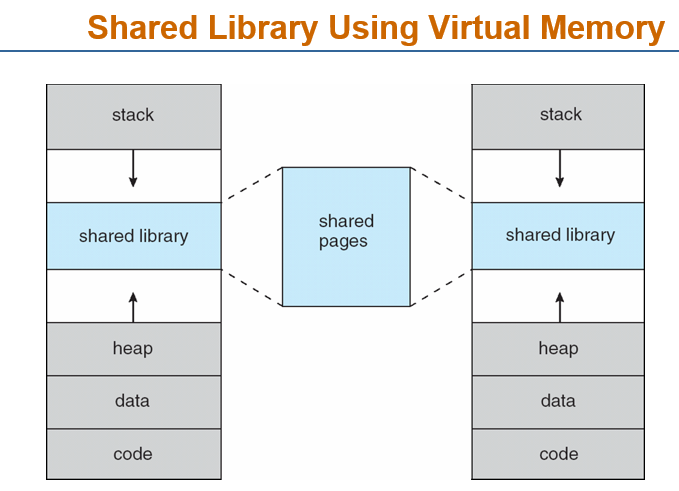

- 使用动态链接,可以将外部库预加载到(共享)内存中

- 当进程调用库函数时,确定相应的物理地址

- 一小段代码 (stub) 用于定位适当的内存驻留库例程

- Stub用例程的地址替换自身,并执行例程

- 操作系统需要检查例程是否在进程的内存地址中

- 动态链接对库的调用特别有用

- 这种模式也称为共享库

- Dynamically Linked Library 动态链接库

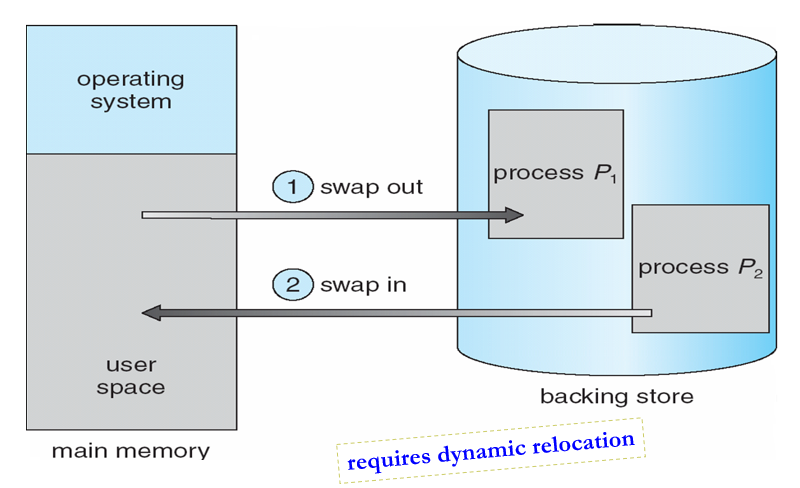

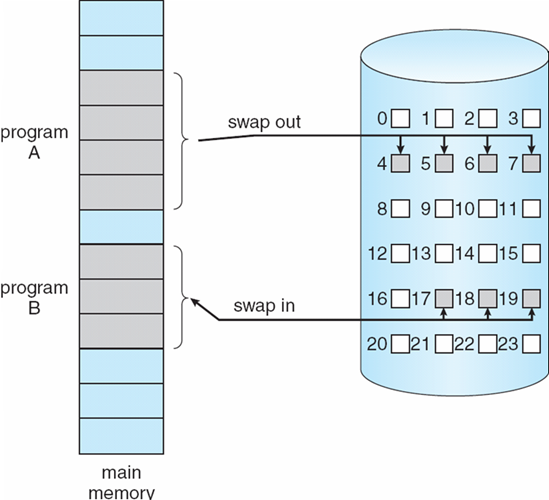

8.2 Swapping 交换技术

8.2.1 交换技术

- 进程可以临时从内存中交换到后备存储,然后再带回内存中继续执行

- Backing

store备份存储:足够大的快速磁盘,可容纳所有用户的所有内存映像副本;必须提供对这些内存映像的直接访问

- Linux、UNIX-交换区

- Windows-交换文件(pagefile.sys)

- Roll out,Roll in(调出,调进)

- 用于基于优先级的调度算法的交换变量

- 低优先级进程被交换出去,以便可以加载和执行高优先级进程

- 交换时间的主要部分是传输时间;总传输时间与交换的内存量成正比

- 在许多系统(如UNIX、Linux和Windows)上都可以找到经过修改的交换版本

- 系统维护一个准备好运行的进程队列,这些进程在磁盘上具有内存映像

8.2.2 不同操作系统的Swapping

- UNIX, Linux, and Windows:

- 正常情况下,禁止交换

- 当空闲内存低于某一个阈值时,启用交换换出

- 当空闲内存增加一定数量时,停止换出

- 移动系统不支持交换,Flash memory based:

- 小空间

- 闪存写次数限制

- 在移动平台上闪存和CPU之间的吞吐量很低

- iOS要求应用程序自愿放弃分配的内存

- 只读数据从系统中直接删除,已修改数据不会被删除

- OS可以终止任何未能释放足够空间的应用

- Android如果空闲内存不足,会终止应用程序,但首先会将应用程序状态写入闪存,以便快速重启

8.3 Contiguous Allocation 连续分配

8.3.1 连续分配

- 主内存通常分为两个分区(分区):

- Resident operating system常驻操作系统:通常保存在具有中断向量的低内存中

- User processes用户进程:保存在高内存中

- Relocation registers

重新定位寄存器:用于保护用户进程彼此不受影响,以及防止操作系统代码和数据发生变化

- Base register基址寄存器:包含最小物理地址的值

- Limit register限制寄存器:包含逻辑地址范围–每个逻辑地址必须小于限制寄存器

- MMU动态映射逻辑地址

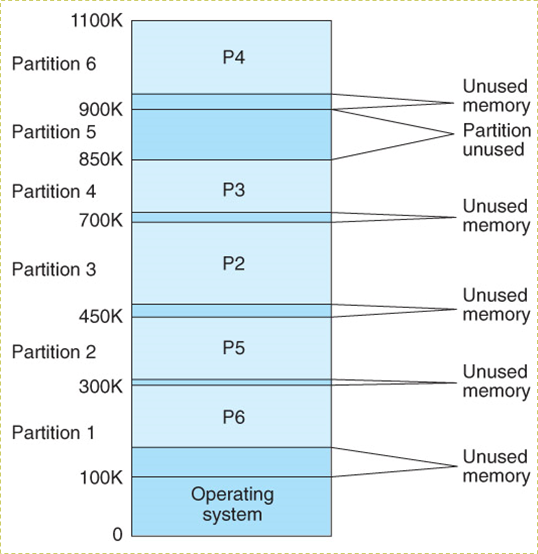

8.3.2 Multiple-partition allocation 多分区分配

分区式管理的基本思想是将内存划分成若干个连续区域,称为分区。每个分区只能存放一个进程

8.3.2.1 Fixed Partitioning 固定分区

- 预先将内存空间切分成多个分区,当进程需要分区时,将一个大小匹配的分区分配给它

8.3.2.2 Dynamic Partitions 动态分区

动态划分内存,在程序装入内存时把可用内存“切出”一个连续的区域分配给该进程,且分区大小正好适合进程的需要

操作系统需要维护的信息包括:

- allocated partitions 已分配的分区

- free partitions (hole) 空闲的分区

如何满足free holes列表中大小为n的请求

First-Fit:找到第一个能够满足要求的hole

Best-Fit:找到能够满足要求的、最小的hole

Worst-Fit:找到能够满足要求的、最大的hole

Next-Fit:从上次查找结束的地方开始,找到第一个能够满足要求的hole

8.3.3 Fragmentation 碎片

内存因碎片而浪费,这可能会导致性能问题

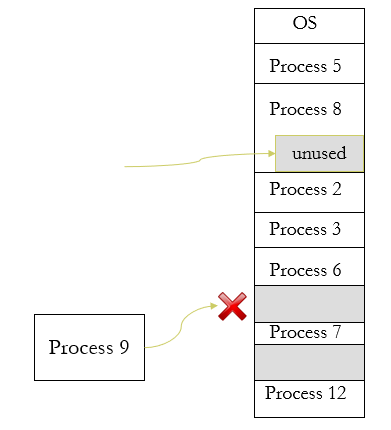

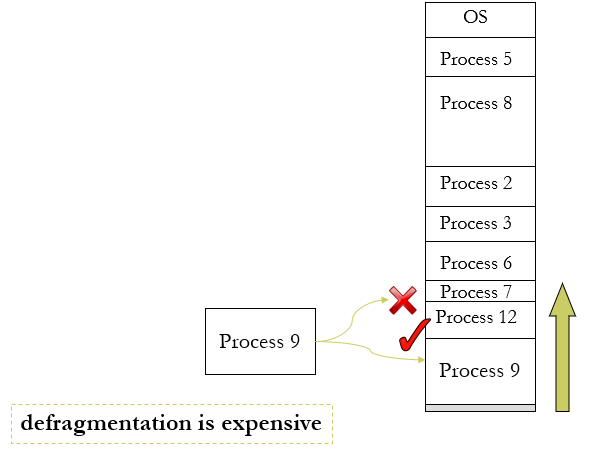

- Internal fragmentation(内碎片、内零头):在单个进程内存空间中浪费内存

- External fragmentation(外碎片、外零头):可能会减少可运行进程的数量

- 总内存剩余空间可以满足要求,但由于内存空间不连续,导致程序不能运行

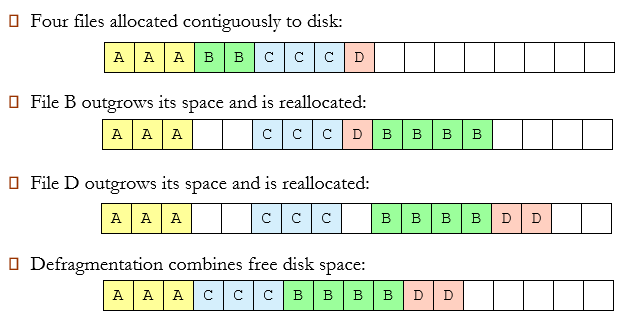

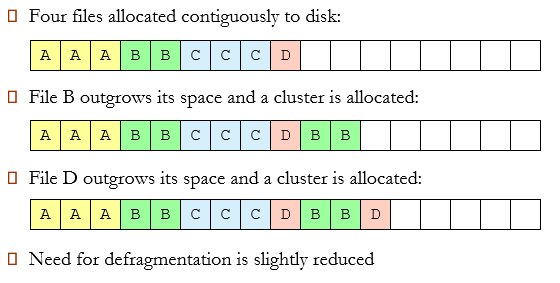

通过压缩或整理碎片减少外部碎片(compaction or defragmentation )

- 重新排列内存内容,将所有可用内存块组织在一个大块中

- 只有当重新定位是动态的并且在执行时完成时,才能进行压缩

8.4 Paging 分页,页式存储管理

8.4.1 Paging

- 进程的物理地址空间可能是不连续的;只要物理内存可用,就为进程分配物理内存

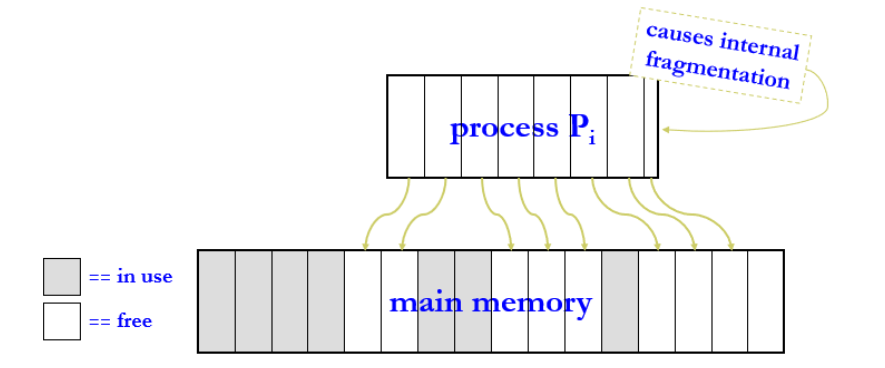

- 将物理内存划分为固定大小的块,称为frames(帧、物理块、页框)

- 大小为2的整数次幂,介于512 bytes和8192 bytes之间

- Linux、Windows for x86:4K

- 将逻辑内存分成与帧大小相同的块,称为pages(页)

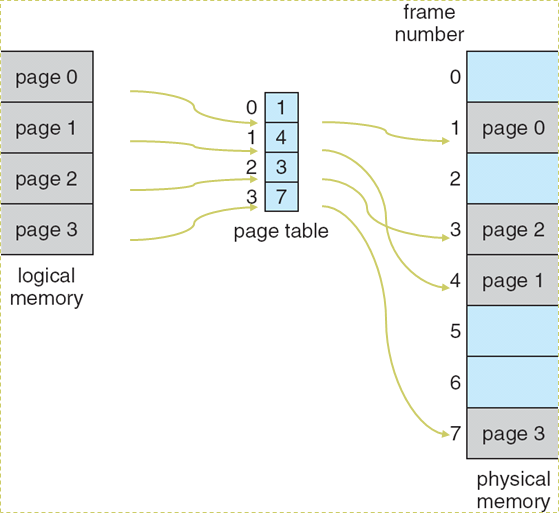

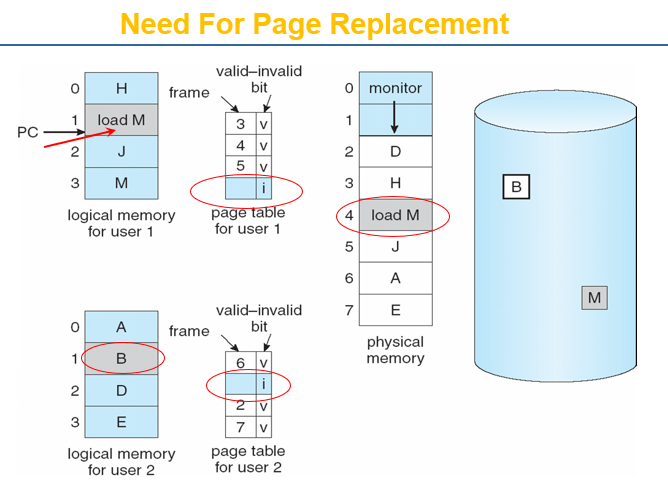

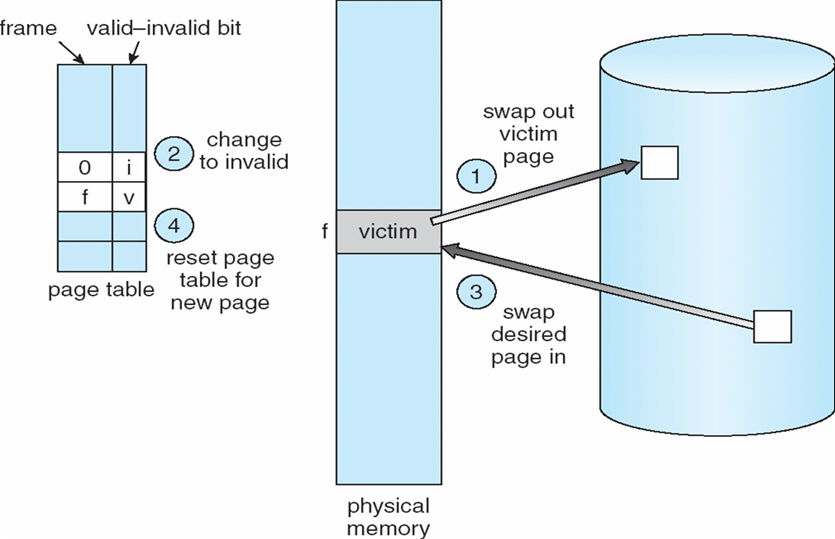

- 使用paging的模式

- 跟踪所有空闲帧

- 要运行n pages大小的程序,需要找到n个空闲的frames,然后加载程序

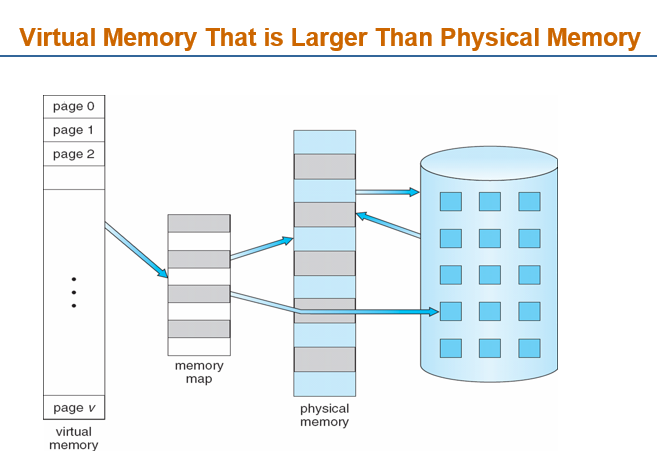

- 如果找不到,可以使用swap技术,将一部分程序放进内存,另一部分程序放入swap区

- 设置page table(页表),将逻辑地址转换为物理地址

- page table 列出了进程的逻辑页与其在主存中的物理帧间的对应关系

- 会存在Internal fragmentation

8.4.2 Noncontiguous Allocation 非连续内存分配

- 当一个进程需要n个page运行时,操作系统会找到n个空闲的frame

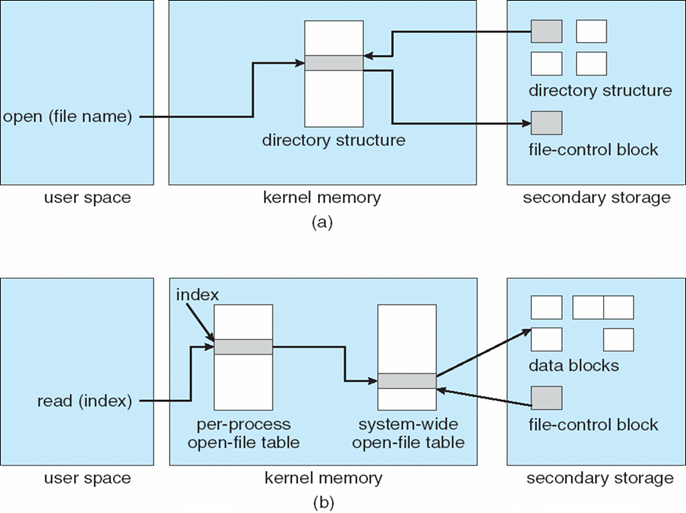

- 操作系统通过一个page table,跟踪页的使用

- 一般情况下,最后一个page都无法用满,但是系统依旧会给它分配一个frame

- 会导致Internal fragmentation

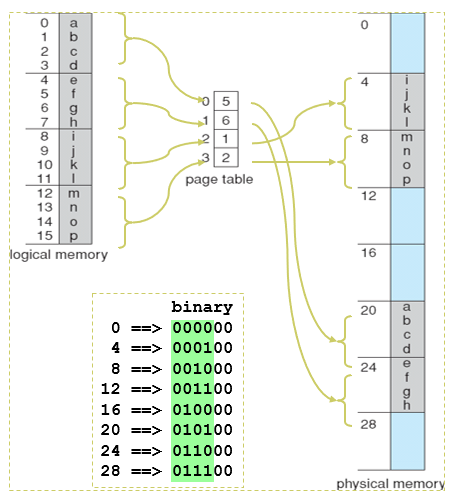

8.4.3 逻辑和物理内存的分页模型

page table将逻辑内存地址映射到物理内存地址

例:进程\(P_i\)需要16字节的逻辑内存

- 逻辑内存通过页面表映射到32字节内存,页面大小为4字节

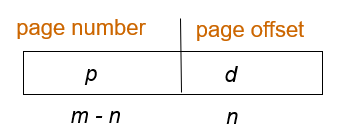

8.4.4 Address Translation Scheme 地址变换

CPU生成的地址分为:

- page number(p)页号:用作页表的索引,该页表包含物理内存中每个页的基地址

- page offset(d)偏移:与基地址相结合以定义发送到存储器单元的物理存储器地址

若page size = 2n,地址空间为 2m,则地址可以分为:

Paging Hardware

页面大小为4KB,虚地址2362H、1565H的物理地址分别是?页表如下

页号 页框 (Page Frame)号 0 101H 1 102H 2 254H - 4KB=1000H

- 逻辑地址2362H对应的页号为2,254000H+362H = 254362H

- 逻辑地址1565H对应的页号为1,102000H+565H = 102565H

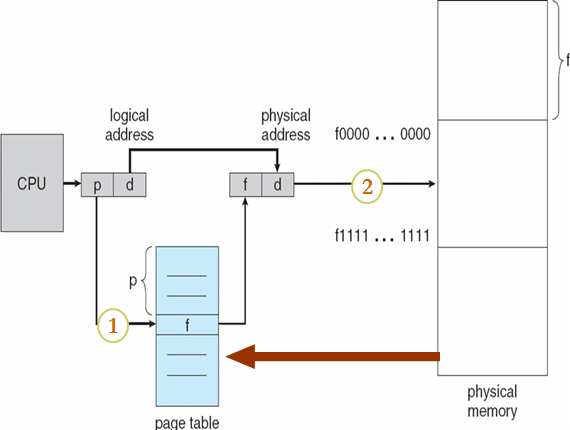

8.4.5 Page Table的实现

- 页表保存在Main Memory中

- 页表基寄存器(PTBR, Page-table base register):指向页表,x86:cr3

- 页表长度寄存器(PTLR, Page-table length register ):表示页表的大小

- 在该方案中,每个数据/指令访问都需要两次memory访问

- 一个用于页表

- 一个用于数据/指令

- 两次内存访问可以通过使用cache来加速,该cache被称为联想寄存器、快表

- associative memory

- TLB:translation look-aside buffers

- 一些TLB在每个TLB条目中存储地址空间标识符(ASID, address-space identifiers):唯一标识每个进程,为该进程提供地址空间保护

8.4.6 Associative Memory

- 并行查找:Address translation(p, d)

- 如果p在Associative Memory中,则取出帧#

- 否则,从内存中的页表获取帧#

8.4.7 Effective Access Time 有效访问时间

- 快表访问时间:Associative Lookup = \(\epsilon\) time unit

- 内存访问时间:memory cycle time = \(t\)

- 命中率:Hit ratio = \(\alpha\)

- 有效访问时间:EAT = \((t+\epsilon)\alpha+(t+t+\epsilon)(1-\alpha)\)

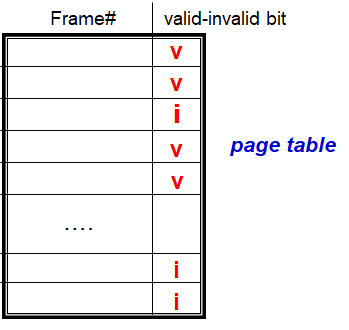

8.4.8 Memory Protection 内存保护

- 通过将保护位与每个帧相关联来实现内存保护

- Valid-invalid bit 附加到页表中每个条目:

- “valid”表示关联页面位于进程的逻辑地址空间中,因此是合法页面

- “invalid”表示页面不在进程的逻辑地址空间中

8.4.9 共享页面

- 共享代码

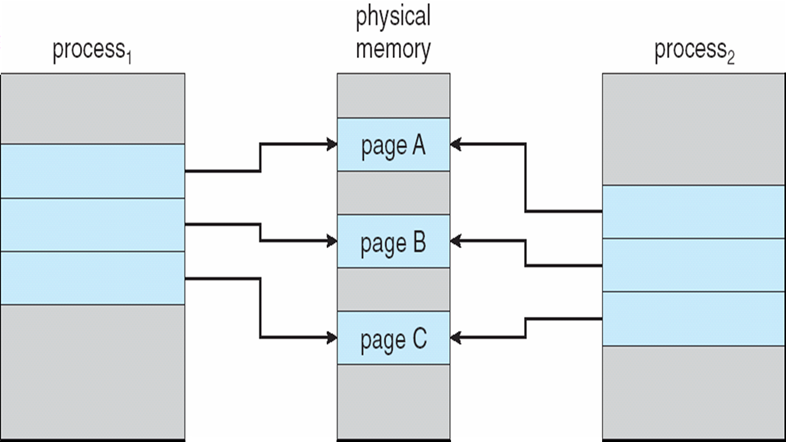

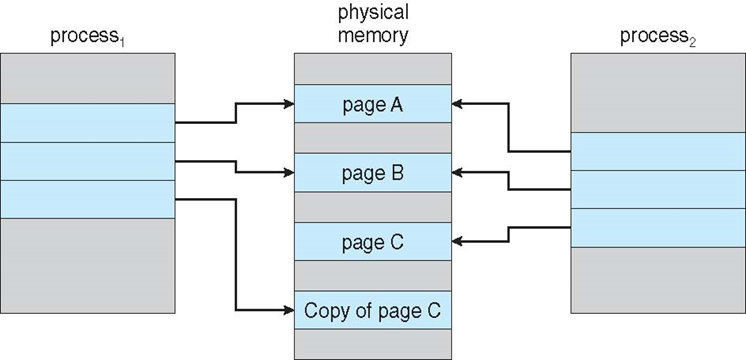

- 进程之间共享的只读代码的一个副本。

- 共享代码必须出现在所有进程的逻辑地址空间中的同一位置

- 私有代码和数据

- 每个进程都保留代码和数据的单独副本

- 私有代码和数据的页面可以出现在逻辑地址空间的任何位置

- 重新输入代码(重入代码)、 纯代码(纯代码)

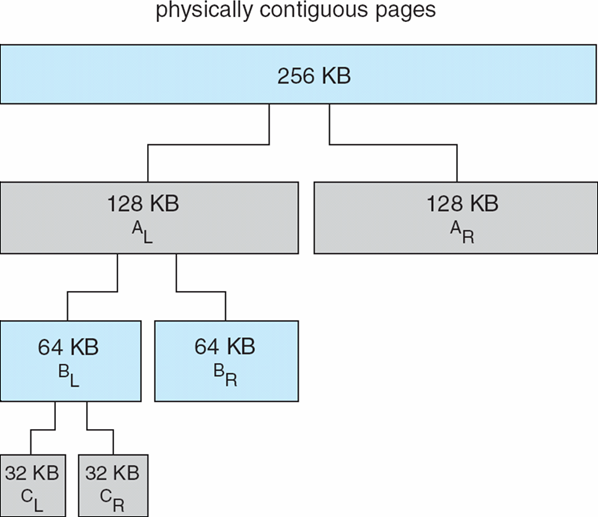

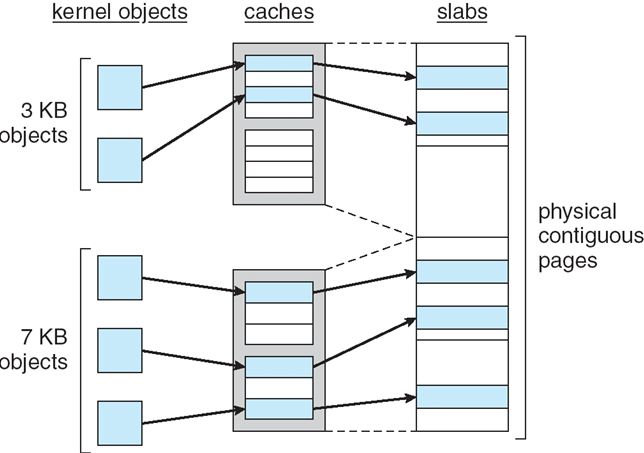

8.4.10 Page Table的数据结构

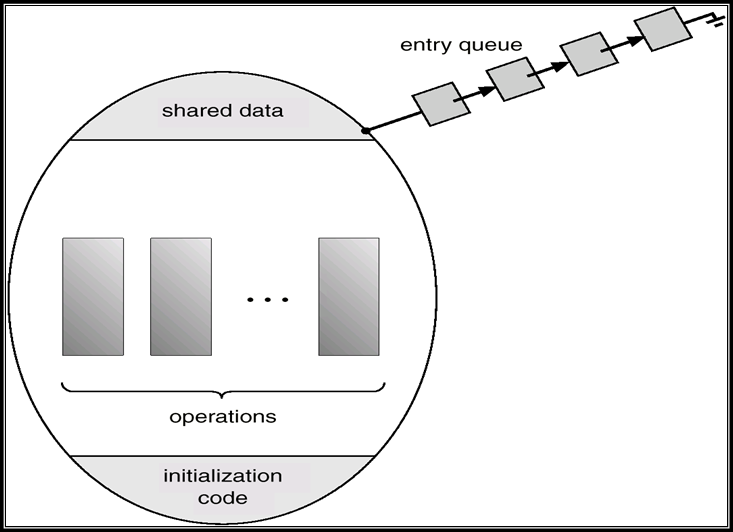

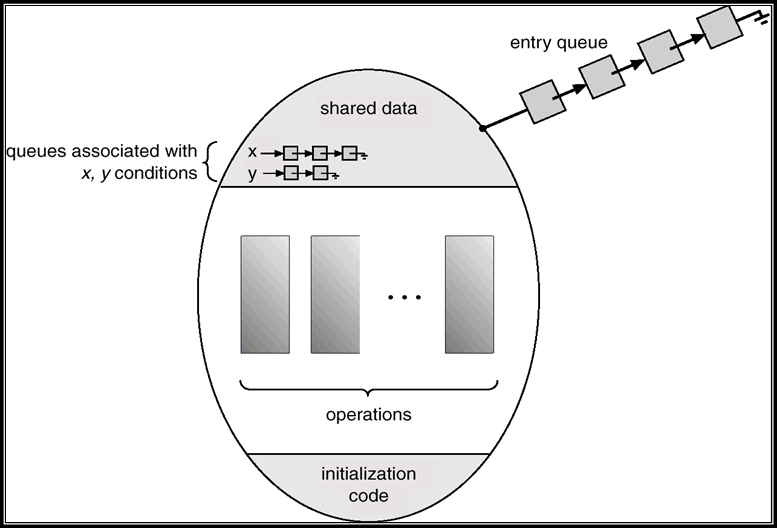

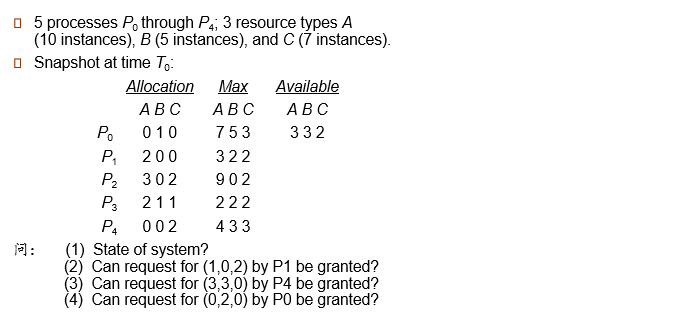

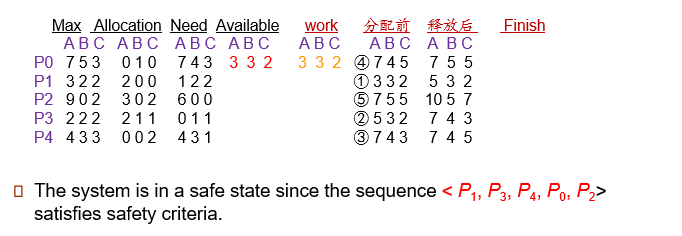

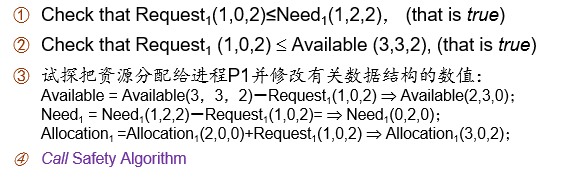

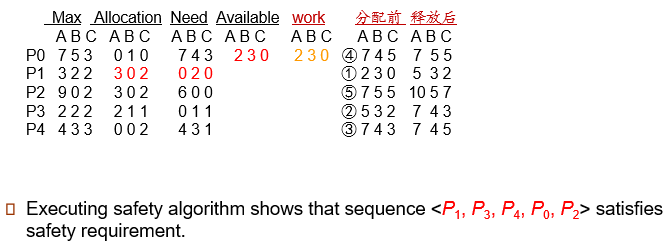

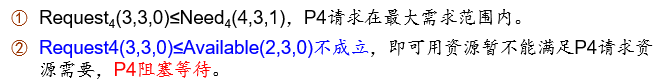

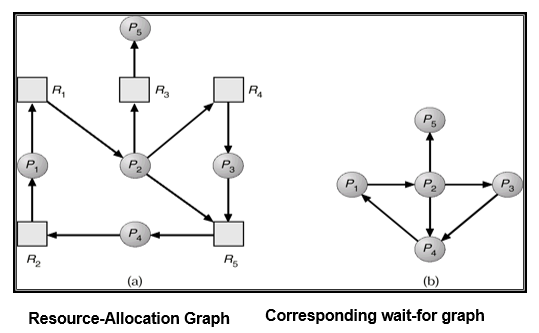

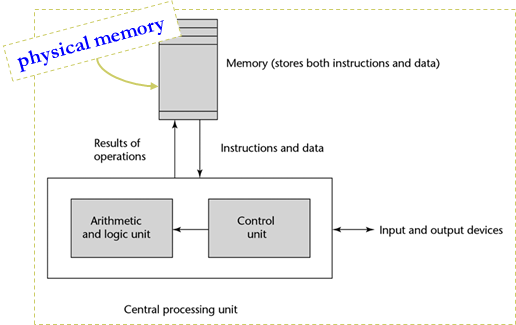

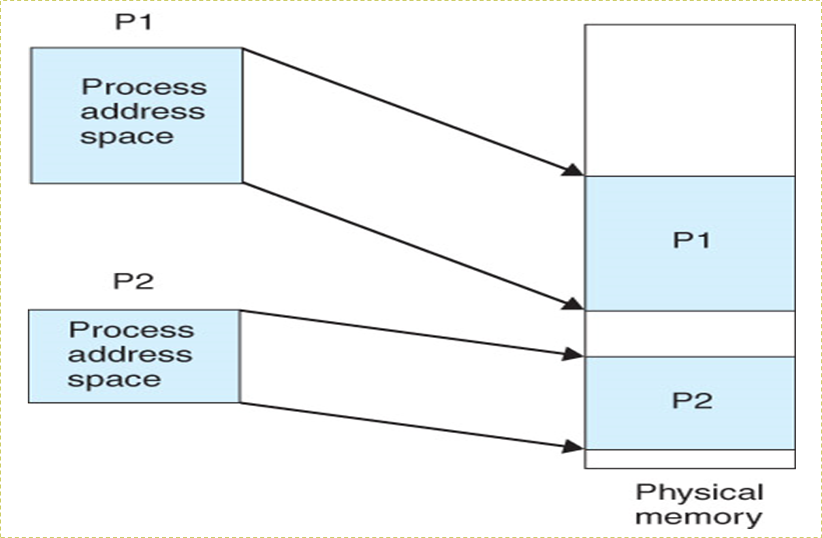

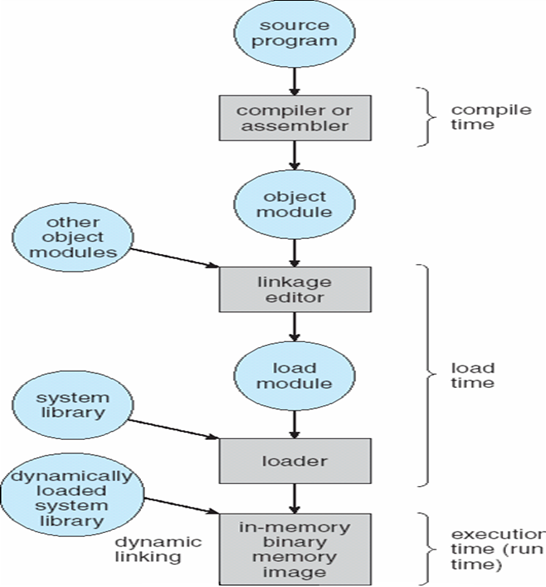

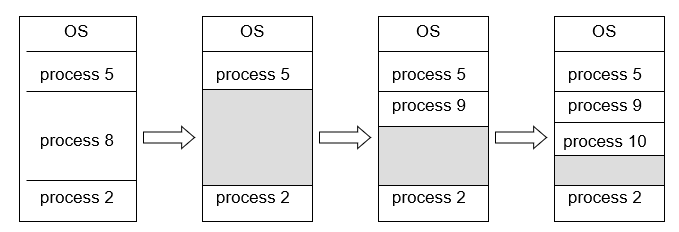

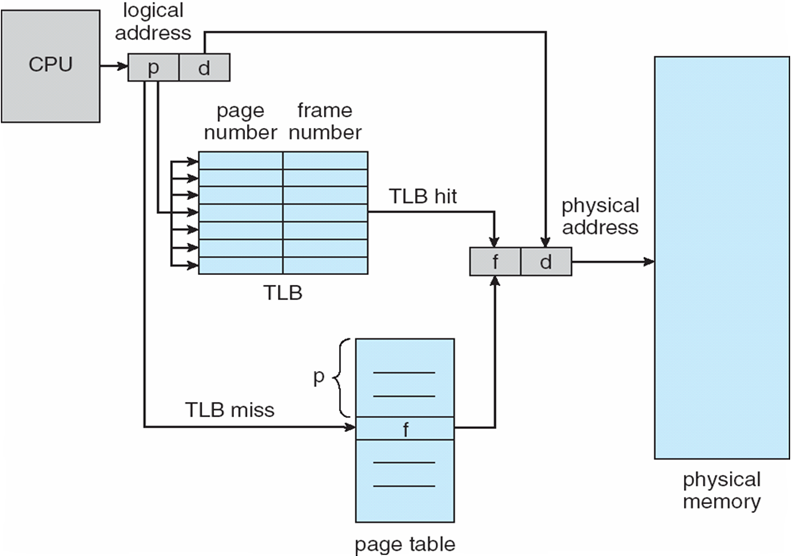

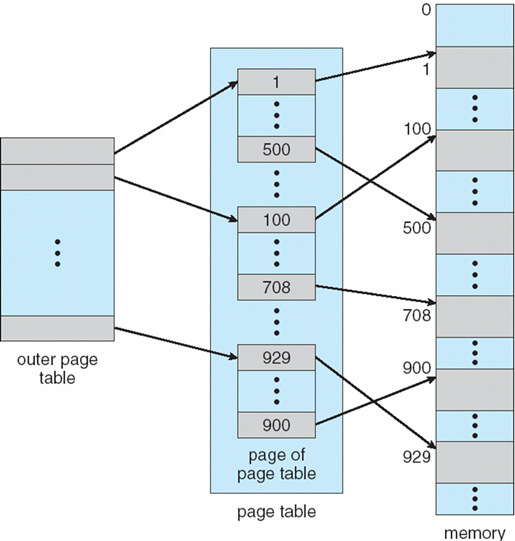

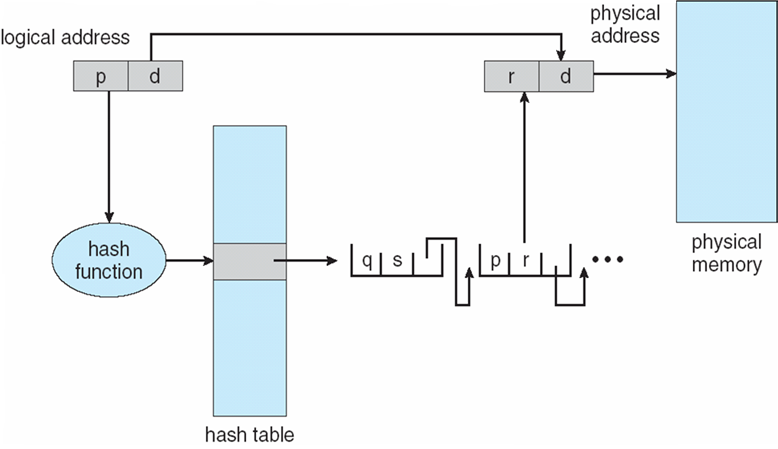

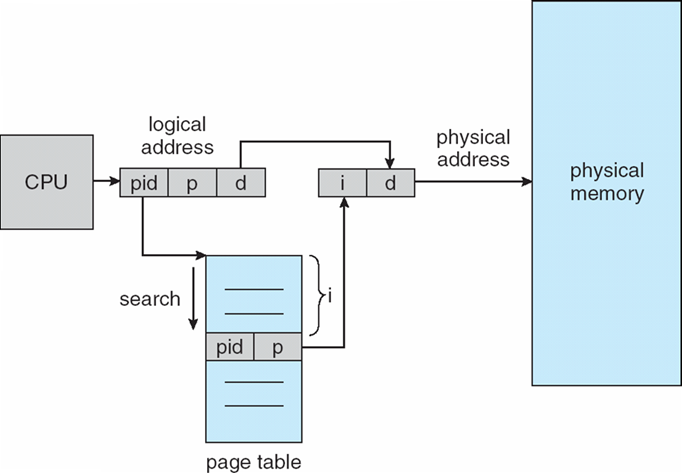

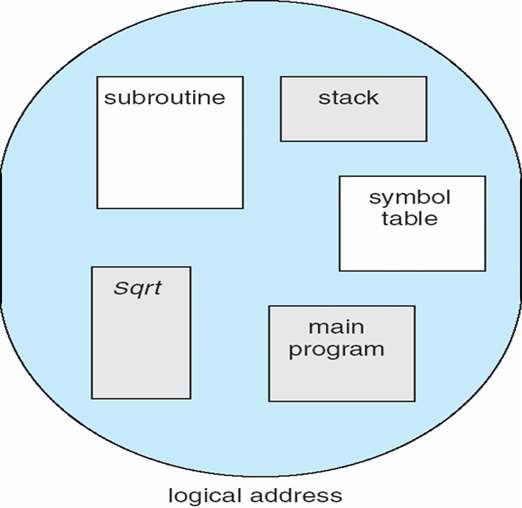

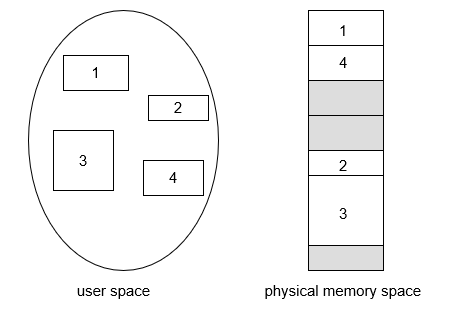

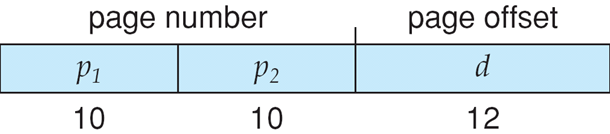

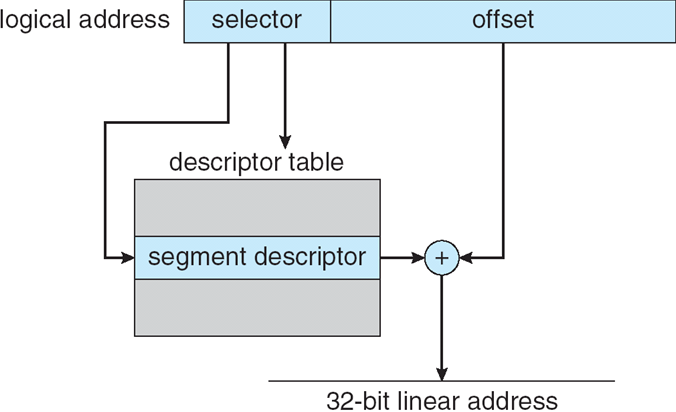

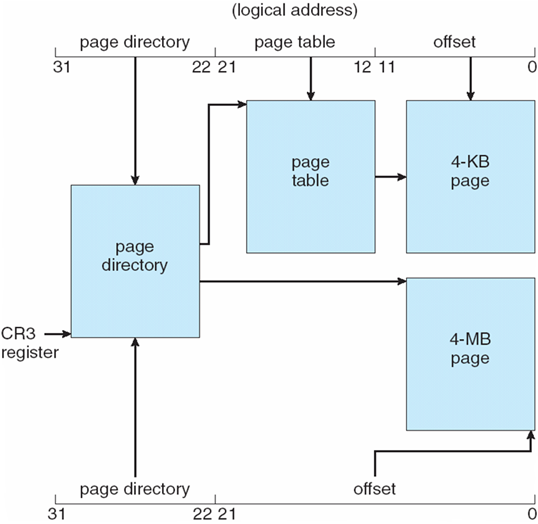

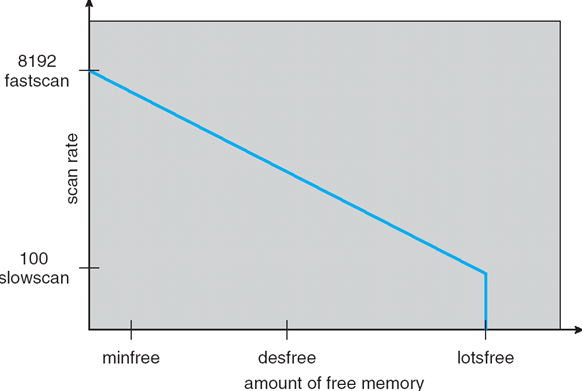

8.4.10.1 分级页表 Hierarchical Paging